ChatBot-Cina/chatbot Cina

- Penulis telah sepenuhnya ditransfer ke

Grafik GNN arah jaringan saraf Pengembangan C++ tidak lagi menindaklanjuti NLP, dan kode proyek tidak lagi dipertahankan. Ketika proyek Yuanxiang selesai, hanya ada sedikit sumber daya online. Penulis pertama kali berhubungan dengan NLP dan Deep Learning. Mengatasi banyak kesulitan, dia akhirnya menulis Model Mainan ini. Oleh karena itu, penulis tahu bahwa ini tidak mudah bagi pemula, jadi meskipun proyek tidak lagi dipertahankan, masalah atau email ([email protected]) akan ditanggapi tepat waktu untuk membantu pendatang baru di Deep Learning. (Versi Tensorflow yang saya gunakan sudah terlalu lama. Jika langsung menjalankan versi baru pasti akan mendapatkan berbagai error. Jika menemui kesulitan, jangan repot-repot menginstal lingkungan versi lama. Disarankan menggunakan Pytorch untuk merekonstruksinya sesuai dengan logika pemrosesan saya. Saya terlalu malas untuk menulis)

- Aspek GNN:

- Serangkaian model perbandingan benchmark: GNNs-Baseline telah diadaptasi dan disusun untuk memfasilitasi verifikasi ide secara cepat.

- Kode sumber terbuka makalah saya ACMMM 2023 (CCF-A) ada di sini LSTGM.

- Kode sumber terbuka makalah saya ICDM 2023 (CCF-B) masih dalam proses kompilasi. . . GRN

- Rekan-rekan dipersilakan untuk menambah, berkomunikasi, dan belajar.

Konfigurasi lingkungan

| program | Versi |

|---|

| ular piton | 3.68 |

| aliran tensor | 1.13.1 |

| keras | 2.2.4 |

| jendela10 | |

| jupyter | |

Bahan referensi utama

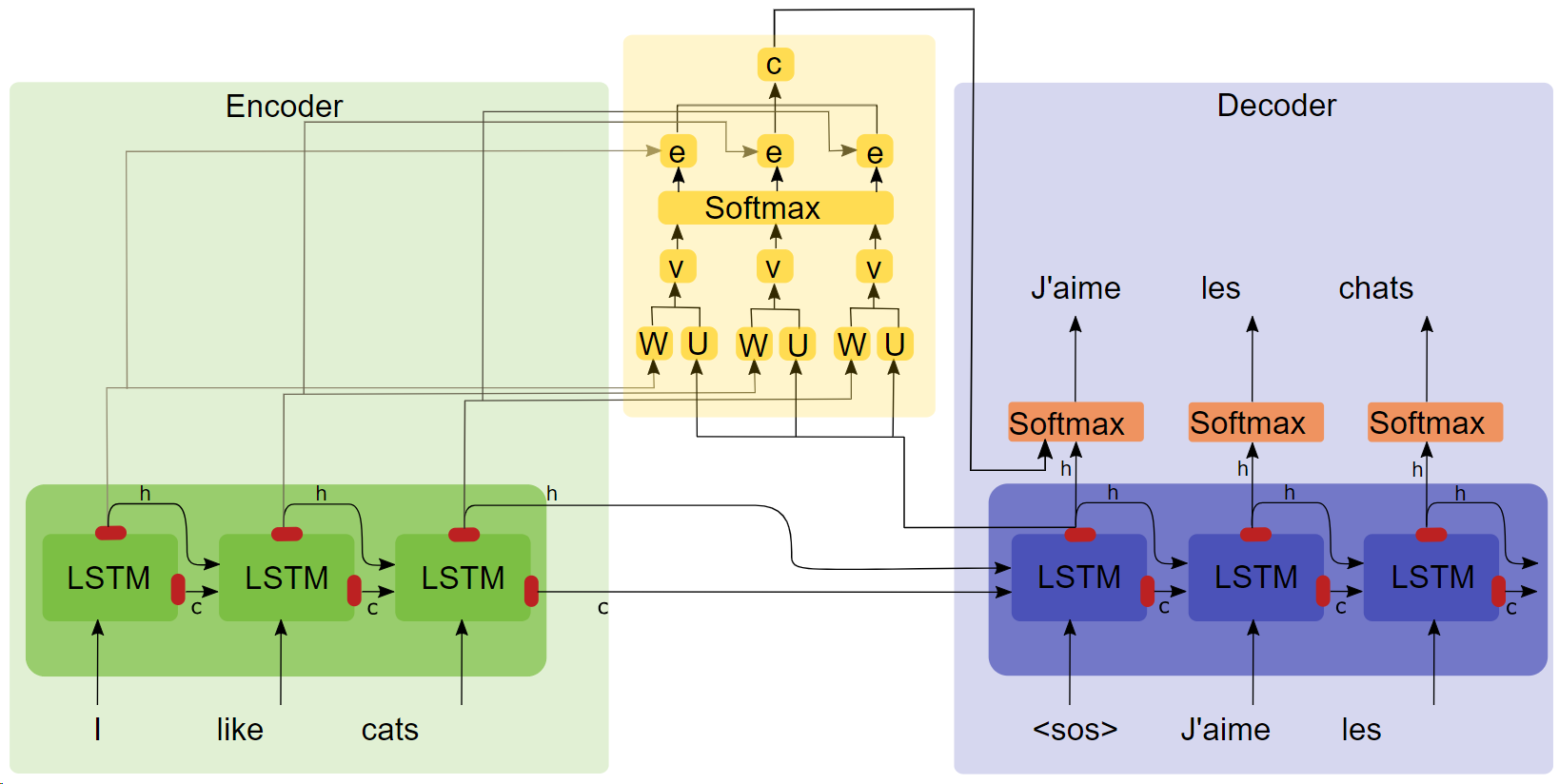

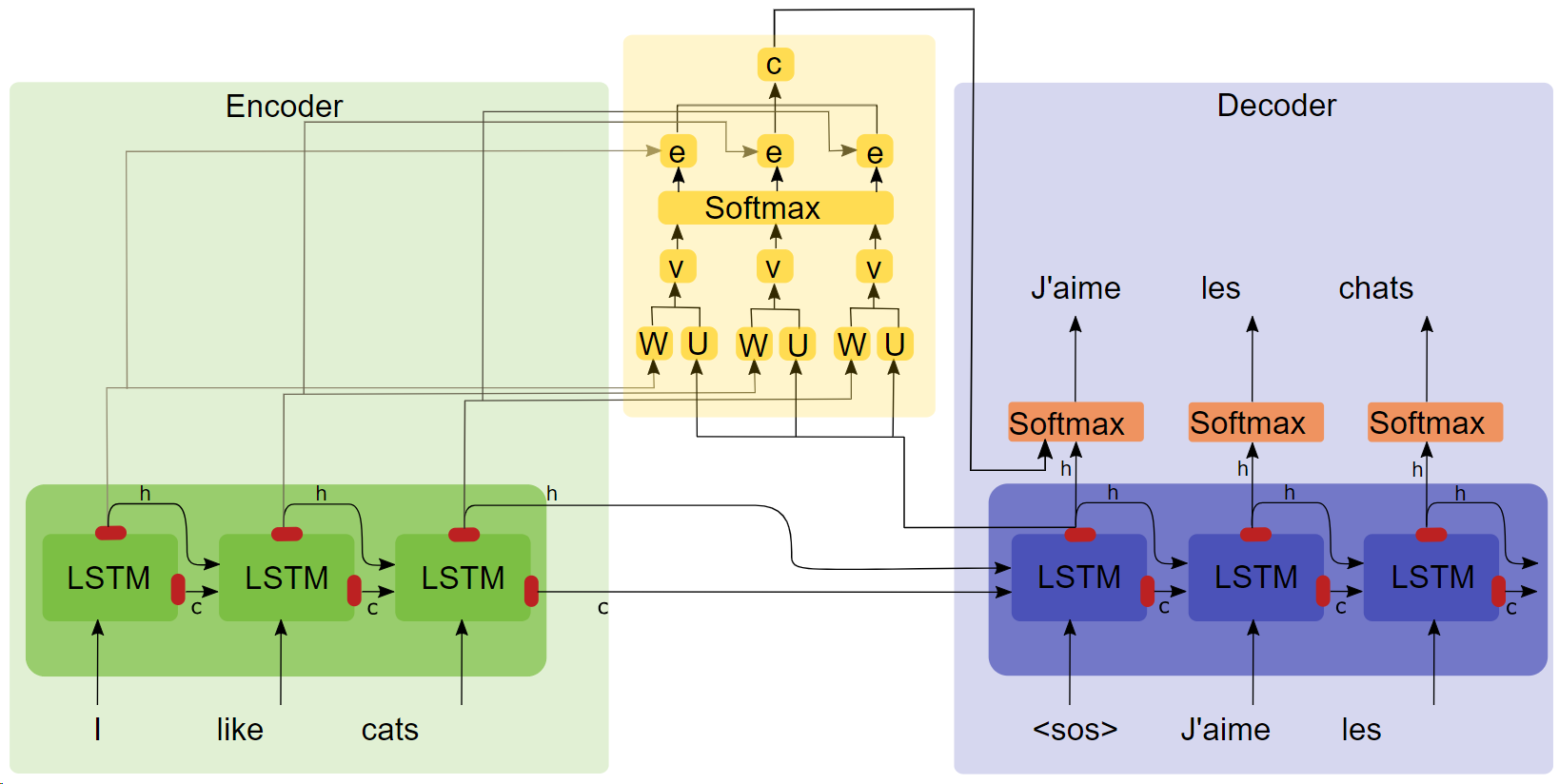

- Tesis “TERJEMAHAN MESIN SARAF DENGAN BERSAMA-SAMA BELAJAR MENYELURUHKAN DAN MENERJEMAHKAN ( Klik pada judul untuk mendownload )”

- Diagram struktur perhatian

Poin-poin penting

- LSTM

- seq2seq

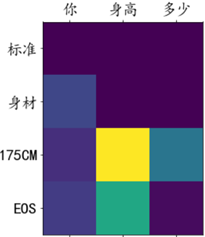

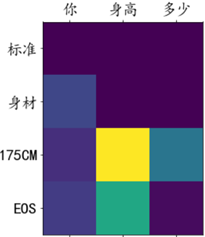

- Eksperimen perhatian menunjukkan bahwa setelah menambahkan mekanisme perhatian, kecepatan pelatihan lebih cepat, konvergensi lebih cepat, dan efeknya lebih baik.

Corpus dan lingkungan pelatihan

100.000 kelompok dialog dari korpus Qingyun, dilatih dalam kolaborasi Google.

berlari

Metode 1: Selesaikan proses

- Pemrosesan awal data

get_data

- Pelatihan model

chatbot_train (Ini adalah versi yang dipasang ke google colab, jalur lari lokal perlu sedikit dimodifikasi)

- Prediksi model

chatbot_inference_Attention

Metode 2: Muat model yang sudah ada

- Jalankan

chatbot_inference_Attention

- Memuat

models/W--184-0.5949-.h5

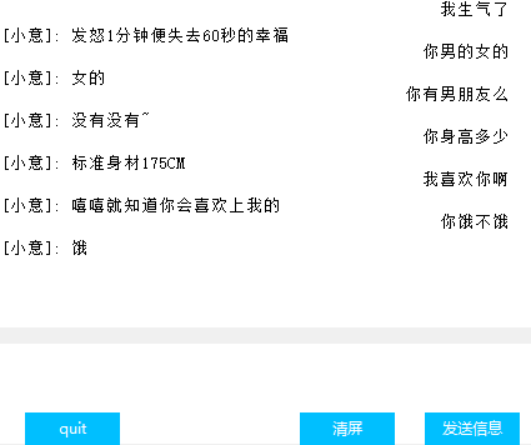

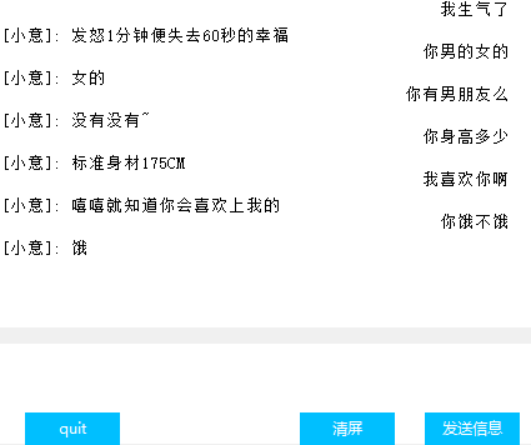

Antarmuka (Tkinter)

Visualisasi bobot perhatian

lainnya

- Dalam file pelatihan chat_bot, dua blok kode pertama dari tiga blok terakhir digunakan untuk memasang Google Cloud Disk, dan yang terakhir digunakan untuk mendapatkan kerugian tersebut untuk memfasilitasi menggambar tidak berhasil, jadi saya membuat strategi ini;

- Blok kode kedua dari belakang dalam file prediksi hanya memiliki input teks tetapi tidak memiliki antarmuka. Blok kode terakhir adalah antarmuka. Salah satu dari dua blok dapat langsung dijalankan sesuai kebutuhan;

- Ada banyak keluaran perantara dalam kode ini, saya harap ini membantu Anda memahami kodenya;

- Ada model yang telah saya latih dalam model. Seharusnya tidak ada masalah dalam pengoperasian normal.

- Penulis memiliki kemampuan terbatas dan belum menemukan indikator untuk mengukur efek dialog, sehingga kerugian hanya mencerminkan kemajuan pelatihan secara kasar.