??Cina |

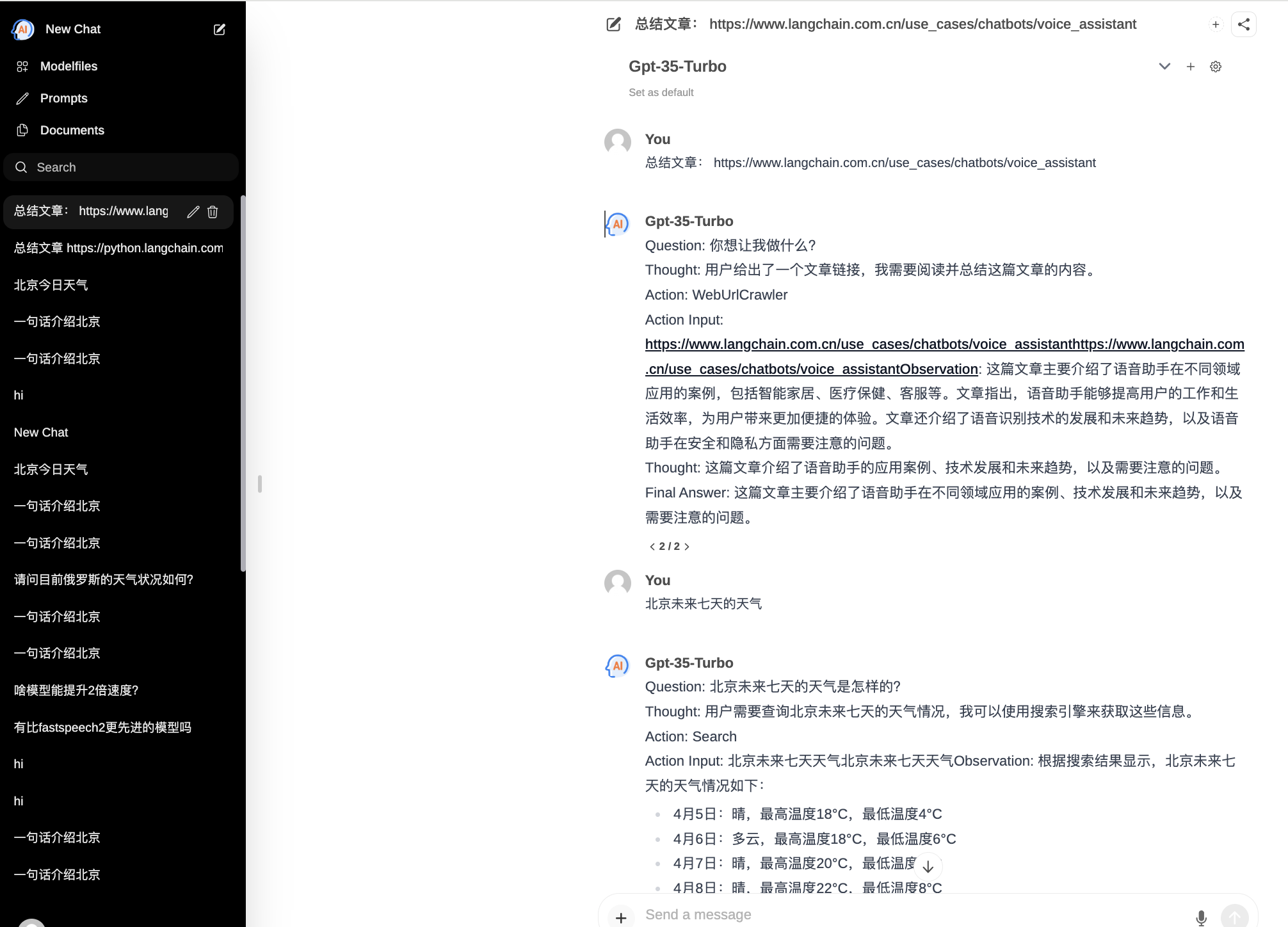

ChatPilot : WebUI Agen Obrolan, mengimplementasikan dialog AgentChat, mendukung pencarian Google, dialog URL file (RAG), fungsi penerjemah kode, mereproduksi Kimi Chat (file, seret masuk; URL, kirim), mendukung OpenAI/Azure API.

Demo Resmi: https://chat.mulanai.com

export OPENAI_API_KEY=sk-xxx

export OPENAI_BASE_URL=https://xxx/v1

docker run -it

-e OPENAI_API_KEY= $WORKSPACE_BASE

-e OPENAI_BASE_URL= $OPENAI_BASE_URL

-e RAG_EMBEDDING_MODEL= " text-embedding-ada-002 "

-p 8080:8080 --name chatpilot- $( date +%Y%m%d%H%M%S ) shibing624/chatpilot:0.0.1Anda akan menemukan ChatPilot berjalan di http://0.0.0.0:8080 Selamat menikmati!

git clone https://github.com/shibing624/ChatPilot.git

cd ChatPilot

pip install -r requirements.txt

# Copying required .env file, and fill in the LLM api key

cp .env.example .env

bash start.shOke, sekarang aplikasi Anda sedang berjalan: http://0.0.0.0:8080 Selamat menikmati!

Dua cara untuk membangun front end:

git clone https://github.com/shibing624/ChatPilot.git

cd ChatPilot/

# Building Frontend Using Node.js >= 20.10

cd web

npm install

npm run build Keluaran: Direktori web proyek mengeluarkan folder build , yang berisi file keluaran kompilasi front-end.

export OPENAI_API_KEY=xxx

export OPENAI_BASE_URL=https://api.openai.com/v1

export MODEL_TYPE= " openai " export AZURE_OPENAI_API_KEY=

export AZURE_OPENAI_API_VERSION=

export AZURE_OPENAI_ENDPOINT=

export MODEL_TYPE= " azure " Mulai layanan ollama dengan ollama serve , lalu konfigurasikan OLLAMA_API_URL : export OLLAMA_API_URL=http://localhost:11413

litellm : pip install litellm -U File konfigurasi litellm default chatpilot ada di ~/.cache/chatpilot/data/litellm/config.yaml

Ubah isinya sebagai berikut:

model_list :

# - model_name: moonshot-v1-auto # show model name in the UI

# litellm_params: # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

# model: openai/moonshot-v1-auto # MODEL NAME sent to `litellm.completion()` #

# api_base: https://api.moonshot.cn/v1

# api_key: sk-xx

# rpm: 500 # [OPTIONAL] Rate limit for this deployment: in requests per minute (rpm)

- model_name : deepseek-ai/DeepSeek-Coder # show model name in the UI

litellm_params : # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

model : openai/deepseek-coder # MODEL NAME sent to `litellm.completion()` #

api_base : https://api.deepseek.com/v1

api_key : sk-xx

rpm : 500

- model_name : openai/o1-mini # show model name in the UI

litellm_params : # all params accepted by litellm.completion() - https://docs.litellm.ai/docs/completion/input

model : o1-mini # MODEL NAME sent to `litellm.completion()` #

api_base : https://api.61798.cn/v1

api_key : sk-xxx

rpm : 500

litellm_settings : # module level litellm settings - https://github.com/BerriAI/litellm/blob/main/litellm/__init__.py

drop_params : True

set_verbose : False

Jika Anda menggunakan ChatPilot dalam penelitian Anda, harap kutip dalam format berikut:

APA:

Xu, M. ChatPilot: LLM agent toolkit (Version 0.0.2) [Computer software]. https://github.com/shibing624/ChatPilotBibTeX:

@misc{ChatPilot,

author = {Ming Xu},

title = {ChatPilot: llm agent},

year = {2024},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = { url {https://github.com/shibing624/ChatPilot}},

}Perjanjian lisensinya adalah The Apache License 2.0, yang gratis untuk penggunaan komersial. Harap lampirkan tautan ke ChatPilot dan perjanjian lisensi di deskripsi produk.

Kode proyek masih sangat kasar. Jika Anda memiliki perbaikan pada kode tersebut, Anda dipersilakan untuk mengirimkannya kembali ke proyek ini. Sebelum mengirimkan, harap perhatikan dua poin berikut:

testspython -m pytest -v untuk menjalankan semua pengujian unit guna memastikan bahwa semua pengujian unit lulusAnda kemudian dapat mengirimkan PR.