Melayani

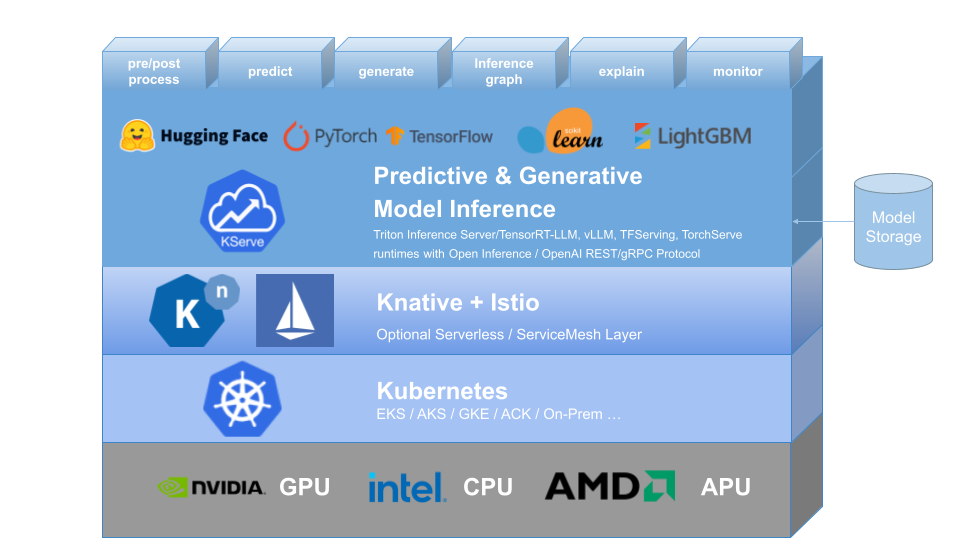

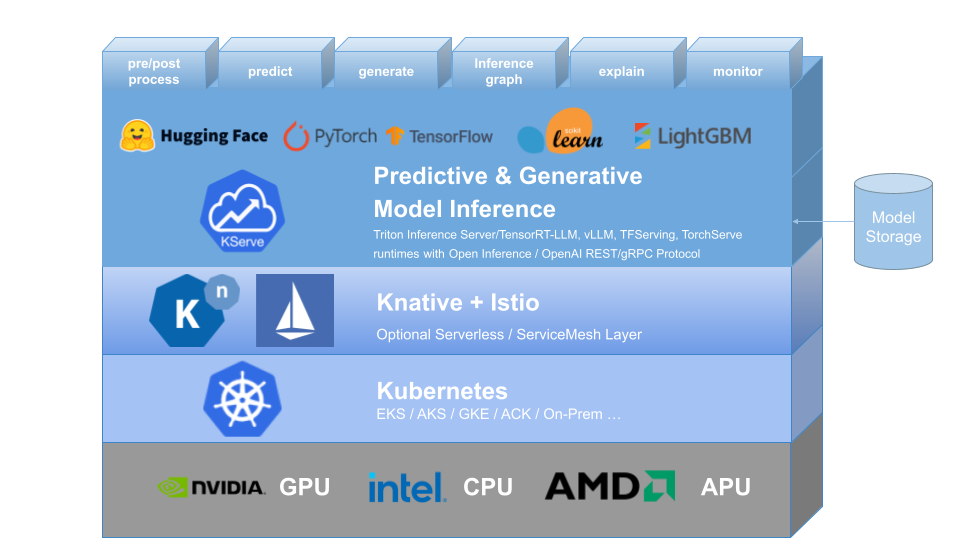

KServe menyediakan Definisi Sumber Daya Kustom Kubernetes untuk menyajikan model pembelajaran mesin (ML) prediktif dan generatif. Hal ini bertujuan untuk menyelesaikan kasus penggunaan penyajian model produksi dengan menyediakan antarmuka abstraksi tinggi untuk model Tensorflow, XGBoost, ScikitLearn, PyTorch, Huggingface Transformer/LLM menggunakan protokol bidang data standar.

Ini merangkum kompleksitas penskalaan otomatis, jaringan, pemeriksaan kesehatan, dan konfigurasi server untuk menghadirkan fitur penyajian terdepan seperti Penskalaan Otomatis GPU, Scale to Zero, dan Canary Rollouts ke penerapan ML Anda. Hal ini memungkinkan cerita yang sederhana, dapat dicolokkan, dan lengkap untuk Penyajian ML Produksi termasuk prediksi, pra-pemrosesan, pasca-pemrosesan, dan kemampuan menjelaskan. KServe digunakan di berbagai organisasi.

Untuk lebih jelasnya, kunjungi situs web KServe.

KFServing telah berganti nama menjadi KServe sejak v0.7.

Mengapa KServe?

- KServe adalah Platform Inferensi Model cloud agnostic standar untuk menyajikan model AI prediktif dan generatif di Kubernetes, yang dibuat untuk kasus penggunaan yang sangat skalabel.

- Menyediakan protokol inferensi terstandarisasi yang berkinerja baik di seluruh kerangka kerja ML termasuk spesifikasi OpenAI untuk model generatif.

- Mendukung beban kerja inferensi tanpa server modern dengan penskalaan otomatis berbasis permintaan termasuk skala ke nol pada CPU dan GPU .

- Memberikan skalabilitas tinggi, pengepakan kepadatan, dan perutean cerdas menggunakan ModelMesh .

- Produksi sederhana dan dapat dicolokkan yang berfungsi untuk inferensi , pemrosesan pra/pasca , pemantauan , dan penjelasan .

- Penerapan tingkat lanjut untuk peluncuran canary , pipeline , ansambel dengan InferenceGraph .

Pelajari Lebih Lanjut

Untuk mempelajari lebih lanjut tentang KServe, cara menggunakan berbagai fitur yang didukung, dan cara berpartisipasi dalam komunitas KServe, silakan ikuti dokumentasi situs web KServe. Selain itu, kami telah menyusun daftar presentasi dan demo untuk mendalami berbagai detail.

Instalasi

Instalasi Mandiri

- Instalasi Tanpa Server : KServe secara default menginstal Knative untuk penerapan tanpa server untuk InferenceService.

- Instalasi Penerapan Mentah : Dibandingkan dengan Instalasi Tanpa Server, ini adalah instalasi yang lebih ringan . Namun, opsi ini tidak mendukung penerapan canary dan penskalaan otomatis berbasis permintaan dengan skala ke nol.

- Instalasi ModelMesh : Anda dapat menginstal ModelMesh secara opsional untuk mengaktifkan kasus penggunaan penyajian model berskala tinggi , berkepadatan tinggi , dan sering berubah .

- Instalasi Cepat : Instal KServe di mesin lokal Anda.

Instalasi Kubeflow

KServe adalah komponen tambahan penting dari Kubeflow, silakan pelajari lebih lanjut dari dokumentasi Kubeflow KServe. Lihat panduan berikut untuk menjalankan di AWS atau di OpenShift Container Platform.

? Buat InferenceService pertama Anda

Peta jalan

Referensi API InferenceService

? Panduan Pengembang

✍️ Panduan Kontributor

? Pengadopsi