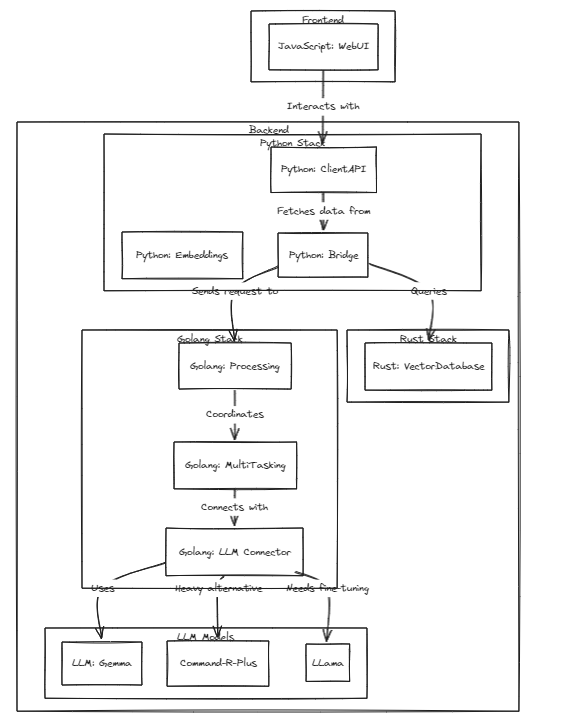

Proyek ini menunjukkan kelayakan LLM yang dipersonalisasi (atau LMM) sebagai asisten pribadi, sejalan dengan pesatnya pertumbuhan model ini.

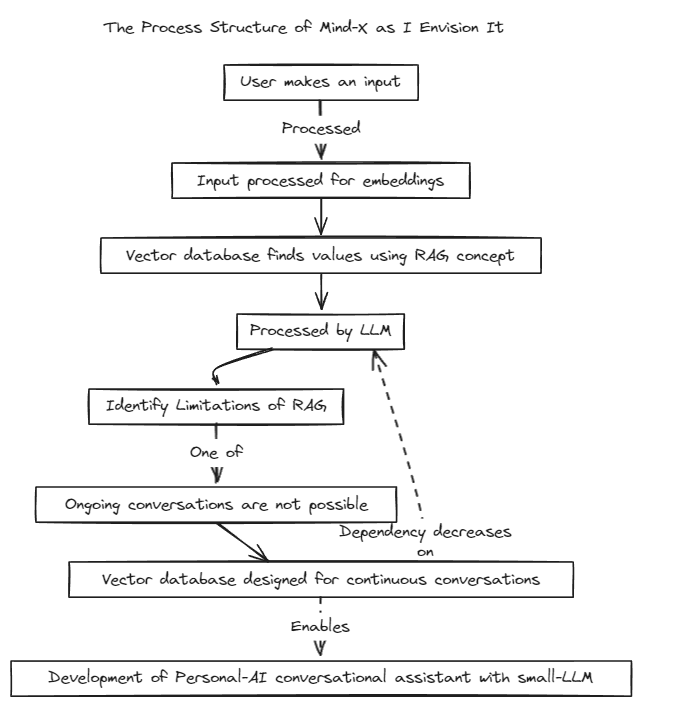

Kami telah memperkenalkan metode Retrieval-Augmented Generation (RAG) untuk mengatasi keterbatasan dari Prompt-Tuning tradisional, yang memiliki batasan konteks, dan Fine-Tuning, yang mengalami masalah dengan pembaruan data real-time dan halusinasi.

Secara tradisional, RAG telah digunakan untuk mencari database seperti Chroma melalui LangChain sebagai penyimpanan, tetapi metode ini beroperasi dalam konteks tetap, yang membatasinya.

Oleh karena itu, kami berencana untuk membangun sistem RAG kami sendiri. Proses ini mungkin melibatkan penanganan masalah inferensi dan regresi yang mungkin ditawarkan LangChain.

Kami berkomitmen terhadap perkembangan pesat dan akan segera mengaktifkan kompatibilitas multibahasa. Saat ini, sistem sepenuhnya mendukung bahasa Inggris, dan berencana untuk segera mendukung bahasa Korea, Jepang, dan bahasa lainnya. Selain itu, sistem regresi dan inferensi juga akan segera diterapkan.

Untuk menjalankan tes, jalankan perintah berikut

# start embeddings server

cd embd & pip install -r requirements.txt

python app.py

# start mindx-v server (vector-database)

# not using cgo, only assembly

cd mindx-v & go run cmd/mxvd/main.go

# start processor server

cd processor & go run cmd/main.go

# start demo client

cd sample_client & npm start

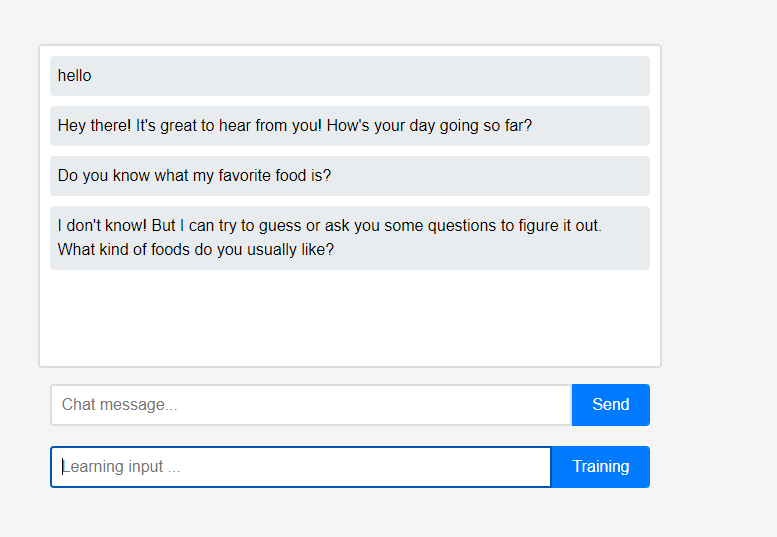

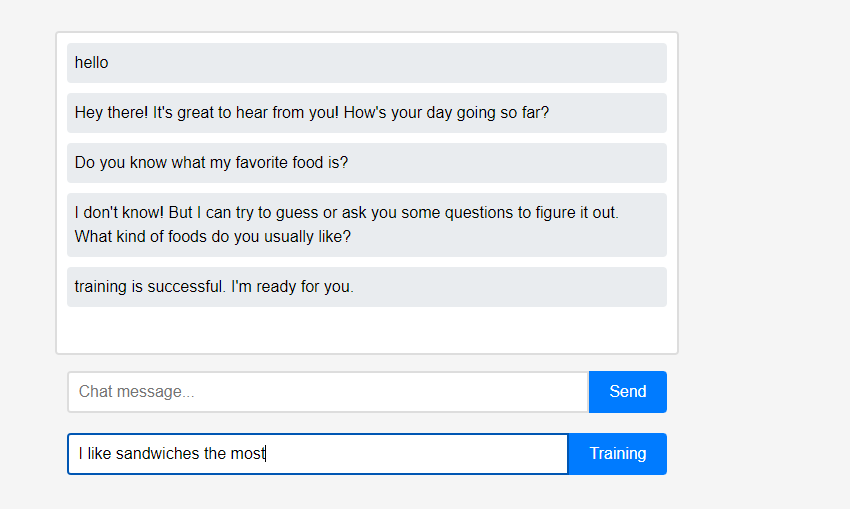

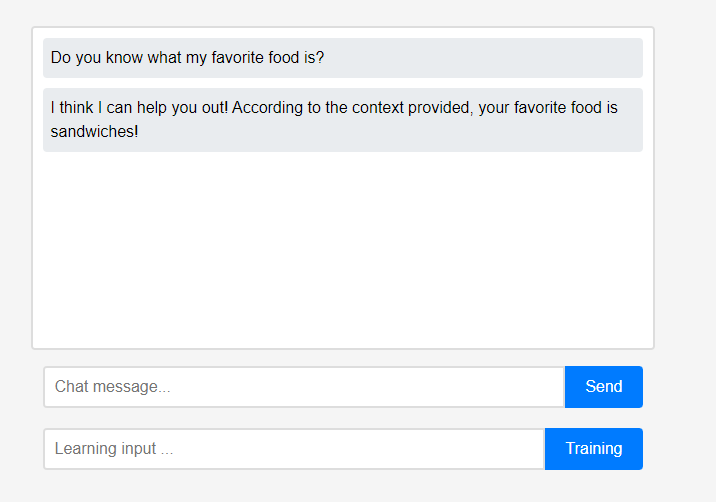

Awalnya, asisten tidak tahu apa-apa tentang pengguna.

Awalnya, asisten tidak tahu apa-apa tentang pengguna. Namun, pengguna dapat mengajari asisten tentang diri mereka sendiri secara real-time.

Namun, pengguna dapat mengajari asisten tentang diri mereka sendiri secara real-time. (Karena karakteristik LLM, dapat disalahpahami bahwa ini diingat sebagai rantai percakapan daripada pembelajaran, sehingga dilakukan setelah penyegaran.) Data yang dipelajari segera direfleksikan, dan ini dapat dilihat sebagai personalisasi pertama asisten.

(Karena karakteristik LLM, dapat disalahpahami bahwa ini diingat sebagai rantai percakapan daripada pembelajaran, sehingga dilakukan setelah penyegaran.) Data yang dipelajari segera direfleksikan, dan ini dapat dilihat sebagai personalisasi pertama asisten.

Semua fitur proyek ini dapat didukung secara lokal tanpa memerlukan integrasi cloud eksternal atau koneksi internet.

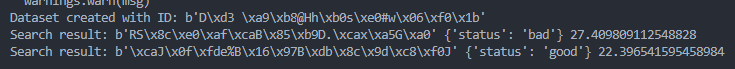

query = protobuf . search_pb2 . SearchRequest (

dataset_id = dataset_id ,

query = get_image_embedding ( "./test_data/bad.png" ),

k = 1

)

results = search . Search ( query )

try :

for result in results :

print ( "Search result:" , result . id , result . metadata , result . score )

except grpc . RpcError as e :

print ( "Search failed:" , e )

query = protobuf . search_pb2 . SearchRequest (

dataset_id = dataset_id ,

query = get_image_embedding ( "./test_data/good.png" ),

k = 1

)

results = search . Search ( query )

try :

for result in results :

print ( "Search result:" , result . id , result . metadata , result . score )

except grpc . RpcError as e :

print ( "Search failed:" , e )