Apakah Anda kewalahan dengan informasi yang Anda kumpulkan setiap hari? Apakah Anda sering tersesat di lautan file, video, halaman web, dan PDF yang mengalami penurunan harga? Bagaimana jika ada cara untuk mengindeks, menelusuri, dan bahkan berinteraksi dengan semua konten ini dengan cara yang belum pernah ada sebelumnya? Selamat datang di masa depan Manajemen Pengetahuan Pribadi: Proyek Agen AI Otak Kedua.

Ide inovatif Tiago Forte tentang Otak Kedua telah merevolusi cara kita berpikir tentang pencatatan. Ini bukan sekedar mencatat ide; ini tentang menciptakan alat canggih yang meningkatkan pembelajaran dan kreativitas. Pelajari lebih lanjut tentang Membangun Otak Kedua oleh Tiago Forte di sini.

Pengindeksan Otomatis: Tidak perlu lagi memilah file secara manual! Secara otomatis mengindeks konten file penurunan harga Anda bersama dengan tautan yang ada di dalamnya, seperti dokumen PDF, video YouTube, dan halaman web.

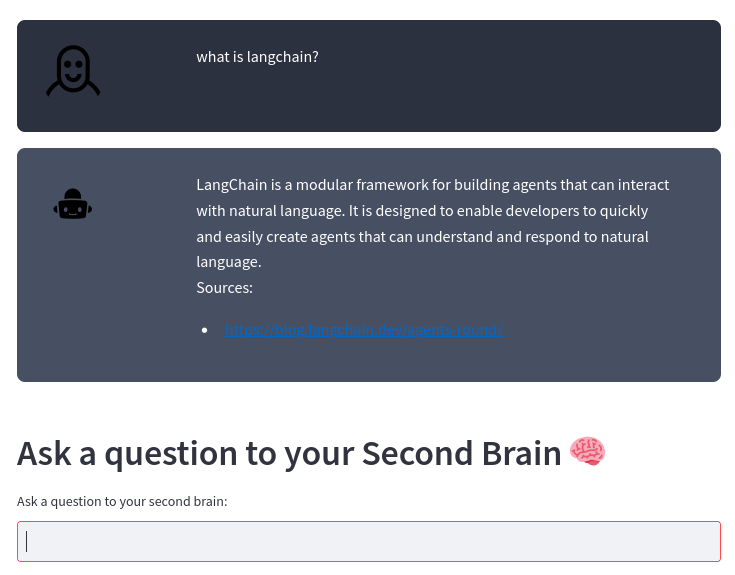

Mesin Pencari Cerdas: Ajukan pertanyaan tentang konten Anda, dan AI kami akan memberikan jawaban yang tepat, menggunakan Model Bahasa Besar OpenAI yang tangguh. Ini seperti memiliki asisten pribadi yang mengetahui konten Anda luar dalam!

Integrasi yang Mudah: Baik Anda mengikuti metode Otak Kedua atau memiliki cara unik Anda sendiri dalam mencatat, sistem kami berintegrasi secara mulus dengan gaya Anda, membantu Anda memanfaatkan kekuatan sebenarnya dari informasi Anda.

Peningkatan Produktivitas: Menghabiskan lebih sedikit waktu untuk mengatur dan lebih banyak waktu untuk berinovasi. Dengan mengakses informasi lebih cepat dan efisien, Anda dapat fokus pada hal yang benar-benar penting.

Jangan biarkan catatan dan konten Anda membuat Anda kewalahan. Jadikan mereka sekutu Anda dalam pertumbuhan, inovasi, dan produktivitas. Bergabunglah dengan kami dalam mengubah cara Anda mengelola pengetahuan pribadi dan mengambil lompatan ke masa depan.

Jika Anda membuat catatan menggunakan file penurunan harga seperti pada metode Otak Kedua atau menggunakan cara Anda sendiri, proyek ini secara otomatis mengindeks konten file penurunan harga dan tautan yang ada di dalamnya (dokumen pdf, video youtube, halaman web) dan memungkinkan Anda mengajukan pertanyaan tentang konten Anda menggunakan Model Bahasa Besar OpenAI.

Sistem ini dibangun di atas kerangka LangChain dan penyimpanan vektor ChromaDB.

Sistem mengambil direktori tempat Anda menyimpan catatan penurunan harga sebagai masukan. Misalnya, saya membuat catatan dengan Obsidian. Sistem kemudian memproses setiap perubahan pada file ini secara otomatis dengan alur berikut:

grafik TD

A[File penurunan harga dari editor Anda]-->B[File teks dari penurunan harga dan pointer]-->C[Potongan Teks]-->D[Database Vektor]-->E[Agen AI Otak Kedua]

Dari file penurunan harga, transform_md.py mengekstrak teks dari file penurunan harga, lalu dari tautan di dalam file penurunan harga, ia mengekstrak pdf, url, video youtube dan mengubahnya menjadi teks. Ada beberapa dukungan untuk mengekstrak data riwayat dari file penurunan harga: jika ada bagian ## History atau nama file berisi History , file dibagi menjadi beberapa bagian menurut bagian <day> <month> <year> seperti ### 10 Sep 2023 .

Dari file teks ini, transform_txt.py memecah file teks ini menjadi beberapa bagian, membuat penyematan vektor, lalu menyimpan penyematan vektor ini ke dalam database vektor.

Agen otak kedua menggunakan database vektor untuk mendapatkan konteks untuk mengajukan pertanyaan ke model bahasa besar. Proses ini disebut Retrieval-augmented generation (RAG).

Pada kenyataannya, prosesnya lebih kompleks dibandingkan RAG standar. Ini menganalisis pertanyaan dan kemudian menggunakan rantai yang berbeda sesuai dengan maksudnya:

diagram alur TD

A[Pertanyaan] --> C[/Dapatkan Maksud/]

C --> E[Ringkasan Permintaan] --> EA[/Ekstrak semua potongan/] --> EB[/Ringkasan potongan/]

C --> F[pencarian pdf atau URL] --> FA[/Ekstrak URL/]

C --> D[Laporan aktivitas]

C --> G[Pertanyaan Biasa]

D --> DA[/Dapatkan metadata Periode/] --> DB[/Dapatkan metadata Subjek/] --> DC[/Ekstrak Pertanyaan tanpa waktu/] --> H[/Ekstrak dokumen terdekatndari database vektor ndifilter oleh metadata/]

G --> GA[/Langkah mundur pertanyaan/] --> GB[/Ekstrak dokumen terdekatndari database vektor/]

H --> Saya[/Gunakan dokumen sebagai konteksnuntuk mengajukan pertanyaan kepada LLM/]

GB --> saya

Anda memerlukan juru bahasa Python 3, poetry , dan inotify-tools yang diinstal. Semua ini telah diuji di bawah Fedora Linux 38 di laptop saya dan Ubuntu terbaru dalam alur kerja CI. Beri tahu saya jika ini berfungsi di sistem Anda.

Dapatkan kode sumber:

$ git clone https://github.com/flepied/second-brain-agent.gitSalin contoh file .env dan edit sesuai pengaturan Anda:

$ cp example.env .envInstal dependensi menggunakan puisi:

$ poetry installAda bug antara puisi, obor dan pypi, untuk mengatasinya cukup lakukan:

$ poetry run pip install torchKemudian untuk menggunakan virtualenv yang dibuat, lakukan:

$ poetry shellUntuk menginstal layanan systemd untuk mengelola secara otomatis skrip yang berbeda ketika sistem operasi dimulai, gunakan perintah berikut (membutuhkan akses sudo):

$ ./install-systemd-services.shUntuk melihat output dari layanan md dan txt:

$ journalctl --unit=sba-md.service --user

$ journalctl --unit=sba-txt.service --user$ ./similarity.py " What is LangChain? " type=notesGunakan penyimpanan vektor untuk menemukan koneksi baru antar catatan:

$ ./smart_connections.pyLuncurkan perintah ini untuk mengakses UI web:

$ streamlit run second_brain_agent.py

You can now view your Streamlit app in your browser.

Local URL: http://localhost:8502

Network URL: http://192.168.121.112:8502Berikut ini contohnya:

Instal dependensi tambahan menggunakan puisi:

$ poetry install --with testDan kemudian jalankan tesnya, seperti ini:

$ poetry run pytestSebelum mengirimkan PR, pastikan untuk mengaktifkan pre-commit:

poetry run pre-commit install