Hujan adalah metode inferensi inovatif yang, dengan mengintegrasikan evaluasi diri dan mekanisme mundur, memungkinkan model bahasa besar yang beku untuk secara langsung menghasilkan respons yang konsisten dengan preferensi manusia tanpa memerlukan data penyelarasan tambahan atau penyempurnaan model, sehingga menawarkan solusi yang efektif untuk keselamatan AI.

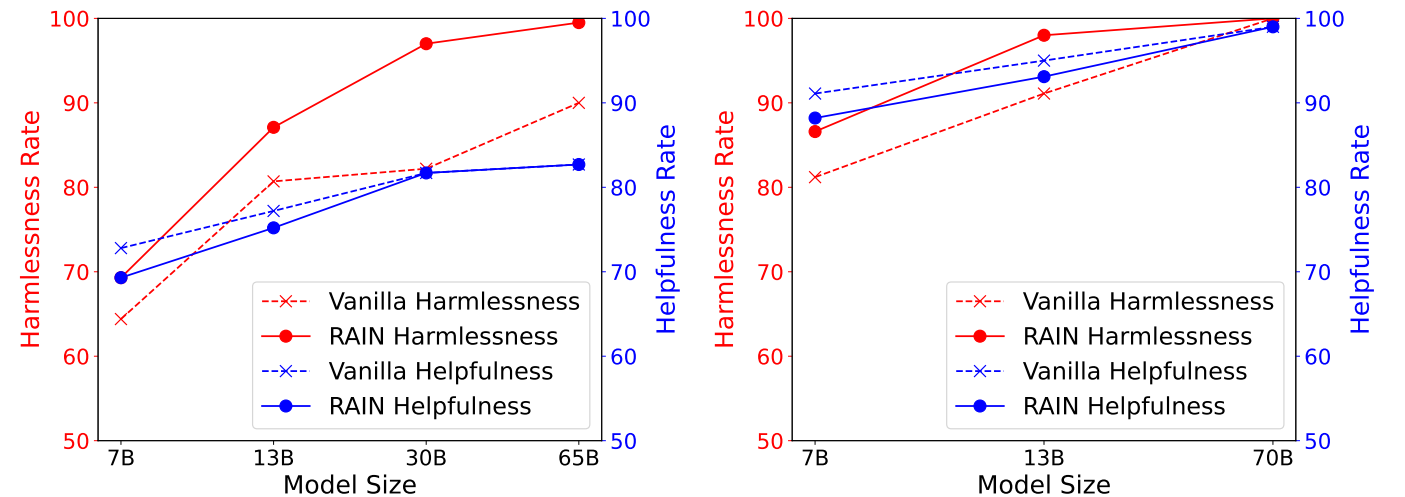

Gambar berikut menampilkan hasil eksperimen pada dataset antropik yang membantu dan tidak berbahaya (HH), menunjukkan bantuan vs tingkat berbahaya dari metode inferensi yang berbeda pada dataset HH, dievaluasi oleh GPT-4. Kiri: llama (7b, 13b, 30b, 65b). Kanan: Llama-2 (7b, 13b, 70b).

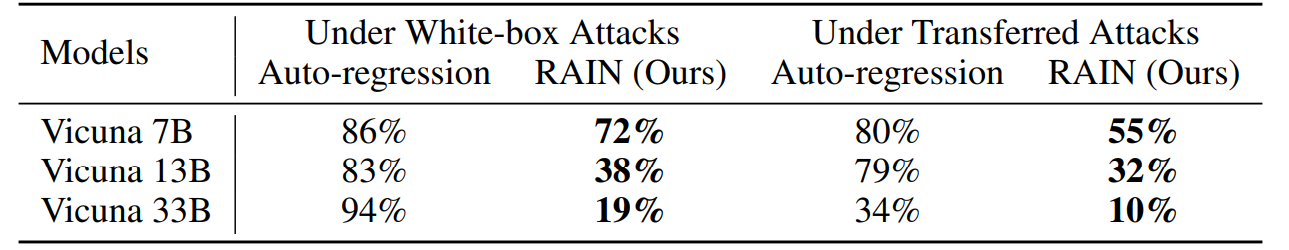

Gambar berikut menampilkan hasil eksperimen pada advbench di bawah serangan gradien koordinat serakah (GCG). Serangan kotak putih mengoptimalkan sufiks serangan spesifik dengan memanfaatkan gradien masing-masing model, sementara serangan transfer menggunakan Vicuna 7B dan 13B untuk mengoptimalkan sufiks serangan universal menggunakan kombinasi dari dua gradien model dan kemudian menggunakannya untuk menyerang model lain.

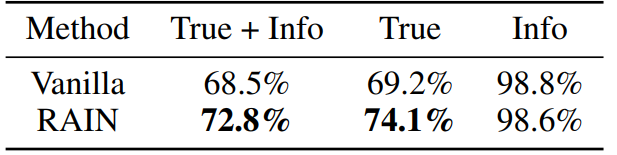

Gambar berikut ini menampilkan hasil eksperimen pada dataset sejujurnya dengan llama-2-chat 13b. Kami menyempurnakan dua model GPT-3 dengan meminta layanan dari OpenAi untuk menilai secara terpisah apakah tanggapan model itu jujur dan informatif.

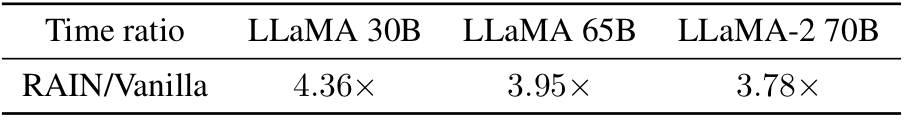

Penasaran tentang waktu overhead ke vanilla inferensi? Ini dia! Secara empiris, kami mengamati bahwa overhead lebih kecil untuk model yang lebih besar (lebih aman).

conda env create -f rain.yaml

CD HH alokasi python.py - -nump p

Parameter "nump" mewakili jumlah proses. Jika berjalan pada mesin dengan 8 GPU dan pengaturan NUMP = 4, setiap proses akan menggunakan 2 GPU.

CD Adv

Anda dapat menggunakan GCG untuk menghasilkan sufiks permusuhan atau menggunakan algoritma serangan lainnya. Simpan hasil serangan sebagai "yourdata.json" dengan format berikut:

[

{"Sasaran": "Instruksi atau Pertanyaan", "Kontrol": "Suffix Perselisihan"},

]Python allocation.py --Dataset yourdata.json --nump p

CD Truth alokasi python.py - -nump p

Untuk detail teknis dan hasil eksperimen lengkap, silakan periksa kertasnya.

@inproceedings{li2024rain,

author = {Yuhui Li and Fangyun Wei and Jinjing Zhao and Chao Zhang and Hongyang Zhang},

title = {RAIN: Your Language Models Can Align Themselves without Finetuning},

booktitle = {International Conference on Learning Representations},

year = {2024}

}Silakan hubungi Yuhui Li di [email protected] jika Anda memiliki pertanyaan tentang kode. Jika Anda menemukan repositori ini bermanfaat, silakan pertimbangkan untuk memberi.