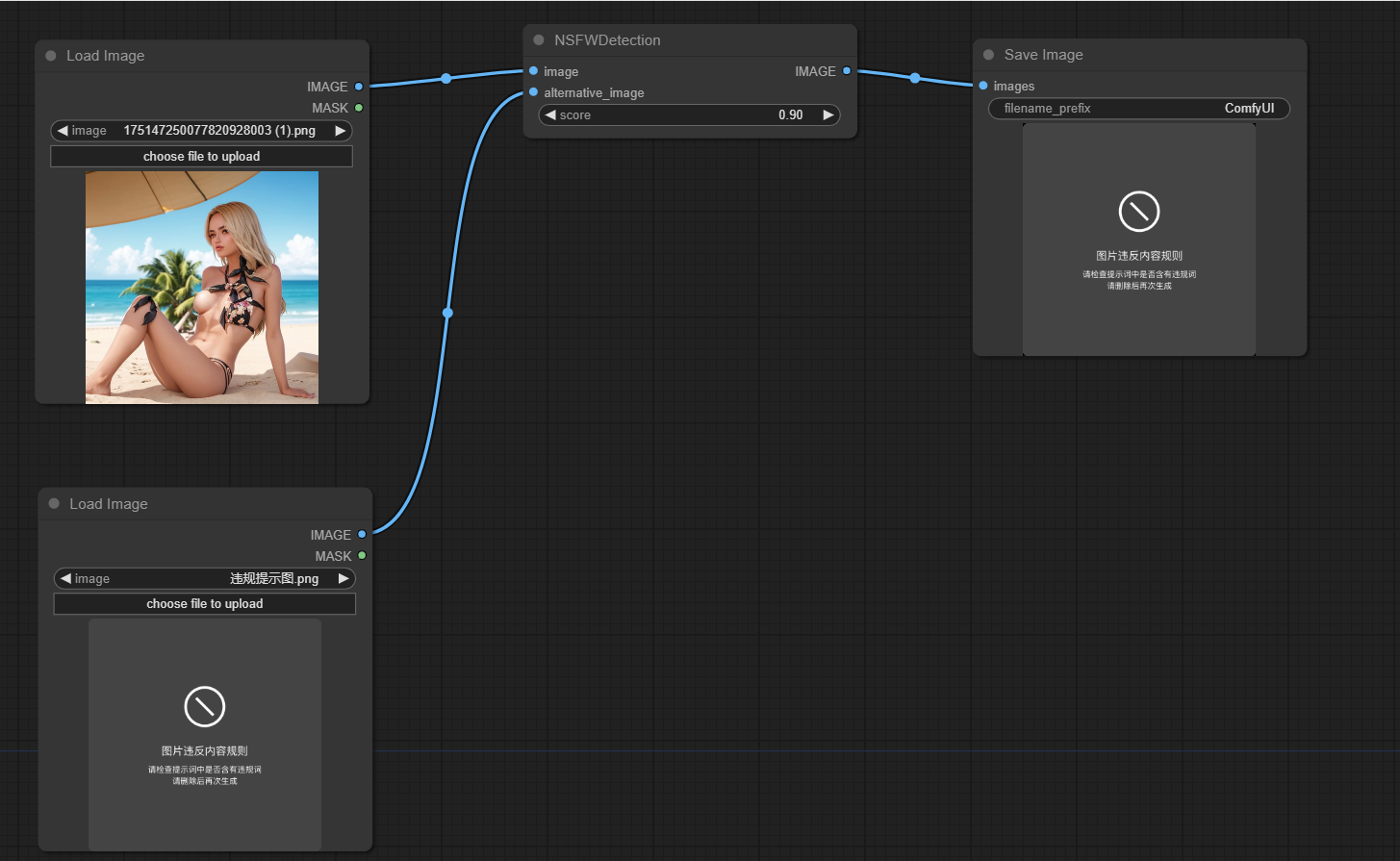

Proyek ini dirancang untuk mendeteksi apakah gambar yang dihasilkan oleh COMFYUI tidak aman untuk bekerja (NSFW). Ini menggunakan model pembelajaran mesin untuk mengklasifikasikan gambar sebagai aman atau tidak aman untuk bekerja. Jika gambar diklasifikasikan sebagai NSFW, gambar alternatif dikembalikan.

Klon repo ini ke direktori custom_nodes dari lokasi comfyui

Jalankan pip install -r persyaratan.txt

Fungsi utama proyek ini dienkapsulasi dalam kelas NSFWDetection di file node.py Kelas ini memiliki metode run yang mengambil tiga parameter:

image : Gambar yang akan diklasifikasikan.score : Skor ambang untuk mengklasifikasikan gambar sebagai NSFW.alternative_image : Gambar yang akan dikembalikan jika gambar input diklasifikasikan sebagai NSFW.

https://github.com/trumanwong/comfyui-nsfw-detection/blob/main/workflow.json

Kontribusi dipersilakan. Harap kirimkan permintaan tarik jika Anda memiliki perbaikan atau perbaikan bug.

Proyek ini dilisensikan berdasarkan ketentuan lisensi MIT.