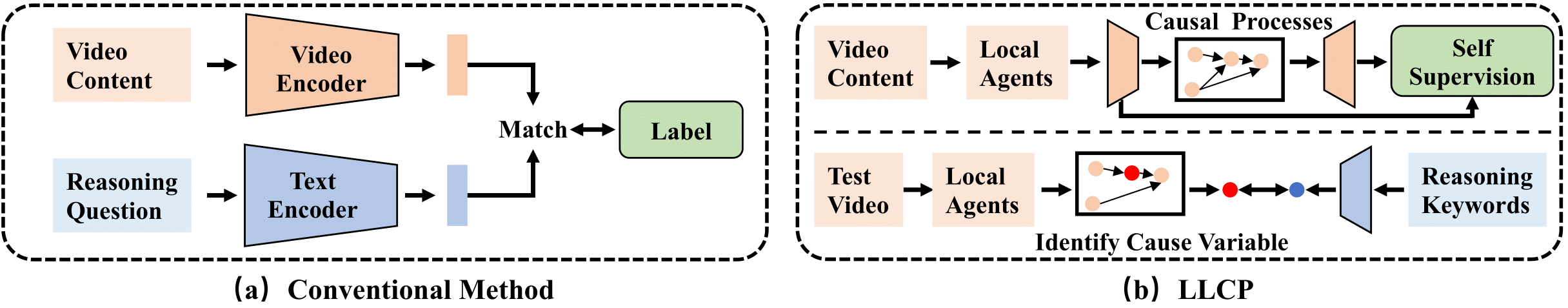

Repositori ini berisi implementasi untuk ICLR2024 Paper LLCP: Belajar proses kausal laten untuk penalaran pertanyaan video berbasis jawaban pdf

LLCP adalah kerangka kerja kausal yang dirancang untuk meningkatkan penalaran video dengan berfokus pada dinamika spasial-temporal objek dalam acara, tanpa perlu anotasi data yang luas. Dengan menggunakan pembelajaran yang di-swadaya dan memanfaatkan modularitas mekanisme kausal, LLCP mempelajari model generatif multivariat untuk dinamika spasial-temporal dan dengan demikian memungkinkan atribusi kecelakaan yang efektif dan prediksi kontrafaktual videoqA berbasis penalaran.

Pertama, silakan instal versi terbaru Pytorch dan TorchVision saat pip install torch torchvision . Kemudian, Anda dapat menginstal paket lain dengan menjalankan pip install -r requirements.txt

Kami menyediakan fitur yang diproses yang digunakan dalam percobaan kami. Silakan unduh data dan model di tautan ini dan tautan ini. Kemudian silakan mendekompres floders sebagai ./data/ dan ./results/ dan ganti floders asli sebagai yang diunduh.

Struktur direktori seharusnya terlihat seperti

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

Untuk melatih model CVAE, Anda dapat menjalankan perintah ini:

python train.py --cfg configs/sutd-traffic_transition.yml

Untuk mengevaluasi model yang terlatih, silakan merujuk ke:

python validate.py --cfg configs/sutd-traffic_transition.yml

Lihat Simulasi LLCP.

Jika Anda menemukan pekerjaan kami berguna dalam penelitian Anda, harap pertimbangkan mengutip:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

Implementasi kami terutama didasarkan pada SUTD-Trafficqa dan Tem-Adapter, kami berterima kasih kepada penulis untuk merilis kode mereka.