【2024.06.13】 Dukungan model MiniCPM-Llama3-V-2_5 , ubah variabel lingkungan MODEL_NAME=minicpm-v PROMPT_NAME=minicpm-v DTYPE=bfloat16

[2024.06.12] Mendukung model GLM-4V , memodifikasi variabel lingkungan MODEL_NAME=glm-4v PROMPT_NAME=glm-4v DTYPE=bfloat16 , lihat GLM4V untuk contoh uji.

【2024.06.08】 Model QWEN2 telah didukung, memodifikasi variabel lingkungan MODEL_NAME=qwen2 PROMPT_NAME=qwen2

【2024.06.05】 Mendukung model GLM4 dan memodifikasi variabel lingkungan MODEL_NAME=chatglm4 PROMPT_NAME=chatglm4

【2024.04.18】 Code Qwen , Demo Tanya Jawab SQL

【2024.04.16】 Mendukung model ulang Rerank , metode penggunaan

【 QWEN1.5 】 Variabel lingkungan MODEL_NAME=qwen2 PROMPT_NAME=qwen2

Untuk lebih banyak berita dan sejarah, silakan buka di sini

Konten utama dari proyek ini

Proyek ini mengimplementasikan antarmuka backend terpadu untuk penalaran model besar open source, yang konsisten dengan respons OpenAI dan memiliki karakteristik berikut:

Hubungi berbagai model open source dalam bentuk OpenAI ChatGPT API

? ️ mendukung respons streaming untuk mencapai efek printer

Menerapkan model embedding teks untuk memberikan dukungan untuk T&J Pengetahuan Dokumen

? ️ Mendukung berbagai fungsi langchain , alat pengembangan model bahasa skala besar

chatgpt

Mendukung pemuatan model lora yang terlatih sendiri

⚡ Mendukung percepatan inferensi VLLM dan pemrosesan permintaan bersamaan

| bab | menggambarkan |

|---|---|

| ?? tanggok Model | Model open source yang didukung oleh proyek ini dan informasi singkat |

| ? Mulai metode | Konfigurasi Lingkungan dan Perintah Startup untuk Model Startup |

| Metode Startup VLLM | Konfigurasi Lingkungan dan Perintah Startup untuk Mulai Model Menggunakan vLLM |

| Metode panggilan | Cara menelepon setelah memulai model |

| ❓FAQ | Membalas beberapa faq |

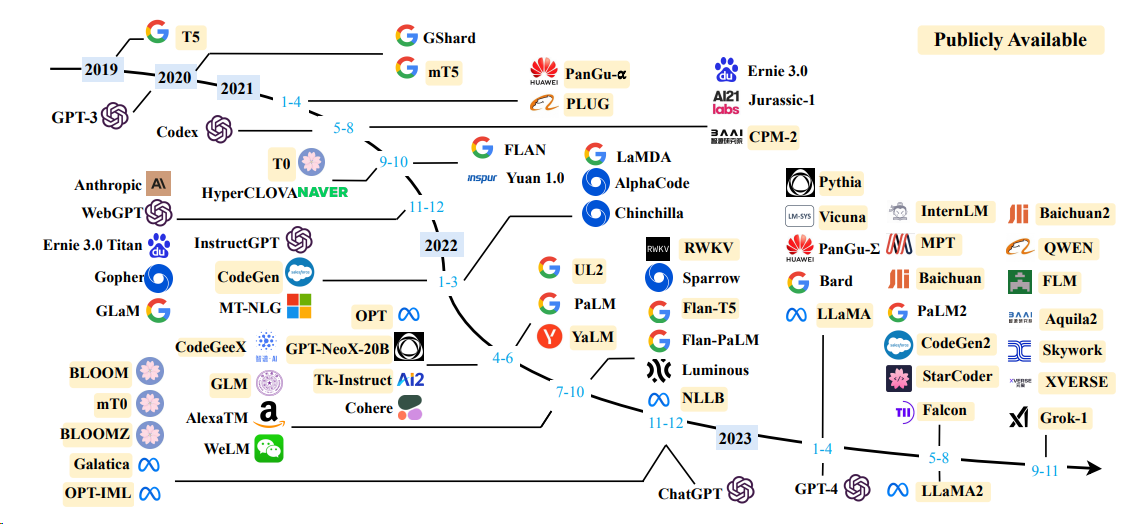

Model Bahasa

| Model | Ukuran parameter model |

|---|---|

| Baichuan | 7b/13b |

| Chatglm | 6b |

| Deepseek | 7b/16b/67b/236b |

| Internlm | 7b/20b |

| Llama | 7b/13b/33b/65b |

| Llama-2 | 7b/13b/70b |

| Llama-3 | 8b/70b |

| Qwen | 1.8b/7b/14b/72b |

| Qwen1.5 | 0.5b/1.8b/4b/7b/14b/32b/72b/110b |

| Qwen2 | 0.5b/1.5b/7b/57b/72b |

| Yi (1/1.5) | 6b/9b/34b |

Untuk detailnya, silakan merujuk ke metode startup VLLM dan metode startup Transformers.

Model Embed

| Model | Dimensi | Tautan berat |

|---|---|---|

| BGE-Large-ZH | 1024 | BGE-Large-ZH |

| M3E-Large | 1024 | moka-ai/m3e-besar |

| Text2Vec-Large-Chinese | 1024 | Text2Vec-Large-Chinese |

| BCE-EMBEDDING-BASE_V1 (disarankan) | 768 | BCE-EMBEDDING-BASE_V1 |

OPENAI_API_KEY : Cukup isi string di sini

OPENAI_API_BASE : Alamat antarmuka startup backend, seperti: http: //192.168.0.xx: 80/v1

cd streamlit-demo

pip install -r requirements.txt

streamlit run streamlit_app.py

from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

chat_completion = client . chat . completions . create (

messages = [

{

"role" : "user" ,

"content" : "你好" ,

}

],

model = "gpt-3.5-turbo" ,

)

print ( chat_completion )

# 你好!我是人工智能助手 ChatGLM3-6B,很高兴见到你,欢迎问我任何问题。

# stream = client.chat.completions.create(

# messages=[

# {

# "role": "user",

# "content": "感冒了怎么办",

# }

# ],

# model="gpt-3.5-turbo",

# stream=True,

# )

# for part in stream:

# print(part.choices[0].delta.content or "", end="", flush=True) from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

completion = client . completions . create (

model = "gpt-3.5-turbo" ,

prompt = "你好" ,

)

print ( completion )

# 你好!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。 from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# compute the embedding of the text

embedding = client . embeddings . create (

input = "你好" ,

model = "text-embedding-ada-002"

)

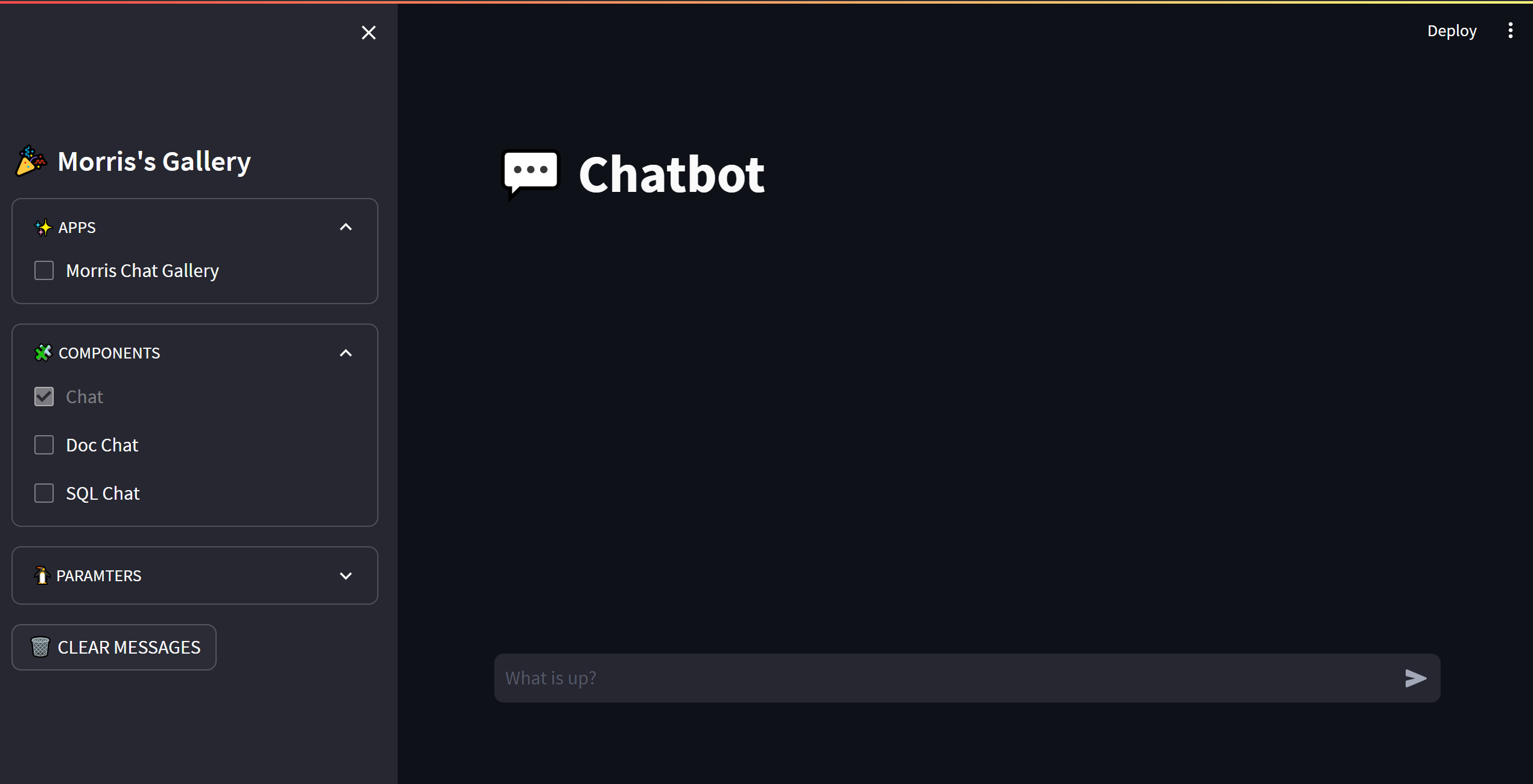

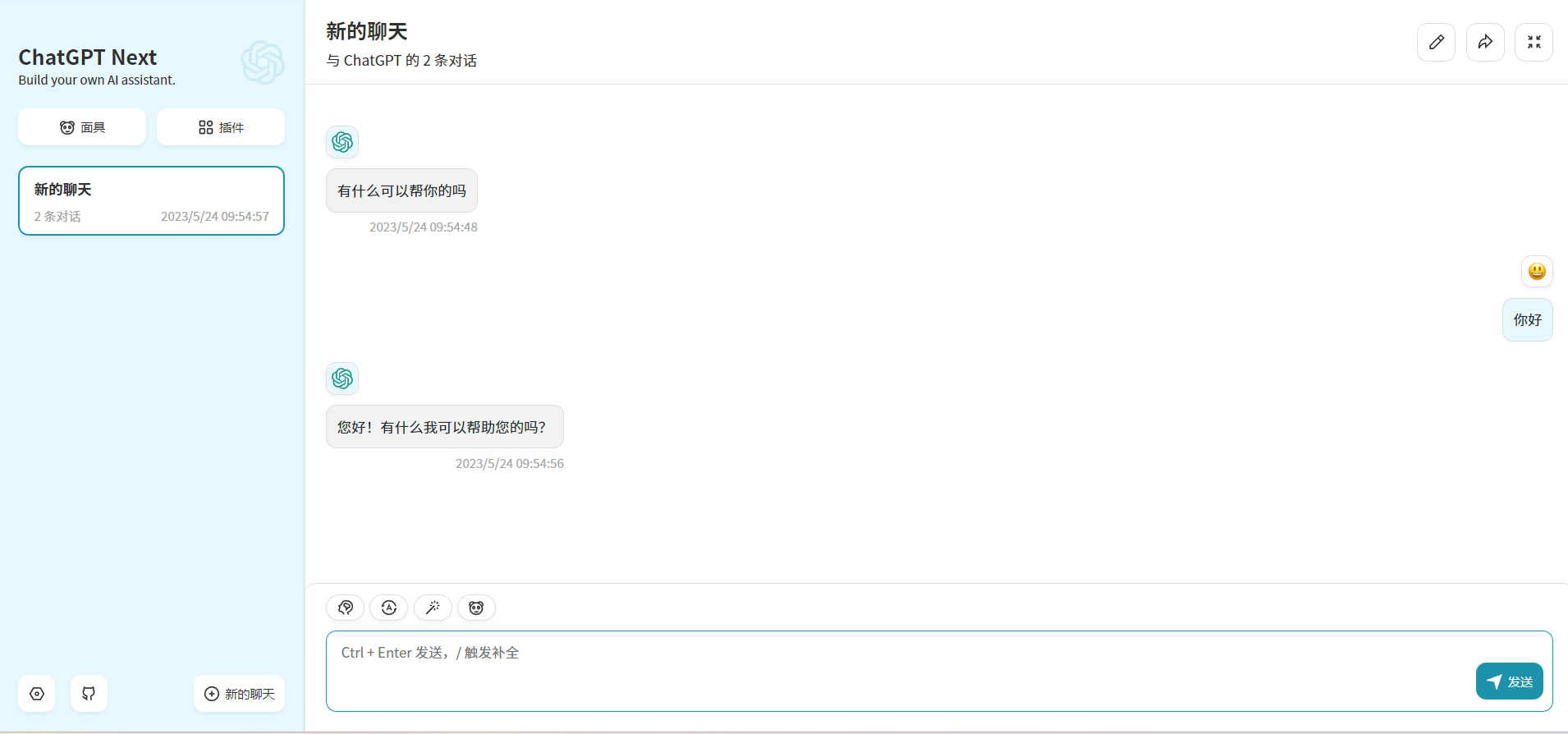

print ( embedding ) Dengan memodifikasi variabel lingkungan OPENAI_API_BASE , sebagian besar aplikasi chatgpt dan proyek front-end dapat terhubung dengan mulus!

docker run -d -p 3000:3000

-e OPENAI_API_KEY= " sk-xxxx "

-e BASE_URL= " http://192.168.0.xx:80 "

yidadaa/chatgpt-next-web

# 在docker-compose.yml中的api和worker服务中添加以下环境变量

OPENAI_API_BASE: http://192.168.0.xx:80/v1

DISABLE_PROVIDER_CONFIG_VALIDATION: ' true '

Proyek ini dilisensikan di bawah lisensi Apache 2.0 , lihat file lisensi untuk informasi lebih lanjut.

Chatglm: Model Bahasa Dialog Dwibala Terbuka

BLOOM: Model bahasa multibahasa akses-parameter 176b-parameter

Llama: Model Bahasa Yayasan Terbuka dan Efisien

Pengkodean teks yang efisien dan efektif untuk llama dan alpaca Cina

Phoenix: Demokratisasi chatgpt lintas bahasa

Moss: Model Bahasa Percakapan Plugin Terbuka

Fastchat: Platform terbuka untuk pelatihan, melayani, dan mengevaluasi chatbot berbasis model bahasa besar

Langchain: Membangun aplikasi dengan LLM melalui komposabilitas

Chuanhuchatgpt