GPT-4V, artefak yang dikenal sebagai "melihat gambar dan berbicara", telah dikritik karena kurangnya pemahaman tentang antarmuka grafis. Ini seperti orang yang “buta layar” yang sering mengklik tombol yang salah, dan itu menjengkelkan. Namun, model OmniParser yang dirilis oleh Microsoft diharapkan dapat menyelesaikan masalah ini sepenuhnya! OmniParser seperti "penerjemah layar", mengubah tangkapan layar menjadi bahasa terstruktur GPT-4V yang mudah dipahami, membuat "penglihatan" GPT-4V lebih tajam. Editor Downcodes akan membawa Anda untuk memiliki pemahaman mendalam tentang model ajaib ini, melihat bagaimana model ini membantu GPT-4V mengatasi cacat "kebutaan mata", dan teknologi luar biasa di baliknya.

Masih ingatkah Anda dengan GPT-4V, artefak yang dikenal dengan sebutan "melihat gambar dan berbicara"? Ia dapat memahami isi gambar dan melakukan tugas berdasarkan gambar. Sungguh berkah bagi orang yang malas! kelemahan: penglihatannya kurang bagus !

Bayangkan Anda meminta GPT-4V untuk mengeklik sebuah tombol untuk Anda, tetapi tombol tersebut berbunyi klik di mana-mana seperti "buta layar".

Hari ini saya akan memperkenalkan kepada Anda artefak yang dapat membuat GPT-4V terlihat lebih baik - OmniParser! Ini adalah model baru yang dirilis oleh Microsoft, yang bertujuan untuk memecahkan masalah interaksi otomatis antarmuka pengguna grafis (GUI).

Apa yang dilakukan OmniParser?

Sederhananya, OmniParser adalah "penerjemah layar" yang dapat mengurai tangkapan layar ke dalam "bahasa terstruktur" yang dapat dipahami oleh GPT-4V. OmniParser menggabungkan model deteksi ikon interaktif yang disempurnakan, model deskripsi ikon yang disempurnakan, dan keluaran modul OCR.

Kombinasi ini menghasilkan representasi UI yang terstruktur dan mirip DOM, serta tangkapan layar yang mencakup kotak pembatas elemen yang berpotensi dapat berinteraksi. Para peneliti pertama kali membuat kumpulan data deteksi ikon interaktif menggunakan halaman web populer dan kumpulan data deskripsi ikon. Kumpulan data ini digunakan untuk menyempurnakan model khusus: model deteksi untuk mengurai area yang dapat berinteraksi di layar dan model deskripsi untuk mengekstraksi semantik fungsional elemen yang terdeteksi.

Secara khusus, OmniParser akan:

Identifikasi semua ikon dan tombol interaktif di layar, tandai dengan kotak, dan berikan ID unik pada setiap kotak.

Gunakan teks untuk menjelaskan fungsi setiap ikon, seperti "Pengaturan" dan "Minimalkan". Kenali teks di layar dan ekstrak.

Dengan cara ini, GPT-4V dapat dengan jelas mengetahui apa yang ada di layar dan apa yang dilakukan setiap hal. Cukup beri tahu ID tombol mana yang ingin Anda klik.

Seberapa hebatkah OmniParser?

Para peneliti menggunakan berbagai pengujian untuk menguji OmniParser, dan menemukan bahwa OmniParser benar-benar dapat membuat GPT-4V “lebih baik”!

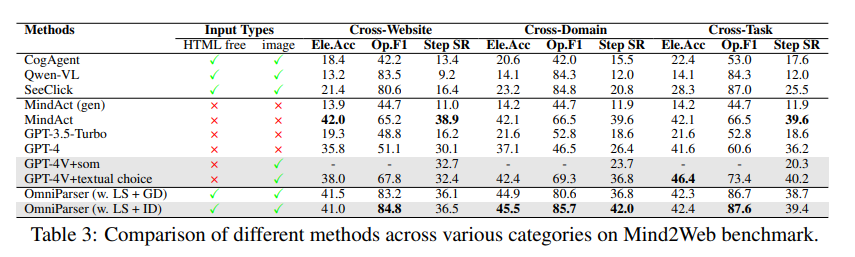

Dalam pengujian ScreenSpot, OmniParser meningkatkan akurasi GPT-4V secara signifikan, bahkan melampaui beberapa model yang dilatih khusus untuk antarmuka grafis. Misalnya, pada kumpulan data ScreenSpot, OmniParser meningkatkan akurasi sebesar 73%, mengungguli model yang mengandalkan penguraian HTML yang mendasarinya. Khususnya, penggabungan semantik lokal elemen UI menghasilkan peningkatan signifikan dalam akurasi prediksi - ikon GPT-4V diberi label dengan benar dari 70,5% menjadi 93,8% saat menggunakan keluaran OmniParser.

Dalam pengujian Mind2Web, OmniParser meningkatkan kinerja GPT-4V dalam tugas penjelajahan web, dan akurasinya bahkan melampaui GPT-4V yang menggunakan bantuan informasi HTML.

Dalam pengujian AITW, OmniParser secara signifikan meningkatkan kinerja GPT-4V dalam tugas navigasi ponsel.

Apa kekurangan OmniParser?

Meskipun OmniParser sangat kuat, ia juga memiliki beberapa kekurangan kecil, seperti:

Sangat mudah untuk menjadi bingung ketika dihadapkan dengan ikon atau teks yang berulang , dan diperlukan penjelasan yang lebih rinci untuk membedakannya.

Terkadang bingkai tidak digambar dengan cukup akurat , sehingga menyebabkan GPT-4V mengklik pada posisi yang salah.

Penafsiran ikon terkadang salah dan memerlukan konteks agar deskripsinya lebih akurat.

Namun, para peneliti bekerja keras untuk meningkatkan OmniParser dan percaya bahwa OmniParser akan menjadi lebih kuat dan pada akhirnya menjadi mitra terbaik GPT-4V!

Pengalaman model: https://huggingface.co/microsoft/OmniParser

Pintu masuk makalah: https://arxiv.org/pdf/2408.00203

Pengenalan resmi: https://www.microsoft.com/en-us/research/articles/omniparser-for-pure-vision-based-gui-agent/

Menyorot:

✨OmniParser dapat membantu GPT-4V lebih memahami konten layar dan melakukan tugas dengan lebih akurat.

OmniParser bekerja dengan baik dalam berbagai pengujian, membuktikan keefektifannya.

?️OmniParser masih memiliki beberapa area untuk ditingkatkan, namun masih ada harapan di masa depan.

Secara keseluruhan, OmniParser menghadirkan peningkatan revolusioner pada interaksi GPT-4V dengan antarmuka pengguna grafis. Meski masih terdapat beberapa kekurangan, namun potensinya sangat besar dan patut dinantikan pengembangannya ke depan. Editor Downcodes percaya bahwa dengan kemajuan teknologi yang berkelanjutan, OmniParser akan menjadi bintang yang bersinar di bidang kecerdasan buatan!