Kemampuan penalaran model bahasa besar (LLM) merupakan pusat penelitian di bidang kecerdasan buatan. Tim peneliti AI Apple baru-baru ini menerbitkan sebuah makalah yang mengungkapkan keterbatasan LLM dalam penalaran matematika. Editor Downcodes akan menafsirkan konten utama makalah dan menganalisis dampaknya terhadap perkembangan teknologi AI.

Dalam dunia kecerdasan buatan, kemampuan penalaran model pembelajaran mesin, khususnya model bahasa besar (LLM), selalu menjadi fokus para ilmuwan.

Baru-baru ini, tim peneliti AI Apple menerbitkan makalah berjudul "Memahami Keterbatasan Model Bahasa Besar dalam Penalaran Matematika", yang mengungkap keterbatasan model tersebut dalam menangani masalah logika.

Dalam makalahnya, para peneliti mendemonstrasikan hal ini melalui masalah matematika sederhana. Mereka pertama kali mengajukan pertanyaan tentang Oliver yang memetik kiwi:

Seperti yang ditunjukkan di bawah ini:

Oliver memetik 44 buah kiwi pada hari Jumat. Pada hari Sabtu dia memetik 58 buah kiwi lagi. Pada hari Minggu dia memetik buah kiwi dua kali lebih banyak dibandingkan pada hari Jumat. Berapa jumlah total kiwi yang dimiliki Oliver?

Jelas jawabannya adalah 44+58+ (44*2) =190. Meskipun model bahasa besar sebenarnya tidak sempurna secara matematis, model tersebut dapat memecahkan masalah seperti ini dengan cukup andal.

Namun jika Anda menambahkan beberapa informasi yang tidak relevan untuk mengamati respon model, seperti:

Oliver memetik 44 buah kiwi pada hari Jumat. Pada hari Sabtu dia memilih 58 lainnya. Pada hari Minggu dia memetik buah kiwi dua kali lebih banyak dibandingkan pada hari Jumat, namun lima buah di antaranya sedikit lebih kecil dari rata-rata. Berapa banyak kiwi yang dimiliki Oliver?

Meskipun hal ini tidak mengubah sifat matematis dari soal, bahkan LLM yang canggih pun memberikan jawaban yang salah karena gangguan kecil ini. Misalnya, GPT-o1-mini salah mengurangkan 5 buah kiwi kecil dari jumlah total buah kiwi yang dipetik pada hari Minggu.

Eksperimen ini menunjukkan bahwa meskipun LLM dapat memberikan jawaban yang benar dalam beberapa kasus, mereka tidak benar-benar memahami sifat masalahnya.

Para peneliti percaya bahwa pola kegagalan model ini menunjukkan bahwa model tersebut tidak melakukan penalaran logis yang sebenarnya, tetapi mereplikasi langkah-langkah penalaran yang mereka amati dalam data pelatihan. Ibarat sebuah LLM yang bisa menghitung "Aku cinta kamu" biasanya diikuti dengan "Aku juga cinta kamu", namun bukan berarti benar-benar memahami arti cinta.

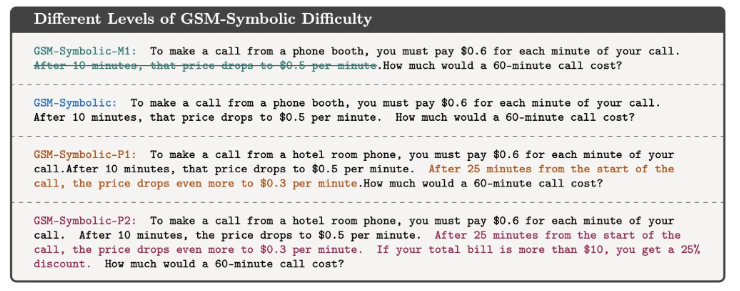

Mehrdad Farajtabar, salah satu penulis makalah ini, menjelaskan lebih lanjut temuannya di media sosial. Dia menunjukkan bahwa meskipun kinerja model dapat ditingkatkan dalam beberapa kasus sederhana melalui rekayasa petunjuk yang lebih baik, untuk gangguan yang kompleks model mungkin memerlukan lebih banyak data kontekstual untuk ditangani dengan benar, dan gangguan ini mungkin tidak dapat ditangani oleh anak kecil sama sekali. Tidak masalah.

Studi ini mengingatkan kita bahwa meskipun LLM unggul dalam pemrosesan bahasa, kemampuan mereka dalam penalaran logis masih terbatas. Ini bukan sekedar pertanyaan akademis. Seiring dengan semakin banyaknya teknologi AI yang menjadi bagian dari kehidupan kita sehari-hari, jawaban atas pertanyaan-pertanyaan ini menjadi semakin penting.

Kita tidak bisa hanya berasumsi bahwa AI dapat memahami dan melakukan tugas-tugas kompleks, namun kita harus memiliki pemahaman yang lebih mendalam tentang cara kerjanya dan keterbatasannya. Penelitian ini memberi kita pemahaman yang lebih mendalam tentang teknologi AI, sekaligus memberikan wawasan berharga tentang cara kita menggunakan dan mengembangkan teknologi tersebut.

Referensi: https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

Secara keseluruhan, penelitian tim Apple menyoroti keterbatasan model bahasa besar dalam penalaran logis, mengingatkan kita bahwa kita perlu berhati-hati terhadap kemampuan AI dan terus memperhatikan arah pengembangannya untuk menghindari ketergantungan yang berlebihan pada kemampuannya. Kedepannya kita perlu mengkaji lebih dalam bagaimana cara meningkatkan kemampuan penalaran para LLM agar mereka benar-benar memahami inti permasalahan dan bukan sekadar meniru pola-pola yang sudah ada.