Editor Downcodes akan membawa Anda memahami fenomena yang meresahkan di bidang AI - keruntuhan model. Bayangkan model AI itu seperti seorang food blogger yang mulai memakan makanan yang dimasaknya, semakin banyak ia makan, ia semakin ketagihan, dan makanan tersebut menjadi semakin tidak enak adalah saat model tersebut runtuh. Hal ini terjadi ketika model AI terlalu bergantung pada data yang dihasilkannya, sehingga menyebabkan penurunan kualitas model atau bahkan kegagalan total. Artikel ini akan mempelajari penyebab, dampak, dan cara menghindari keruntuhan model.

Hal aneh baru-baru ini terjadi di kalangan AI, seperti seorang food blogger yang tiba-tiba mulai memakan makanan yang dimasaknya, dan semakin banyak ia makan, ia semakin ketagihan, dan makanan tersebut menjadi semakin tidak enak. Hal ini cukup menakutkan untuk dikatakan. Istilah profesionalnya disebut model keruntuhan.

Apa yang dimaksud dengan keruntuhan model? Sederhananya, jika model AI menggunakan sejumlah besar data yang dihasilkan sendiri selama proses pelatihan, maka model tersebut akan terjerumus ke dalam lingkaran setan, yang menyebabkan kualitas pembuatan model semakin buruk, dan pada akhirnya gagal.

Ini seperti ekosistem tertutup. Model AI adalah satu-satunya makhluk hidup dalam sistem ini, dan makanan yang dihasilkannya adalah data. Pada awalnya masih bisa menemukan beberapa bahan alami (data asli), namun seiring berjalannya waktu mulai semakin bergantung pada bahan “buatan” yang dihasilkannya (data sintetis). Masalahnya adalah, bahan-bahan “buatan” ini kekurangan nutrisi dan memiliki beberapa kelemahan pada model itu sendiri. Jika Anda makan terlalu banyak, "tubuh" model AI akan runtuh, dan hal-hal yang dihasilkan akan menjadi semakin keterlaluan.

Makalah ini mempelajari fenomena keruntuhan model dan mencoba menjawab dua pertanyaan kunci:

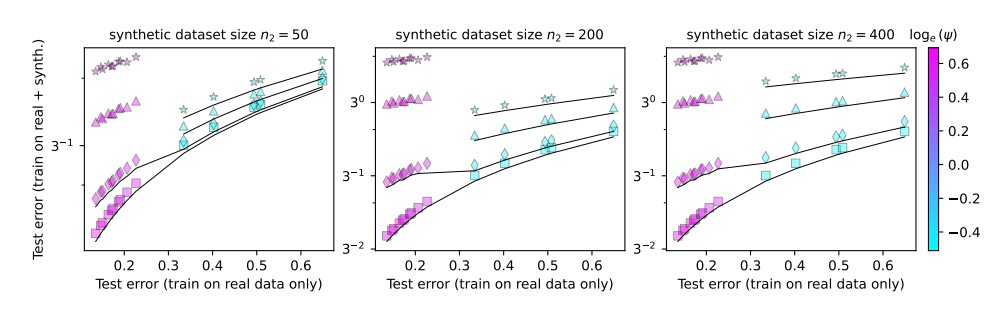

Apakah keruntuhan model tidak dapat dihindari? Apakah masalah ini dapat diselesaikan dengan menggabungkan data nyata dan data sintetis?

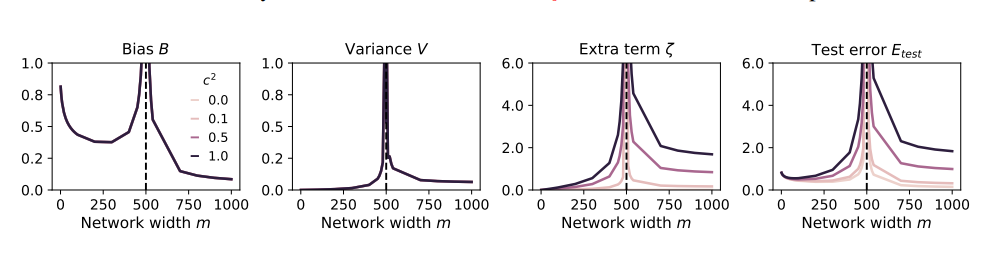

Semakin besar modelnya, semakin mudah terjadi error?

Untuk mempelajari masalah ini, penulis makalah ini merancang serangkaian eksperimen dan menggunakan model proyeksi acak untuk mensimulasikan proses pelatihan jaringan saraf. Mereka menemukan bahwa penggunaan sebagian kecil data sintetis (katakanlah, 1%) dapat menyebabkan kegagalan model. Lebih buruk lagi, seiring bertambahnya ukuran model, fenomena keruntuhan model menjadi lebih serius.

Ini seperti seorang food blogger yang mulai mencoba segala macam bahan aneh untuk menarik perhatian, namun akhirnya mengalami sakit perut. Untuk memulihkan kerugiannya, dia hanya bisa memperbanyak asupan makanannya dan makan lebih banyak dan hal-hal aneh, akibatnya perutnya semakin parah, dan dia akhirnya harus berhenti dari dunia makan dan penyiaran.

Jadi, bagaimana cara menghindari keruntuhan model?

Penulis makalah ini memberikan beberapa saran:

Prioritaskan penggunaan data nyata: Data nyata seperti makanan alami, kaya nutrisi, dan merupakan kunci pertumbuhan model AI yang sehat.

Gunakan data sintetis dengan hati-hati: Data sintetis itu seperti makanan buatan. Meskipun dapat menambah beberapa nutrisi, Anda tidak boleh terlalu mengandalkannya, jika tidak maka akan menjadi kontraproduktif.

Kontrol ukuran model: Semakin besar modelnya, semakin besar nafsu makannya, dan semakin mudah perutnya mual. Saat menggunakan data sintetis, kendalikan ukuran model untuk menghindari pemberian makan yang berlebihan.

Keruntuhan model merupakan tantangan baru yang dihadapi dalam proses pengembangan AI. Hal ini mengingatkan kita bahwa dalam mengejar skala dan efisiensi model, kita juga harus memperhatikan kualitas data dan kesehatan model. Hanya dengan cara inilah model AI dapat terus berkembang secara sehat dan menciptakan nilai yang lebih besar bagi masyarakat manusia.

Makalah: https://arxiv.org/pdf/2410.04840

Secara keseluruhan, keruntuhan model adalah masalah yang patut mendapat perhatian dalam pengembangan AI. Kita perlu memperlakukan data sintetis dengan hati-hati, memperhatikan kualitas data nyata, dan mengontrol skala model untuk menghindari fenomena "AI". makan terlalu banyak." Saya harap analisis ini dapat membantu semua orang lebih memahami keruntuhan model dan berkontribusi pada perkembangan AI yang sehat.