Editor Downcodes membawakan Anda berita besar! Cerebras Systems meluncurkan layanan inferensi AI tercepat di dunia - Cerebras Inference, yang telah sepenuhnya mengubah aturan main di bidang inferensi AI dengan kecepatannya yang luar biasa dan harga yang sangat kompetitif. Ia berkinerja baik dalam memproses berbagai model AI, terutama model bahasa besar (LLM), dan 20 kali lebih cepat dibandingkan sistem GPU tradisional dengan harga sepersepuluh atau bahkan seperseratus. Bagaimana pengaruh hal ini terhadap pengembangan aplikasi AI di masa depan? Mari kita lihat lebih dekat.

Cerebras Systems, pionir dalam komputasi performa AI, telah memperkenalkan solusi inovatif yang akan merevolusi inferensi AI. Pada tanggal 27 Agustus 2024, perusahaan mengumumkan peluncuran Cerebras Inference, layanan inferensi AI tercepat di dunia. Indikator kinerja Cerebras Inference mengerdilkan sistem berbasis GPU tradisional, memberikan kecepatan 20 kali lipat dengan biaya yang sangat rendah, sehingga menetapkan tolok ukur baru untuk komputasi AI.

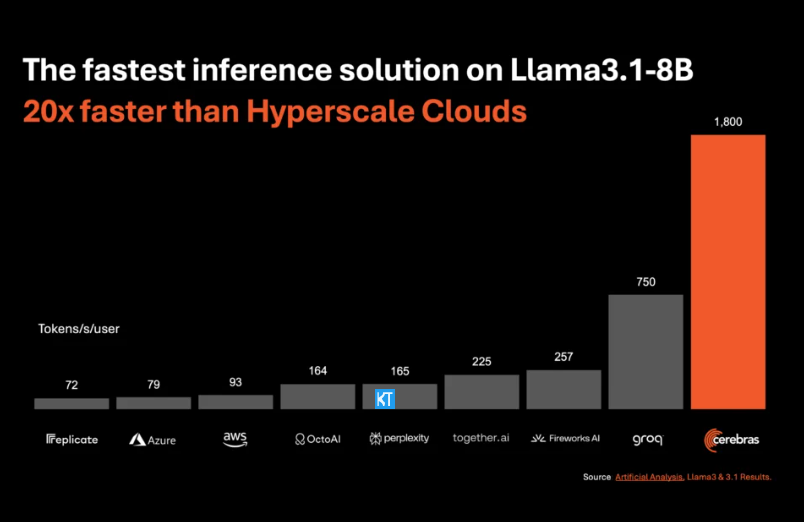

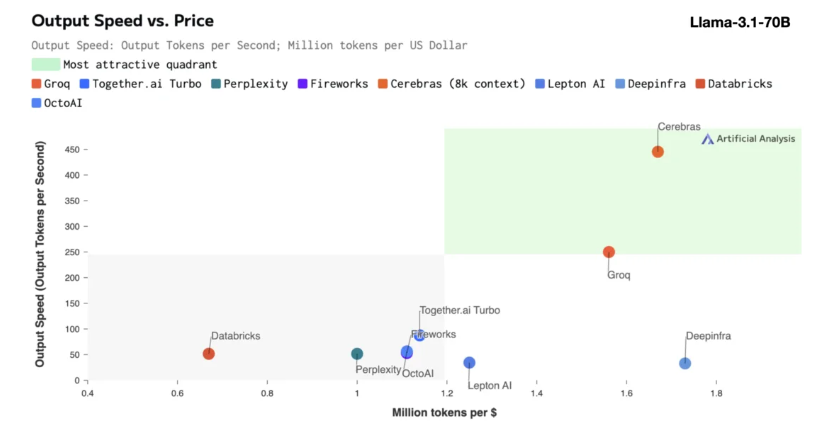

Inferensi Cerebras sangat cocok untuk memproses berbagai jenis model AI, terutama "model bahasa besar" (LLM) yang berkembang pesat. Mengambil contoh model Llama3.1 terbaru, versi 8B-nya dapat memproses 1,800 token per detik, sedangkan versi 70B dapat memproses 450 token. Solusi ini tidak hanya 20 kali lebih cepat dibandingkan solusi GPU NVIDIA, namun juga harganya lebih kompetitif. Harga Cerebras Inference mulai dari hanya 10 sen per juta token, dan versi 70B adalah 60 sen. Dibandingkan dengan produk GPU yang ada, rasio harga/kinerja ditingkatkan 100 kali lipat.

Sungguh mengesankan bahwa Cerebras Inference mencapai kecepatan ini dengan tetap mempertahankan akurasi terdepan di industri. Tidak seperti solusi yang mengutamakan kecepatan lainnya, Cerebras selalu melakukan inferensi dalam domain 16-bit, memastikan bahwa peningkatan kinerja tidak mengorbankan kualitas keluaran model AI. Micha Hill-Smith, CEO Artificial Analytics, mengatakan bahwa Cerebras mencapai kecepatan lebih dari 1,800 token keluaran per detik pada model Meta Llama3.1, yang merupakan rekor baru.

Inferensi AI adalah segmen komputasi AI dengan pertumbuhan tercepat, mencakup sekitar 40% dari seluruh pasar perangkat keras AI. Inferensi AI berkecepatan tinggi, seperti yang disediakan oleh Cerebras, seperti munculnya Internet broadband, membuka peluang baru dan mengantarkan era baru penerapan AI. Pengembang dapat menggunakan Cerebras Inference untuk membangun aplikasi AI generasi berikutnya yang memerlukan kinerja real-time yang kompleks, seperti agen cerdas dan sistem cerdas.

Cerebras Inference menawarkan tiga tingkat layanan dengan harga terjangkau: tingkat gratis, tingkat pengembang, dan tingkat perusahaan. Tingkat gratis menyediakan akses API dengan batas penggunaan yang besar, sehingga ideal untuk berbagai pengguna. Tingkat pengembang menyediakan opsi penerapan tanpa server yang fleksibel, sedangkan tingkat perusahaan menyediakan layanan dan dukungan yang disesuaikan untuk organisasi dengan beban kerja berkelanjutan.

Dalam hal teknologi inti, Cerebras Inference menggunakan sistem CerebrasCS-3, yang digerakkan oleh Wafer Scale Engine3 (WSE-3) yang terdepan di industri. Prosesor AI ini memiliki skala dan kecepatan yang tak tertandingi, menyediakan bandwidth memori 7.000 kali lebih banyak dibandingkan NVIDIA H100.

Cerebras Systems tidak hanya memimpin tren di bidang komputasi AI, namun juga memainkan peran penting dalam berbagai industri seperti medis, energi, pemerintahan, komputasi ilmiah, dan jasa keuangan. Dengan terus memajukan inovasi teknologi, Cerebras membantu organisasi di berbagai bidang mengatasi tantangan AI yang kompleks.

Menyorot:

Kecepatan layanan Cerebras Systems meningkat 20 kali lipat, harganya lebih kompetitif, dan membuka era baru pemikiran AI.

Mendukung berbagai model AI, terutama yang berkinerja baik pada model bahasa besar (LLM).

Tiga tingkat layanan disediakan untuk memfasilitasi pengembang dan pengguna perusahaan untuk memilih secara fleksibel.

Secara keseluruhan, kemunculan Cerebras Inference menandai tonggak penting dalam bidang inferensi AI. Performa dan ekonomisnya yang luar biasa akan mendorong pemasyarakatan yang luas dan pengembangan aplikasi AI yang inovatif, dan hal ini patut mendapat perhatian dan antisipasi dari industri! Editor Downcodes akan terus memberikan Anda lebih banyak informasi teknologi mutakhir.