Anthropic baru -baru ini meluncurkan fitur baru dari seri Claude dari model bahasa skala besar -kompleks cache untuk mengurangi biaya menggunakan AI dan meningkatkan kinerja. Langkah ini dianggap sebagai strategi unik antropik dalam bersaing dengan raksasa seperti OpenAi, Google dan Microsoft untuk memilih meningkatkan efisiensi dan mengurangi perspektif biaya. Fungsi ini saat ini diuji secara publik pada API model CLAUDE3.5 Sonnet dan Claude3 Haiku, berjanji untuk mengurangi biaya hingga 90%dan meningkatkan kecepatan respons dari beberapa skenario aplikasi. Namun, efek aktual masih membutuhkan inspeksi pasar.

Pada 14 Agustus, Anthropic mengumumkan bahwa mereka meluncurkan fitur baru yang disebut CLAUDE Series Large Language Model, mengklaim bahwa itu dapat sangat mengurangi biaya menggunakan AI dan meningkatkan kinerja. Tetapi apakah fungsi ini bisa sama ajaibnya dengan yang dikatakan perusahaan dan harus diuji di pasar.

Fungsi cache akan diuji secara publik pada API -nya dari model Claude3.5Sonnet dan Claude3HauKu. Fungsi ini memungkinkan pengguna untuk menyimpan dan menggunakan kembali informasi konteks tertentu, termasuk instruksi dan data yang kompleks, tanpa biaya tambahan atau peningkatan penundaan. Juru bicara perusahaan mengatakan bahwa ini adalah salah satu dari sekian banyak karakteristik cutting -edge yang mereka kembangkan untuk meningkatkan kemampuan Claude.

Saat ini, raksasa teknologi seperti Openai, Google, dan Microsoft telah meluncurkan kompetisi sengit di bidang model bahasa skala besar, dan masing -masing perusahaan berusaha meningkatkan kinerja dan daya saing pasar produk mereka. Dalam kompetisi ini, antropik memilih untuk memotong dari perspektif meningkatkan efisiensi penggunaan dan mengurangi biaya, menunjukkan strategi pasarnya yang unik.

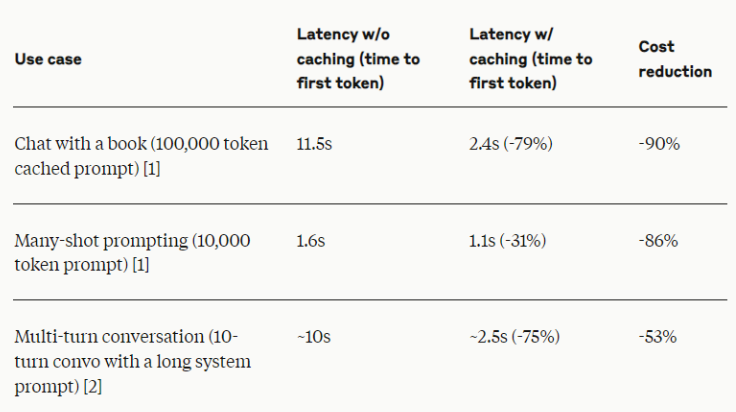

Menurut Anthropic, fitur baru ini dapat menghasilkan hingga 90%dari biaya, dan menggandakan kecepatan respons dalam beberapa skenario aplikasi. Angka -angka ini tidak diragukan lagi mengesankan, tetapi para pakar industri mengingatkan bahwa efek aktual mungkin berbeda karena skenario dan implementasi aplikasi spesifik.

Antropik mengatakan bahwa fungsi cache sangat cocok untuk adegan yang perlu konsisten dalam konteks dalam berbagai kueri atau sesi, seperti dialog jangka panjang, pemrosesan dokumen skala besar, bantuan kode, dan alat yang kompleks. Metode ini diharapkan membawa peningkatan efisiensi ke berbagai aplikasi AI komersial.

Orang dalam industri menunjukkan bahwa meskipun fitur baru Antropik tampaknya cerah, perusahaan AI lain juga secara aktif mengeksplorasi metode meningkatkan efisiensi model dan mengurangi biaya penggunaan. Misalnya, OpenAI menyediakan berbagai kemampuan dan opsi model harga, sementara Google berkomitmen untuk mengembangkan model yang dapat beroperasi secara efisien pada perangkat keras biasa.

Untuk efek aktual dari fitur baru ini, pasar masih berhati -hati. Seperti halnya teknologi baru, terutama di bidang AI yang berkembang pesat, kinerja fungsi cache di dunia nyata belum diamati. Antropik mengatakan bahwa mereka akan bekerja sama dengan pelanggan untuk mengumpulkan data dan umpan balik yang relevan, yang sejalan dengan praktik terbaik dalam industri yang mengevaluasi pengaruh teknologi AI baru.

Inisiatif Anthropic mungkin berdampak luas pada industri AI, terutama dalam memberikan kemampuan AI canggih untuk UKM. Jika fungsi ini benar -benar efektif seperti mempromosikan, itu dapat mengurangi ambang batas bagi perusahaan untuk mengadopsi solusi AI yang kompleks, sehingga mempromosikan penerapan teknologi AI di bidang bisnis yang lebih luas.

Dengan pengembangan tes publik, perusahaan dan pengembang akan memiliki kesempatan untuk secara pribadi mengevaluasi kinerja aktual dari fungsi cache dan bagaimana itu beradaptasi dengan strategi AI masing -masing. Dalam beberapa bulan ke depan, kami diharapkan untuk melihat kinerja prompt AI manajemen ini dan konteks dalam aplikasi praktis.

Fungsi cache cepat Anthropic merupakan upaya menarik oleh industri AI dalam hal efisiensi dan optimasi biaya. Namun, apakah itu benar -benar dapat memimpin perubahan industri, itu juga membutuhkan pemeriksaan lebih lanjut dari pasar. Dalam kasus apa pun, inovasi ini mencerminkan eksplorasi berkelanjutan dari arah baru di perusahaan AI dalam persaingan yang sengit, dan juga menunjukkan bahwa teknologi AI dapat mengantarkan putaran baru revolusi yang efisien.

Secara keseluruhan, kunci keberhasilan fungsi cache prompt antropik adalah efek aplikasi yang sebenarnya. Kinerja pasar berikutnya akan menjadi standar utama untuk menguji teknologi ini dan juga akan membawa wahyu baru ke seluruh industri AI.