Ilmuwan meta Thomas Scialom menjelaskan proses pengembangan Llama 3.1 secara rinci di podcast Latent Space dan melihat arah pengembangan Llama 4. Llama 3.1 bukanlah penumpukan parameter sederhana, namun merupakan trade-off antara ukuran parameter, waktu pelatihan, dan batasan perangkat keras. Ukuran parameter 405B-nya merupakan respons terhadap GPT-4o. Meskipun ukuran model yang besar menyulitkan untuk dijalankan di komputer biasa, fitur open source memungkinkan lebih banyak orang untuk berpartisipasi dan mendorong perkembangan teknologi.

Kelahiran Llama3.1 merupakan keseimbangan sempurna antara skala parameter, waktu pelatihan, dan keterbatasan perangkat keras. Bodi besar 405B bukanlah pilihan sembarangan, melainkan tantangan yang dikeluarkan Meta terhadap GPT-4o. Meskipun keterbatasan perangkat keras mencegah Llama3.1 berjalan di setiap komputer rumah, kekuatan komunitas open source membuat segalanya mungkin.

Selama pengembangan Llama 3.1, Scialom dan timnya mengkaji ulang Scaling Law. Mereka menemukan bahwa ukuran model memang merupakan kuncinya, namun yang lebih penting adalah jumlah total data pelatihan. Llama3.1 memilih untuk meningkatkan jumlah token pelatihan, meskipun itu berarti menghabiskan lebih banyak daya komputasi.

Tidak ada perubahan besar dalam arsitektur Llama 3.1, tetapi Meta telah melakukan upaya besar dalam hal skala dan kualitas data. Lautan token 15T telah memberi Llama3.1 lompatan kualitatif dalam kedalaman dan luasnya pengetahuan.

Dalam hal pemilihan data, Scialom sangat yakin bahwa ada terlalu banyak sampah teks di Internet publik, dan emas sebenarnya adalah data sintetis. Dalam proses pasca-pelatihan Llama3.1, tidak ada jawaban tertulis manual yang digunakan sama sekali, tetapi sepenuhnya bergantung pada data sintetik yang dihasilkan oleh Llama2.

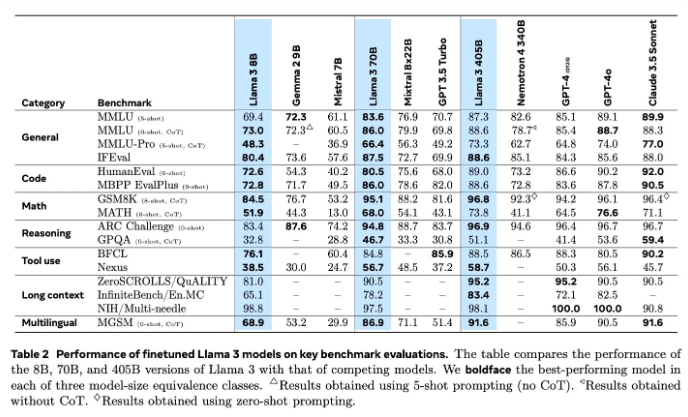

Evaluasi model selalu menjadi masalah sulit di bidang AI. Llama3.1 telah mencoba berbagai metode untuk evaluasi dan peningkatan, termasuk model penghargaan dan beragam tes benchmark. Namun tantangan sebenarnya terletak pada menemukan petunjuk tepat yang dapat mengalahkan model yang kuat.

Meta telah memulai pelatihan Llama4 pada bulan Juni, dan kali ini mereka fokus pada teknologi agen. Pengembangan alat agen seperti Toolformer menandai eksplorasi baru Meta di bidang AI.

Open source Llama3.1 bukan hanya upaya berani Meta, tetapi juga pemikiran mendalam tentang masa depan AI. Dengan peluncuran Llama4, kami memiliki alasan untuk percaya bahwa Meta akan terus memimpin AI. Mari kita nantikan bagaimana Llama4 dan teknologi agen akan mendefinisikan kembali masa depan AI.

Melalui pemahaman mendalam tentang proses R&D Llama 3.1, kita dapat melihat inovasi dan upaya Meta yang berkelanjutan di bidang model bahasa berskala besar, serta penekanannya pada komunitas open source. Arah penelitian dan pengembangan Llama 4 juga menunjukkan tren perkembangan teknologi AI di masa depan yang patut untuk ditunggu dan diwaspadai. Mari kita nantikan bagaimana teknologi AI akan berkembang di masa depan.