Apa jadinya jika AI dilatih ulang menggunakan gambar yang dihasilkannya? Baru-baru ini, para peneliti di Universitas Stanford dan Universitas California, Berkeley, melakukan eksperimen serupa, dan hasilnya mengejutkan.

Para peneliti menemukan bahwa ketika model penghasil gambar AI dilatih ulang untuk menggunakan gambar yang mereka hasilkan sendiri, model tersebut menghasilkan gambar yang sangat terdistorsi. Lebih buruk lagi, distorsi ini tidak terbatas pada isyarat teks yang digunakan untuk pelatihan ulang. Setelah model "terkontaminasi", sulit bagi model untuk pulih sepenuhnya, meskipun kemudian dilatih ulang hanya dengan gambar nyata.

Titik awal percobaan ini adalah model sumber terbuka yang disebut Difusi Stabil (SD). Para peneliti pertama-tama memilih 70.000 gambar wajah berkualitas tinggi dari kumpulan data wajah FFHQ dan secara otomatis mengklasifikasikannya. Mereka kemudian menggunakan gambar nyata ini sebagai masukan untuk menghasilkan 900 gambar yang konsisten dengan karakteristik sekelompok orang tertentu melalui model Difusi Stabil.

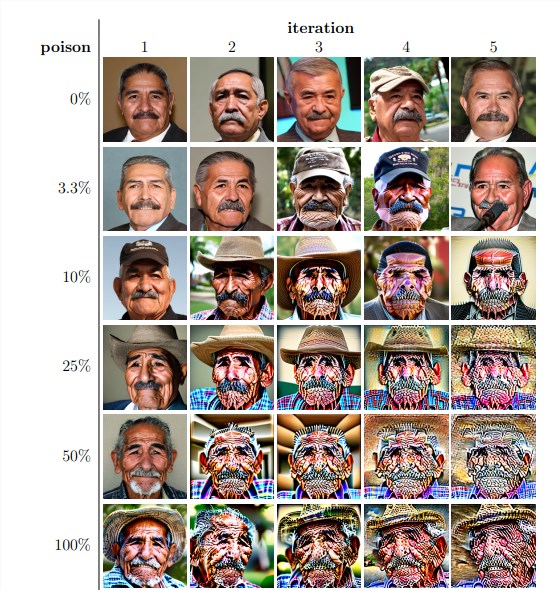

Selanjutnya, para peneliti menggunakan gambar yang dihasilkan ini untuk pelatihan ulang model secara berulang. Mereka menemukan bahwa terlepas dari proporsi gambar yang dihasilkan sendiri dalam kumpulan data pelatihan ulang, model tersebut pada akhirnya gagal dan kualitas gambar yang dihasilkan menurun drastis. Meskipun data pelatihan ulang hanya berisi 3% gambar yang dihasilkan sendiri, fenomena keruntuhan model masih ada.

Hasil eksperimen menunjukkan bahwa versi dasar model Difusi Stabil menghasilkan gambar yang konsisten dengan isyarat teks dan memiliki kualitas visual yang tinggi. Namun saat model tersebut dilatih ulang secara berulang, gambar yang dihasilkan mulai menunjukkan inkonsistensi semantik dan distorsi visual. Para peneliti juga menemukan bahwa keruntuhan model tidak hanya memengaruhi kualitas gambar tetapi juga mengakibatkan kurangnya keragaman pada gambar yang dihasilkan.

Untuk memverifikasi hal ini, para peneliti juga melakukan eksperimen terkontrol untuk mencoba mengurangi dampak keruntuhan model dengan menyesuaikan histogram warna dari gambar yang dihasilkan dan menghapus gambar berkualitas rendah. Namun hasilnya menunjukkan bahwa langkah-langkah ini tidak efektif dalam mencegah keruntuhan model.

Para peneliti juga mengeksplorasi apakah mungkin suatu model pulih melalui pelatihan ulang setelah “terkontaminasi”. Mereka menemukan bahwa meskipun dalam beberapa kasus kualitas gambar yang dihasilkan pulih setelah beberapa kali pelatihan ulang, tanda-tanda keruntuhan model tetap ada. Hal ini menunjukkan bahwa sekali suatu model "terkontaminasi", dampaknya mungkin bersifat jangka panjang atau bahkan tidak dapat diubah.

Studi ini mengungkapkan sebuah isu penting: sistem AI generasi teks-ke-gambar berbasis difusi yang saat ini sangat populer sangat sensitif terhadap "kontaminasi" data. "Kontaminasi" ini dapat terjadi secara tidak sengaja, misalnya dengan mengambil gambar dari sumber online secara sembarangan. Bisa juga merupakan serangan yang ditargetkan, seperti dengan sengaja menempatkan data yang "tercemar" di situs web.

Menghadapi tantangan ini, para peneliti telah mengusulkan beberapa solusi yang mungkin, seperti menggunakan pendeteksi keaslian gambar untuk mengecualikan gambar yang dihasilkan AI, atau menambahkan tanda air pada gambar yang dihasilkan. Meskipun tidak sempurna, gabungan metode ini dapat secara signifikan mengurangi risiko "kontaminasi" data.

Kajian ini mengingatkan kita bahwa perkembangan teknologi AI bukannya tanpa risiko. Kami harus lebih berhati-hati dengan konten yang dihasilkan AI untuk memastikan konten tersebut tidak memiliki dampak negatif jangka panjang pada model dan kumpulan data kami. Penelitian di masa depan perlu mengeksplorasi lebih jauh bagaimana membuat sistem AI lebih tahan terhadap jenis “kontaminasi” data atau mengembangkan teknik yang dapat mempercepat “penyembuhan” model.