Tim Alibaba Qwen merilis tolok ukur baru yang disebut "PROCESSBENCH", yang bertujuan untuk mengevaluasi secara lebih komprehensif kemampuan model bahasa dalam penalaran matematis, dengan fokus khusus pada kemampuan model dalam mengidentifikasi kesalahan proses. Tolok ukur yang ada memiliki keterbatasan, seperti terlalu sederhana untuk model tingkat tinggi atau hanya menyediakan evaluasi kebenaran biner, dan kurang menganalisis langkah-langkah kesalahan secara mendetail. Munculnya "PROCESSBENCH" mengisi kesenjangan ini dan menyediakan alat baru untuk pemahaman yang lebih dalam dan peningkatan mekanisme penalaran model bahasa.

Baru-baru ini, peneliti dari tim Qwen Alibaba meluncurkan tolok ukur baru yang disebut "PROCESSBENCH", yang dirancang untuk mengukur kemampuan model bahasa dalam mengidentifikasi kesalahan proses dalam penalaran matematika. Karena model bahasa telah mencapai kemajuan yang signifikan dalam tugas-tugas penalaran yang kompleks, para peneliti di bidang ini menemukan bahwa meskipun kinerjanya sangat baik, model tersebut masih menghadapi tantangan dalam menangani masalah-masalah sulit tertentu. Oleh karena itu, sangat penting untuk mengembangkan metode pengawasan yang efektif.

Tolok ukur evaluasi model bahasa saat ini memiliki beberapa kekurangan. Di satu sisi, beberapa rangkaian masalah menjadi terlalu sederhana untuk model tingkat lanjut, dan di sisi lain, metode evaluasi yang ada sering kali hanya memberikan evaluasi kebenaran biner tanpa anotasi kesalahan yang mendetail. Fenomena ini menyoroti kebutuhan mendesak akan kerangka evaluasi yang lebih komprehensif untuk mengkaji lebih dalam mekanisme inferensi model bahasa yang kompleks.

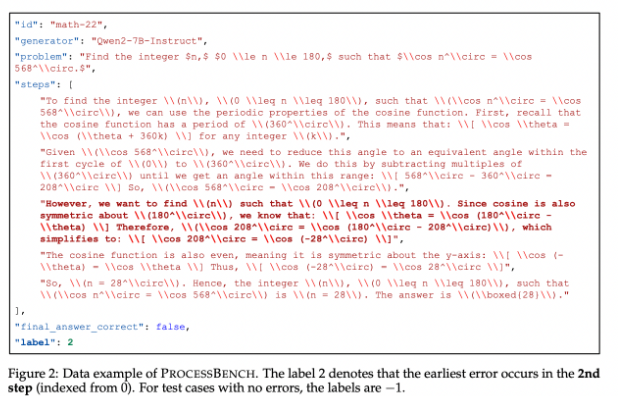

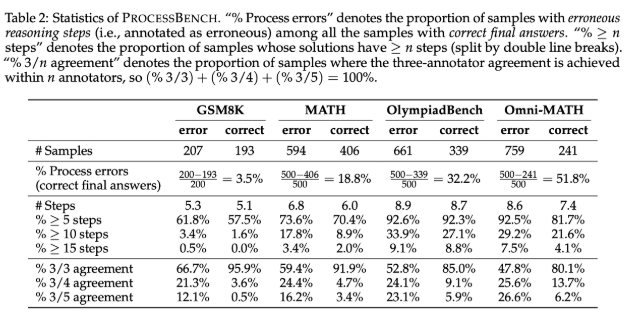

Untuk mengisi kesenjangan ini, para peneliti merancang "PROCESSBENCH", sebuah tolok ukur yang berfokus pada mengidentifikasi langkah-langkah yang salah dalam penalaran matematika. Prinsip desainnya mencakup kesulitan masalah, keragaman solusi, dan evaluasi komprehensif. Tolok ukur ini menargetkan masalah matematika tingkat kompetisi dan Olimpiade, memanfaatkan berbagai model bahasa sumber terbuka untuk menghasilkan solusi yang menunjukkan pendekatan berbeda untuk memecahkan masalah. PROCESSBENCH berisi total 3.400 kasus uji yang telah dianotasi secara cermat oleh banyak pakar untuk memastikan kualitas data dan keandalan evaluasi.

Selama pengembangan, tim peneliti mengumpulkan soal matematika dari empat kumpulan data terkenal (GSM8K, MATH, OlympiadBench, dan Omni-MATH), memastikan bahwa berbagai kesulitan tercakup dari tingkat sekolah dasar hingga tingkat kompetisi. Mereka memanfaatkan model sumber terbuka untuk menghasilkan hingga 12 solusi berbeda guna meningkatkan keragaman solusi. Selain itu, untuk menyatukan format langkah-langkah solusi, tim mengadopsi metode pemformatan ulang untuk memastikan penalaran langkah demi langkah yang lengkap secara logis.

Hasil penelitian menunjukkan bahwa model imbalan proses yang ada memiliki kinerja yang buruk ketika menangani masalah yang sulit, terutama pada rangkaian masalah yang lebih sederhana, dan model penilaian yang didorong oleh cepat memiliki kinerja yang lebih menonjol. Penelitian mengungkapkan keterbatasan model yang ada dalam mengevaluasi penalaran matematis, terutama ketika model mencapai jawaban yang benar melalui langkah-langkah perantara yang salah, sehingga sulit untuk menilai secara akurat.

Sebagai tolok ukur pionir untuk mengevaluasi kemampuan model bahasa dalam mengidentifikasi kesalahan penalaran matematis, PROCESSBENCH memberikan kerangka kerja penting untuk penelitian masa depan dan mendorong pemahaman dan peningkatan AI dalam proses penalaran.

Pintu masuk kertas: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Kode: https://github.com/QwenLM/ProcessBench?tab=readme-ov-file

Secara keseluruhan, peluncuran benchmark PROCESSBENCH menyediakan alat yang lebih komprehensif dan mendalam untuk mengevaluasi kemampuan penalaran matematis model bahasa, membantu mendorong pengembangan penelitian di bidang ini dan pada akhirnya meningkatkan kinerja model bahasa dalam tugas-tugas penalaran yang kompleks.