Google resmi merilis TPU generasi keenam, Trillium, dan membukanya untuk pelanggan Google Cloud. Trillium adalah TPU Google yang paling kuat hingga saat ini dan digunakan untuk melatih Gemini 2.0, model AI paling kuatnya. Hal ini secara signifikan meningkatkan kinerja pelatihan, keluaran inferensi, dan efisiensi energi, sekaligus mencapai biaya yang lebih rendah. Artikel ini akan membahas secara mendalam peningkatan kinerja Trillium TPU, fitur-fitur utama, dan kinerja luar biasa dalam berbagai beban kerja AI, dan mendemonstrasikan kasus aplikasi praktisnya di antara pelanggan seperti AI21Labs.

Awal tahun ini, Google merilis Trillium, TPU generasi keenam dan terkuat hingga saat ini. Saat ini, Trillium secara resmi tersedia untuk pelanggan Google Cloud.

Google menggunakan Trillium TPU untuk melatih Gemini2.0 terbaru, yang merupakan model AI Google paling kuat hingga saat ini. Kini, perusahaan dan startup sama-sama dapat memanfaatkan infrastruktur yang kuat, efisien, dan berkelanjutan.

Inti dari superkomputer AI: Trillium TPU

Trillium TPU adalah komponen kunci dari Google Cloud AI Hypercomputer. AI Hypercomputer adalah arsitektur superkomputer terobosan yang memanfaatkan perangkat keras dengan kinerja optimal, perangkat lunak terbuka, kerangka kerja ML terkemuka, dan sistem integrasi model konsumsi yang fleksibel. Dengan peluncuran resmi Trillium TPU, Google juga telah melakukan peningkatan penting pada lapisan perangkat lunak terbuka AI Hypercomputer, termasuk mengoptimalkan kompiler XLA dan kerangka kerja populer seperti JAX, PyTorch, dan TensorFlow untuk mencapai harga/kinerja terdepan dalam pelatihan AI , penyetelan dan layanan.

Selain itu, fitur seperti host offload menggunakan DRAM host besar (memori bandwidth tinggi tambahan, atau HBM) memberikan tingkat efisiensi yang lebih tinggi. AI Hypercomputer memungkinkan Anda mengekstrak nilai maksimum dari penerapan lebih dari 100.000 chip Trillium yang belum pernah terjadi sebelumnya per arsitektur jaringan Jupiter dengan bandwidth dua arah 13 Petabit/detik dan kemampuan untuk menskalakan satu tugas pelatihan terdistribusi hingga ratusan ribu akselerator.

Pelanggan seperti AI21Labs telah menggunakan Trillium untuk memberikan solusi AI yang bermakna kepada pelanggan mereka dengan lebih cepat:

Barak Lenz, CTO AI21Labs, berkata: “Di AI21, kami terus berupaya meningkatkan performa dan efisiensi model bahasa Mamba dan Jamba. Sebagai pengguna jangka panjang TPU v4, kami terkesan dengan kemampuan Trillium Google Cloud. Dari segi skala, kecepatan, dan biaya Peningkatan efisiensi sangat signifikan. Kami yakin Trillium akan memainkan peran penting dalam mempercepat pengembangan model bahasa kompleks generasi berikutnya, sehingga memungkinkan kami menghadirkan solusi AI yang lebih canggih dan mudah diakses oleh pelanggan kami."

Kinerja Trillium telah meningkat pesat, dan banyak indikator telah mencetak rekor baru.

Dibandingkan dengan generasi sebelumnya, Trillium telah mengalami peningkatan signifikan dalam:

Performa pelatihan meningkat lebih dari 4 kali lipat

Peningkatan 3x dalam throughput inferensi

Efisiensi energi meningkat sebesar 67%

Peningkatan 4,7x dalam performa komputasi puncak per chip

Memori bandwidth tinggi (HBM) menggandakan kapasitasnya

Interkoneksi Antar-Chip (ICI) Menggandakan Bandwidth

Arsitektur jaringan Jupiter tunggal berisi 100.000 chip Trillium

Peningkatan kinerja pelatihan sebesar 2,5x per dolar dan peningkatan kinerja inferensi sebesar 1,4x per dolar

Penyempurnaan ini memungkinkan Trillium bekerja dengan baik di berbagai beban kerja AI, termasuk:

Menskalakan beban kerja pelatihan AI

Latih LLM, termasuk model padat dan model Pakar Campuran (MoE).

Kinerja inferensi dan penjadwalan kolektif

Menanamkan model padat

Memberikan pelatihan dan inferensi efektivitas biaya

Bagaimana kinerja Trillium di berbagai beban kerja?

Menskalakan beban kerja pelatihan AI

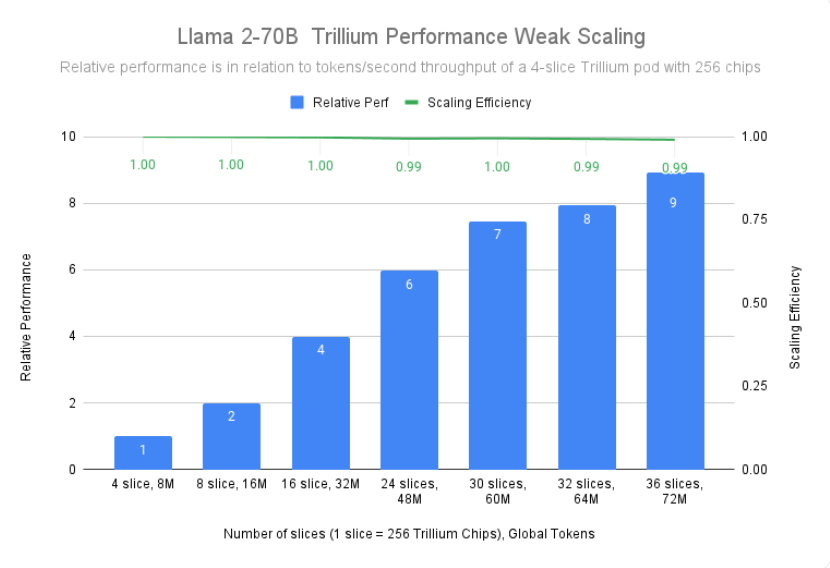

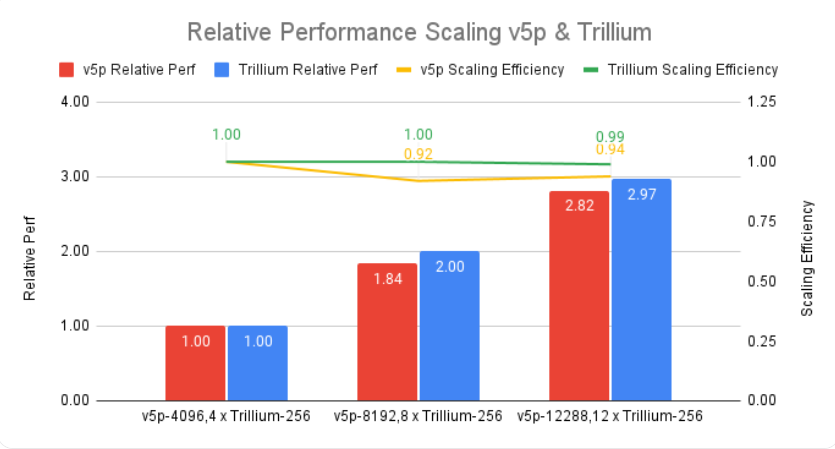

Melatih model besar seperti Gemini2.0 memerlukan banyak data dan komputasi. Skalabilitas mendekati linier Trillium memungkinkan model ini dilatih secara signifikan lebih cepat dengan mendistribusikan beban kerja secara efektif dan efisien ke beberapa host Trillium, terhubung melalui interkoneksi chip-ke-chip berkecepatan tinggi di 256-chip pod dan teknologi canggih kami dalam jaringan pusat data Jupiter. Hal ini dicapai melalui multi-chip TPU, teknologi full-stack untuk pelatihan skala besar, dan lebih dioptimalkan melalui Titanium, sistem offload tingkat pusat data dinamis yang berkisar dari adaptor host hingga arsitektur jaringan.

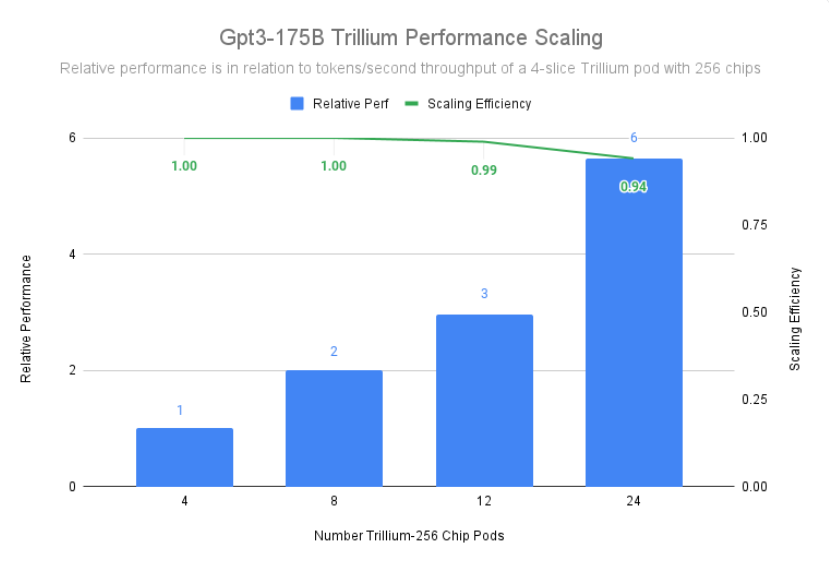

Trillium mencapai efisiensi penskalaan 99% dalam penerapan 12 pod dengan 3072 chip dan menunjukkan efisiensi penskalaan 94% dalam 24 pod dengan 6144 chip untuk melakukan pra-pelatihan gpt3-175b, bahkan di Hal yang sama juga berlaku saat dijalankan di seluruh jaringan pusat data.

Latih LLM, termasuk model padat dan model Pakar Campuran (MoE).

LLM seperti Gemini pada dasarnya kuat dan kompleks, dengan miliaran parameter. Pelatihan LLM intensif memerlukan daya komputasi yang sangat besar serta optimasi perangkat lunak yang dirancang bersama. Trillium 4 kali lebih cepat dibandingkan Cloud TPU v5e generasi sebelumnya saat melatih LLM intensif seperti Llama-2-70b dan gpt3-175b.

Selain LLM intensif, pendekatan yang semakin populer adalah melatih LLM menggunakan arsitektur pakar campuran (MoE), yang menggabungkan beberapa jaringan saraf “ahli”, yang masing-masing berspesialisasi dalam berbagai aspek tugas AI. Mengelola dan mengoordinasikan para ahli ini selama pelatihan menambah kompleksitas dibandingkan dengan melatih model monolitik tunggal. Trillium 3,8 kali lebih cepat dibandingkan Cloud TPU v5e generasi sebelumnya saat melatih model MoE.

Selain itu, Trillium TPU menyediakan memori akses acak dinamis (DRAM) host 3x dibandingkan dengan Cloud TPU v5e. Hal ini memindahkan beberapa komputasi ke host, membantu memaksimalkan kinerja skala besar dan throughput yang baik. Fitur pembongkaran host Trillium memberikan peningkatan kinerja lebih dari 50% dalam pemanfaatan model FLOP (MFU) saat melatih model Llama-3.1-405B.

Kinerja inferensi dan penjadwalan kolektif

Semakin pentingnya inferensi multi-langkah memerlukan akselerator yang dapat menangani peningkatan tuntutan komputasi secara efisien. Trillium memberikan kemajuan signifikan pada beban kerja inferensi, memungkinkan penerapan model AI lebih cepat dan efisien. Faktanya, Trillium memberikan kinerja inferensi TPU terbaik kami untuk difusi gambar dan LLM padat. Pengujian kami menunjukkan bahwa Stable Diffusion XL memiliki throughput inferensi relatif (gambar per detik) 3x lebih tinggi dibandingkan Cloud TPU v5e, sedangkan Llama2-70B memiliki throughput hampir 2 kali lipat.

Trillium adalah TPU kami yang berkinerja tertinggi untuk kasus penggunaan inferensi offline dan server. Gambar di bawah menunjukkan bahwa dibandingkan dengan Cloud TPU v5e, throughput relatif Stable Diffusion XL (gambar per detik) untuk inferensi offline adalah 3,1 kali lebih tinggi, dan throughput relatifnya untuk inferensi server adalah 2,9 kali lebih tinggi.

Selain performa yang lebih baik, Trillium juga memperkenalkan kemampuan penjadwalan kolektif baru. Fitur ini memungkinkan sistem penjadwalan Google membuat keputusan penjadwalan tugas yang cerdas guna meningkatkan ketersediaan dan efisiensi beban kerja inferensi secara keseluruhan ketika ada banyak replika dalam koleksi. Ini memberikan cara untuk mengelola beberapa irisan TPU yang menjalankan beban kerja inferensi host tunggal atau multi-host, termasuk melalui Google Kubernetes Engine (GKE). Mengelompokkan barang-barang ini ke dalam sebuah koleksi memudahkan penyesuaian jumlah replika untuk memenuhi permintaan.

Menanamkan model padat

Dengan menambahkan SparseCore generasi ketiga, Trillium meningkatkan kinerja model intensif penyematan sebesar 2x dan DLRM DCNv2 sebesar 5x.

SparseCore adalah pemroses aliran data yang menyediakan fondasi arsitektur yang lebih mudah beradaptasi untuk beban kerja intensif yang tertanam. SparseCore generasi ketiga Trillium unggul dalam mempercepat operasi dinamis dan terkait data seperti pengumpulan sebar, jumlah segmen jarang, dan partisi.

Memberikan pelatihan dan inferensi efektivitas biaya

Selain performa dan skala yang diperlukan untuk melatih beberapa beban kerja AI terbesar di dunia, Trillium dirancang untuk mengoptimalkan performa per dolar. Hingga saat ini, Trillium telah mencapai performa per dolar 2,1x lebih baik dibandingkan Cloud TPU v5e dan 2,5x lebih baik dibandingkan Cloud TPU v5p saat melatih LLM intensif seperti Llama2-70b dan Llama3.1-405b.

Trillium unggul dalam pemrosesan model besar secara paralel yang hemat biaya. Hal ini dirancang untuk memungkinkan peneliti dan pengembang menghasilkan model gambar yang kuat dan efisien dengan biaya yang jauh lebih rendah dibandingkan sebelumnya. Biaya pembuatan seribu gambar di Trillium 27% lebih rendah dibandingkan Cloud TPU v5e untuk inferensi offline, dan 22% lebih rendah dibandingkan Cloud TPU v5e untuk inferensi server di SDXL.

Membawa inovasi AI ke tingkat berikutnya

Trillium mewakili lompatan besar dalam infrastruktur AI Google Cloud, memberikan performa, skalabilitas, dan efisiensi luar biasa untuk berbagai beban kerja AI. Dengan kemampuannya untuk menskalakan ratusan ribu chip menggunakan perangkat lunak desain bersama kelas dunia, Trillium memungkinkan Anda mencapai terobosan yang lebih cepat dan memberikan solusi AI yang unggul. Selain itu, harga/kinerja Trillium yang luar biasa menjadikannya pilihan hemat biaya bagi organisasi yang ingin memaksimalkan nilai investasi AI mereka. Seiring dengan terus berkembangnya lanskap AI, Trillium menunjukkan komitmen Google Cloud dalam menyediakan infrastruktur mutakhir untuk membantu perusahaan memaksimalkan potensi AI.

Pengenalan resmi: https://cloud.google.com/blog/products/compute/trillium-tpu-is-ga

Secara keseluruhan, kemunculan Trillium TPU menandai peningkatan signifikan dalam kemampuan komputasi AI cloud. Performanya yang kuat, skalabilitas, dan manfaat ekonominya akan mendorong pengembangan yang lebih cepat di bidang AI dan menyediakan solusi AI yang lebih canggih bagi perusahaan dan lembaga penelitian.