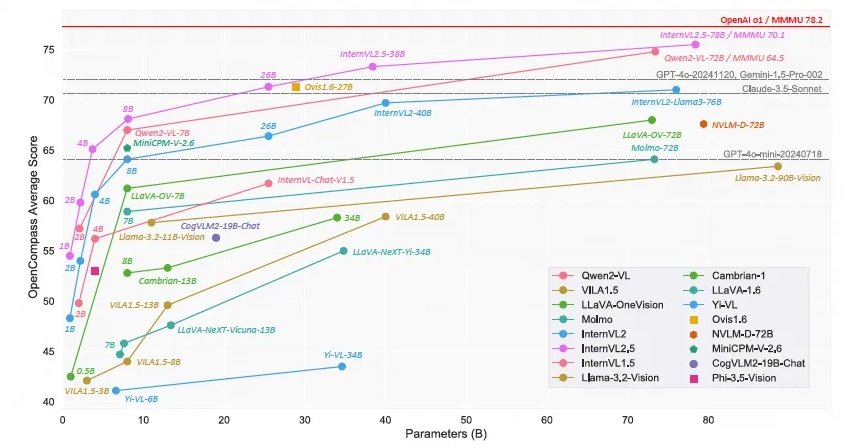

Shanghai AI Laboratory telah meluncurkan model bahasa skala besar multi-modal open source - Scholar·Wanxiang InternVL2.5. Kinerjanya telah mencapai akurasi lebih dari 70% pada tolok ukur pemahaman multi-modal (MMMU), yang sebanding dengan Model GPT-4o dan Claude- Komersial seperti 3.5-Sonnet memiliki kinerja yang sebanding. Model InternVL2.5 menggunakan teknologi penalaran pemikiran berantai untuk menunjukkan kinerja yang kuat dalam berbagai tes benchmark, terutama dalam penalaran multidisiplin, pemahaman dokumen, dan deteksi halusinasi multimodal. Sifat open source dari model ini akan sangat mendorong pengembangan dan inovasi teknologi AI multimodal.

Baru-baru ini, Laboratorium AI Shanghai mengumumkan peluncuran model Scholar·Wanxiang InternVL2.5. Dengan kinerjanya yang luar biasa, model bahasa multimodal berskala besar sumber terbuka ini menjadi model sumber terbuka pertama yang akurasinya melebihi 70% pada Multi-modal Understanding Benchmark (MMMU), bersaing dengan model komersial seperti GPT-4o dan Claude -3.5-Soneta Performa yang sebanding.

Model InternVL2.5 mencapai peningkatan sebesar 3,7 poin persentase melalui teknologi penalaran Chain of Thinking (CoT), yang menunjukkan potensi skalabilitas waktu pengujian yang kuat. Model ini dikembangkan lebih lanjut berdasarkan InternVL2.0, yang selanjutnya meningkatkan kinerja dengan meningkatkan strategi pelatihan dan pengujian serta meningkatkan kualitas data. Penelitian mendalam dilakukan pada encoder visual, model bahasa, ukuran kumpulan data, dan konfigurasi waktu pengujian untuk mengeksplorasi hubungan antara ukuran model dan performa.

InternVL2.5 menunjukkan kinerja kompetitif dalam berbagai tolok ukur, terutama dalam penalaran multidisiplin, pemahaman dokumen, pemahaman multi-gambar/video, pemahaman dunia nyata, deteksi halusinasi multi-modal, landasan visual, kemampuan multi-bahasa, dan pemrosesan bahasa murni. dan bidang lainnya. Pencapaian ini tidak hanya memberikan standar baru bagi komunitas open source untuk pengembangan dan penerapan sistem AI multi-modal, namun juga membuka kemungkinan baru untuk penelitian dan penerapan di bidang kecerdasan buatan.

InternVL2.5 mempertahankan arsitektur model yang sama dengan pendahulunya InternVL1.5 dan InternVL2.0, mengikuti paradigma "ViT-MLP-LLM", dan mengimplementasikan integrasi InternViT-6B atau InternViT-300M yang telah dilatih sebelumnya secara bertahap dengan berbagai LLM terlatih dengan berbagai ukuran dan tipe diintegrasikan bersama menggunakan proyektor MLP dua lapis yang diinisialisasi secara acak. Untuk meningkatkan skalabilitas pemrosesan resolusi tinggi, tim peneliti menerapkan operasi pengocokan piksel untuk mengurangi jumlah token visual menjadi setengah dari jumlah aslinya.

Sifat model open source berarti peneliti dan pengembang dapat dengan bebas mengakses dan menggunakan InternVL2.5, yang akan sangat mendorong pengembangan dan inovasi teknologi AI multi-modal.

Tautan model:

https://www.modelscope.cn/collections/InternVL-25-fbde6e47302942

Rilis open source InternVL2.5 menyediakan sumber daya berharga untuk penelitian AI multi-modal. Performa dan skalabilitasnya yang luar biasa diharapkan dapat mendorong terobosan lebih lanjut di bidang ini dan mendorong lahirnya aplikasi yang lebih inovatif. Berharap untuk melihat hasil yang lebih mengejutkan berdasarkan InternVL2.5 di masa depan.