Model bahasa visual terbuka terbaru dari NVIDIA, NVILA, telah mencapai terobosan signifikan dalam akurasi dan efisiensi, menjadi tonggak sejarah lainnya di bidang AI visual. Dibandingkan dengan model visi skala besar lainnya, NVILA telah mencapai pengurangan yang signifikan dalam biaya pelatihan, penggunaan memori, dan latensi. NVILA juga menunjukkan kinerja yang sangat baik dalam berbagai pengujian benchmark, bahkan melampaui beberapa pesaing. Artikel ini memperkenalkan detail teknis NVILA secara mendetail, termasuk teknologi "ekspansi terlebih dahulu dan kompresi kemudian" serta ekspansi S2 dinamis, pemangkasan kumpulan data berbasis DeltaLoss, dan strategi pengoptimalan lainnya, yang bertujuan untuk menyeimbangkan keakuratan dan efisiensi model. Hal ini menandai berkembangnya teknologi model bahasa visual ke arah yang lebih ekonomis dan efisien.

Baru-baru ini, NVIDIA meluncurkan model bahasa visual terbuka generasi baru - NVILA. Dirancang untuk mengoptimalkan akurasi dan efisiensi, ia telah menjadi pemimpin di bidang AI visual dengan kinerjanya yang luar biasa.

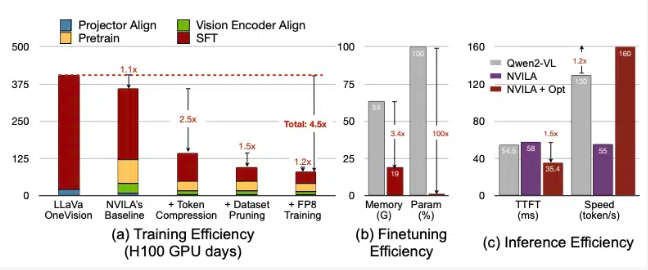

Menurut NVIDIA, NVILA mengurangi biaya pelatihan sebesar 4,5 kali lipat, mengurangi memori yang diperlukan untuk fine-tuning sebesar 3,4 kali lipat, dan mengurangi latensi pra-pengisian dan decoding hampir 2 kali lipat. Data ini dibandingkan dengan model visi besar lainnya, LLaVa OneVision.

Dalam benchmark video, NVILA mengungguli GPT4o Mini, dan juga berkinerja baik dibandingkan dengan GPT4o, Sonnet3.5, dan Gemini1.5Pro. Selain itu, NVILA juga meraih sedikit kemenangan dibandingkan dengan Llama3.2. Meskipun demikian, NVIDIA menyatakan bahwa model tersebut belum dirilis ke platform Hugging Face, dan mereka berjanji akan segera merilis kode dan model untuk mempromosikan reproduktifitas model tersebut.

NVIDIA menunjukkan bahwa biaya pelatihan model bahasa visual sangat tinggi. Dibutuhkan sekitar 400 hari GPU untuk melatih model bahasa visual parameter 7B. Pada saat yang sama, menyempurnakan model seperti itu juga sangat memakan banyak memori, dengan model parameter 7B memerlukan lebih dari 64 GB memori GPU.

Oleh karena itu, NVIDIA menggunakan teknik yang disebut expand-then-compress untuk menyeimbangkan akurasi dan efisiensi model. Alih-alih memperkecil ukuran foto dan video, model ini menggunakan beberapa bingkai dari gambar dan video beresolusi tinggi untuk memastikan tidak ada detail yang hilang.

Selama proses kompresi, model mengurangi ukuran data masukan dengan mengompresi informasi visual menjadi lebih sedikit token dan mengelompokkan piksel untuk menyimpan informasi penting. NVIDIA menyebutkan dalam makalahnya bahwa menggandakan resolusi akan menggandakan jumlah token visual, yang akan meningkatkan biaya pelatihan dan inferensi lebih dari 2 kali lipat. Oleh karena itu, mereka mengurangi biaya ini dengan mengompresi token ruang/waktu.

NVIDIA juga menunjukkan demonstrasi beberapa model, dan NVILA dapat menjawab banyak pertanyaan berdasarkan gambar atau video. Hasil keluarannya juga dibandingkan dengan model VILA1.5 yang sebelumnya dirilis oleh NVIDIA. Selain itu, NVIDIA juga memperkenalkan beberapa teknologi lain secara detail, seperti ekspansi S2 dinamis, pemangkasan kumpulan data berbasis DeltaLoss, kuantisasi menggunakan presisi FP8, dll.

Teknik ini diterapkan pada model parameter 8B, dan detail spesifiknya dapat dilihat di Arxiv.

Pintu masuk makalah: https://arxiv.org/pdf/2412.04468

Menyorot:

? Model NVILA mengurangi biaya pelatihan sebesar 4,5 kali lipat, meningkatkan efisiensi AI visual.

? Dengan gambar dan bingkai video beresolusi tinggi, NVILA memastikan integritas informasi masukan.

? NVIDIA berjanji akan segera merilis kode dan model untuk mendorong reproduktifitas penelitian.

Secara keseluruhan, kemunculan NVILA telah membawa kemungkinan baru dalam pengembangan model bahasa visual. Proses pelatihan dan inferensinya yang efisien akan menurunkan ambang batas penerapan AI visual dan mendorong pengembangan lebih lanjut di bidang ini. Kami menantikan pengungkapan awal kode dan model NVIDIA sehingga lebih banyak peneliti dapat berpartisipasi dan bersama-sama mempromosikan kemajuan teknologi AI visual.