Tim pidato dari Alibaba Tongyi Lab telah meluncurkan CosyVoice 2.0. Model pembuatan pidato sumber terbuka yang besar ini telah membuat terobosan signifikan dalam teknologi sintesis ucapan. Dibandingkan dengan versi generasi sebelumnya, CosyVoice 2.0 telah meningkatkan akurasi, stabilitas, dan kealamian secara signifikan, mewujudkan sintesis ucapan streaming dua arah, dan secara signifikan mengurangi penundaan sintesis. Peningkatan ini tidak hanya tercermin pada tingkat teknis, tetapi juga membawa lompatan kualitatif dalam pengalaman pengguna, memberikan layanan sintesis ucapan yang lebih kaya dan nyaman kepada pengguna.

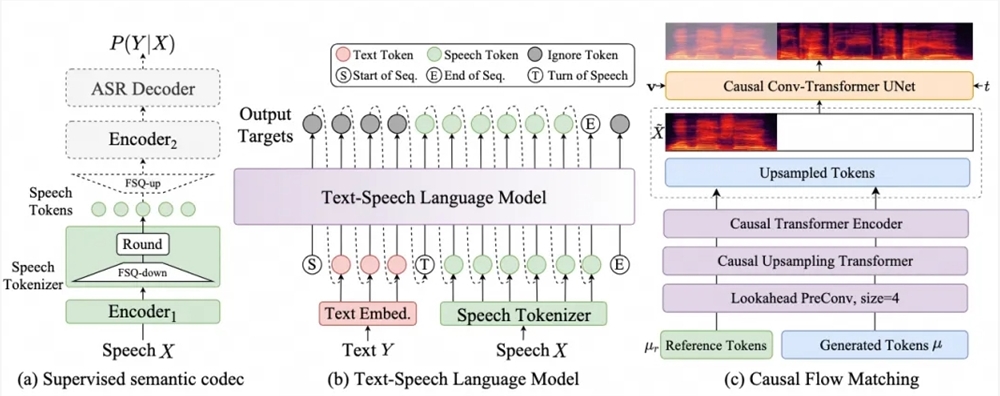

Tim pidato dari Alibaba Tongyi Lab mengumumkan bahwa model pembuatan pidato sumber terbuka yang besar, CosyVoice, telah ditingkatkan ke versi 2.0. Peningkatan ini menandai peningkatan yang signifikan dalam akurasi, stabilitas, dan pengalaman alami teknologi pembuatan ucapan. CosyVoice2.0 mengadopsi teknologi model besar pembangkitan ucapan yang mengintegrasikan pemodelan offline dan streaming untuk mencapai sintesis ucapan streaming dua arah. Penundaan sintesis paket pertama dapat mencapai 150 ms, yang secara signifikan meningkatkan kecepatan respons sintesis ucapan.

Dalam hal akurasi pengucapan, CosyVoice2.0 memiliki pengurangan tingkat kesalahan sebesar 30% hingga 50% dibandingkan versi sebelumnya. Ini telah mencapai tingkat kesalahan kata terendah pada set tes keras set tes Seed-TTS, terutama dalam bahasa sintetis twister, Performa luar biasa dalam karakter polifonik dan karakter langka. Selain itu, versi 2.0 mempertahankan konsistensi timbre dalam pembuatan ucapan tanpa sampel dan sintesis ucapan lintas bahasa. Secara khusus, kemampuan sintesis ucapan lintas bahasa telah ditingkatkan secara signifikan dibandingkan dengan versi 1.0.

CosyVoice2.0 juga meningkatkan ritme, kualitas suara, dan kecocokan emosional dari audio yang disintesis. Skor evaluasi MOS meningkat dari 5,4 menjadi 5,53, mendekati skor model sintesis ucapan komersial besar. Pada saat yang sama, versi 2.0 mendukung kontrol emosi dan kontrol aksen dialek yang lebih halus, memberikan pengguna pilihan bahasa yang lebih kaya, termasuk dialek utama seperti dialek Kanton, dialek Sichuan, dialek Zhengzhou, dialek Tianjin, dan dialek Changsha, serta peran- fungsi bermain seperti meniru robot, gaya bicara Peppa Pig, dll.

Peningkatan CosyVoice2.0 tidak hanya meningkatkan teknologi dan pengalaman sintesis ucapan, namun juga lebih lanjut mendorong pengembangan komunitas sumber terbuka dan mendorong lebih banyak pengembang untuk berpartisipasi dalam inovasi dan penerapan teknologi pemrosesan ucapan.

Repositori GitHub: CosyVoice (https://github.com/FunAudioLLM/CosyVoice) Lihat CosyVoice2 terbaru yang diperbarui

Rasakan DEMO online: https://www.modelscope.cn/studios/iic/CosyVoice2-0.5B

Kode sumber terbuka: https://github.com/FunAudioLLM/CosyVoice

Model sumber terbuka: https://www.modelscope.cn/models/iic/CosyVoice2-0.5B

Sumber terbuka CosyVoice 2.0 akan lebih mendorong pemasyarakatan dan pengembangan teknologi sintesis ucapan, menyediakan alat dan sumber daya yang canggih bagi pengembang dan peneliti, dan menantikan munculnya aplikasi yang lebih inovatif. Selamat datang untuk mengunjungi tautan yang disediakan untuk merasakan dan mengunduh.