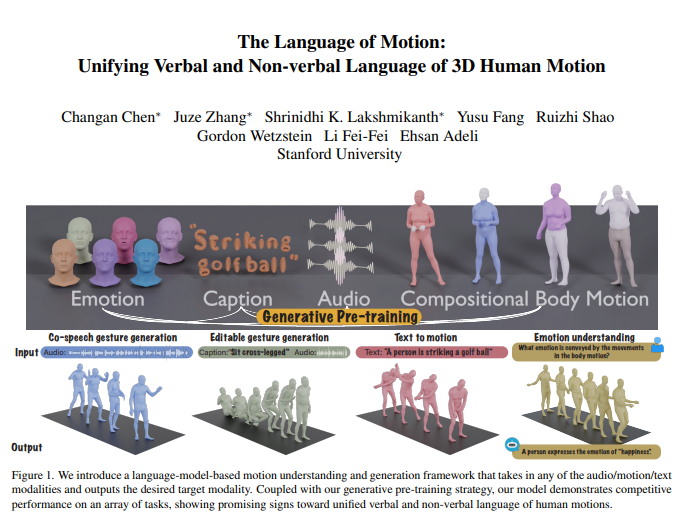

Tim Li Feifei baru-baru ini merilis hasil penelitian terobosan: model multi-modal baru yang dapat memahami dan menghasilkan tindakan manusia, dan secara cerdik menggabungkan model bahasa untuk mencapai pemrosesan terpadu bahasa verbal dan non-verbal. Inovasi ini tidak hanya memungkinkan mesin memahami instruksi manusia, namun juga menafsirkan emosi di balik tindakan, sehingga mencapai interaksi manusia-komputer yang lebih alami dan lancar. Inti dari model ini terletak pada kerangka model bahasa multi-modal, yang dapat mengintegrasikan banyak masukan seperti audio, gerakan dan teks, dan mengeluarkan data modal yang sesuai. Teknologi ini bekerja dengan baik pada tugas-tugas seperti pembuatan isyarat bicara kolaboratif, secara signifikan mengurangi jumlah data yang diperlukan untuk pelatihan model, dan memperluas skenario aplikasi baru seperti pembuatan isyarat yang dapat diedit dan prediksi emosi melalui tindakan.

Tim Li Feifei meluncurkan model multi-modal baru yang dapat memahami dan menghasilkan tindakan manusia, dan dengan menggabungkan model bahasa, model ini mencapai pemrosesan bahasa verbal dan non-verbal yang terpadu. Penelitian terobosan ini memungkinkan mesin tidak hanya memahami instruksi manusia, namun juga membaca emosi yang terkandung dalam tindakan, sehingga memungkinkan interaksi manusia-komputer yang lebih alami.

Inti dari model ini terletak pada kerangka model bahasa multi-modal, yang dapat menerima berbagai bentuk masukan seperti audio, gerakan dan teks, dan mengeluarkan data modal yang diperlukan. Dikombinasikan dengan strategi pra-pelatihan generatif, model ini menunjukkan kinerja luar biasa dalam banyak tugas. Misalnya, dalam pembuatan gerakan ucapan kolaboratif, model ini tidak hanya melampaui yang tercanggih tetapi juga secara signifikan mengurangi jumlah data yang diperlukan untuk pelatihan. Selain itu, model ini juga membuka skenario aplikasi baru, seperti pembuatan isyarat yang dapat diedit dan prediksi emosi melalui tindakan.

Komunikasi manusia bersifat multimodal dan mencakup isyarat verbal dan non-verbal seperti ucapan, ekspresi wajah, dan postur tubuh. Kemampuan model ini untuk memahami perilaku multimodal sangat penting untuk menciptakan karakter virtual yang berkomunikasi secara alami dalam aplikasi seperti game, film, dan realitas virtual. Namun, model pembuatan tindakan yang ada seringkali terbatas pada modalitas masukan tertentu (data ucapan, teks, atau tindakan) dan gagal memanfaatkan sepenuhnya keragaman data yang tersedia.

Model ini memanfaatkan model bahasa untuk menyatukan bahasa verbal dan nonverbal karena tiga alasan utama:

Model bahasa secara alami menghubungkan modalitas yang berbeda.

Pidato sangat semantik, dan tugas-tugas seperti memodelkan respons terhadap lelucon memerlukan kemampuan penalaran semantik yang kuat.

Model bahasa memperoleh kemampuan pemahaman semantik yang kuat melalui pra-pelatihan yang ekstensif.

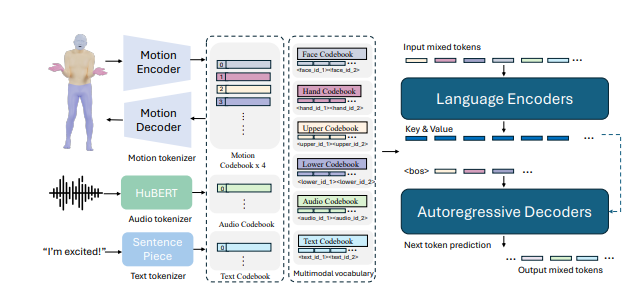

Untuk mencapai hal ini, tim peneliti pertama-tama membagi tubuh menjadi beberapa bagian (wajah, tangan, tubuh bagian atas, tubuh bagian bawah) dan memberi label pada setiap bagian secara individual untuk pergerakannya. Dengan menggabungkan tokenizer teks dan ucapan, masukan dalam modalitas apa pun dapat direpresentasikan sebagai serangkaian token untuk digunakan oleh model bahasa. Model ini mengadopsi proses pelatihan dua tahap: pra-pelatihan pertama untuk mencapai keselarasan berbagai modalitas dengan gabungan gerakan tubuh, serta keselarasan audio dan teks. Setelah itu, tugas hilir diubah menjadi instruksi dan model dilatih berdasarkan instruksi tersebut sehingga dapat mengikuti berbagai instruksi tugas.

Model ini memiliki kinerja yang baik pada tolok ukur pembuatan gerakan ucapan kolaboratif BEATv2, jauh melebihi model yang sudah ada. Efek dari strategi pra-pelatihan juga telah diverifikasi, terutama ketika data terbatas, dan menunjukkan kemampuan generalisasi yang kuat. Dengan pasca-pelatihan tentang tugas tindakan ucapan dan tindakan teks, model tidak hanya dapat mengikuti perintah audio dan teks, namun juga mencapai fungsi baru seperti memprediksi emosi dari data tindakan.

Secara teknis, model ini menggunakan tokenizer khusus modalitas untuk menangani berbagai modalitas masukan. Secara khusus, model ini melatih gabungan gerakan tubuh VQ-VAE yang mengubah gerakan wajah, tangan, tubuh bagian atas, dan tubuh bagian bawah menjadi penanda terpisah. Kosakata khusus modalitas ini (audio dan teks) digabungkan menjadi kosakata multimodal terpadu. Selama pelatihan, token campuran dari modalitas berbeda digunakan sebagai masukan dan keluaran dihasilkan oleh model bahasa encoder-decoder.

Model ini juga menggunakan kosakata multimodal untuk mengubah data modal yang berbeda menjadi format terpadu untuk diproses. Pada tahap pra-pelatihan, model mempelajari korespondensi antara modalitas yang berbeda dengan melakukan tugas konversi antar modalitas. Misalnya, seorang model dapat belajar menerjemahkan gerakan tubuh bagian atas menjadi gerakan tubuh bagian bawah, atau mengubah audio menjadi teks. Selain itu, model ini mempelajari evolusi temporal tindakan dengan menutupi kerangka tindakan tertentu secara acak.

Pada fase pasca-pelatihan, model disempurnakan menggunakan data berpasangan untuk melakukan tugas-tugas hilir seperti pembuatan gerakan ucapan kolaboratif atau pembuatan teks menjadi tindakan. Untuk memungkinkan model mengikuti instruksi alami manusia, para peneliti membuat template berikut instruksi multi-tugas yang mengubah tugas seperti audio-to-action, text-to-action, dan emosi-to-action menjadi instruksi. Model ini juga memiliki kemampuan untuk mengedit gerakan untuk menghasilkan gerakan seluruh tubuh yang terkoordinasi berdasarkan isyarat teks dan audio.

Terakhir, model ini juga membuka kemampuan baru untuk memprediksi emosi dari tindakan. Hal ini memiliki implikasi penting pada bidang-bidang seperti kesehatan mental atau psikiatri. Model ini mampu memprediksi emosi yang diungkapkan dalam tindakan dengan lebih akurat dibandingkan model lainnya, menunjukkan kemampuan pemahaman bahasa tubuh yang kuat.

Penelitian menunjukkan bahwa menyatukan bahasa verbal dan non-verbal dalam tindakan manusia sangat penting untuk penerapan praktis, dan model bahasa memberikan kerangka kerja yang kuat untuk hal ini.

Alamat makalah: https://arxiv.org/pdf/2412.10523v1

Secara keseluruhan, penelitian ini telah membawa kemajuan yang signifikan di bidang kecerdasan buatan multi-modal. Potensi penerapannya dalam interaksi manusia-komputer, pembuatan karakter virtual, dan pengenalan emosi sangat besar dan memerlukan perhatian dan penelitian lebih lanjut. Kedepannya, model ini diharapkan dapat berperan di lebih banyak bidang dan mendorong perkembangan teknologi kecerdasan buatan.