NVIDIA dengan cepat meluncurkan GPU GB300 dan B300, mencapai peningkatan kinerja yang signifikan hanya setengah tahun setelah rilis GB200 dan B200, terutama pada model inferensi. Ini bukan hanya sekedar peningkatan perangkat keras sederhana, namun juga mewakili penyesuaian tata letak strategis NVIDIA di bidang akselerasi AI, yang akan berdampak besar pada industri. Inti dari peningkatan ini terletak pada lompatan besar dalam performa inferensi, serta optimalisasi memori dan arsitektur, yang secara langsung akan memengaruhi efisiensi dan biaya model bahasa besar.

Hanya 6 bulan setelah rilis GB200 dan B200, Nvidia kembali meluncurkan GPU baru-GB300 dan B300. Ini mungkin tampak seperti peningkatan kecil, namun sebenarnya ini mengandung perubahan besar, terutama peningkatan signifikan pada kinerja model inferensi, yang akan berdampak besar pada keseluruhan industri.

B300/GB300: Lompatan besar dalam performa inferensi

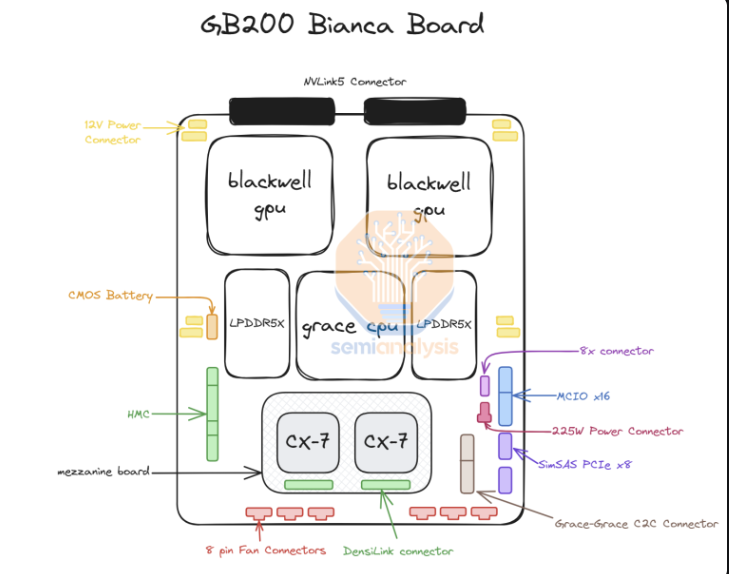

B300GPU menggunakan node proses 4NP TSMC dan dioptimalkan untuk chip komputasi. Hal ini membuat kinerja FLOPS B300 50% lebih tinggi dibandingkan B200. Peningkatan kinerja sebagian berasal dari peningkatan TDP. TDP GB300 dan B300HGX masing-masing mencapai 1,4KW dan 1,2KW (GB200 dan B200 masing-masing 1,2KW dan 1KW). Peningkatan performa lainnya berasal dari penyempurnaan arsitektur dan optimalisasi tingkat sistem, seperti alokasi daya dinamis antara CPU dan GPU.

Selain peningkatan FLOPS, memori juga ditingkatkan menjadi 12-Hi HBM3E, dan kapasitas HBM masing-masing GPU ditingkatkan menjadi 288GB. Namun kecepatan pinnya tetap tidak berubah, sehingga bandwidth memori per GPU tetap 8 TB/s. Perlu dicatat bahwa Samsung gagal memasuki rantai pasokan GB200 atau GB300.

Selain itu, Nvidia juga melakukan penyesuaian harga. Hal ini akan mempengaruhi margin keuntungan produk Blackwell sampai batas tertentu, namun yang lebih penting, peningkatan kinerja B300/GB300 terutama akan tercermin dalam model inferensi.

Disesuaikan untuk model inferensi

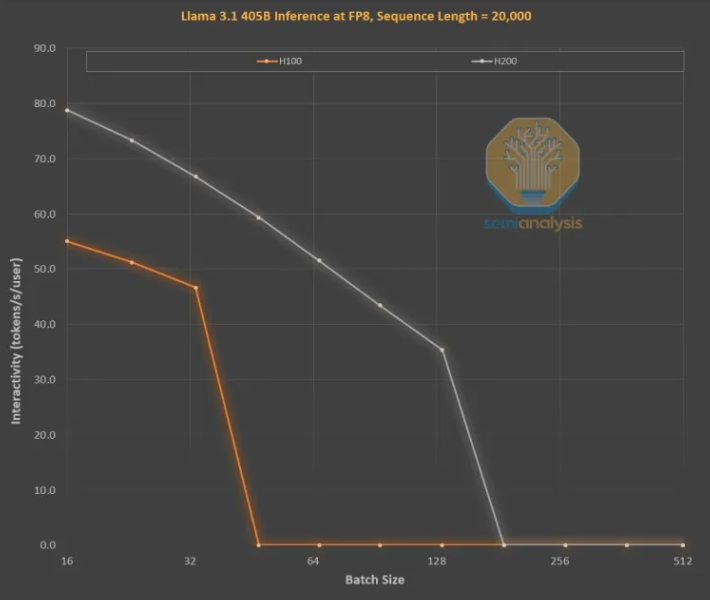

Peningkatan memori sangat penting untuk pelatihan inferensi LLM gaya OpenAI O3, karena urutan yang panjang meningkatkan KVCache, sehingga membatasi ukuran batch dan latensi kritis. Peningkatan dari H100 ke H200 (terutama peningkatan memori) telah membawa perbaikan pada dua aspek berikut:

Bandwidth memori yang lebih tinggi (4,8TB/dtk pada H200 dan 3,35TB/dtk pada H100) menghasilkan peningkatan interaktivitas secara umum sebesar 43% di semua ukuran batch yang sebanding.

Karena H200 menjalankan ukuran batch yang lebih besar daripada H100, jumlah token yang dihasilkan per detik meningkat 3 kali lipat, dan biaya berkurang sekitar 3 kali lipat. Perbedaan ini terutama disebabkan oleh KVCache yang membatasi total ukuran batch.

Peningkatan kinerja dari kapasitas memori yang lebih besar sangatlah besar. Perbedaan performa dan ekonomis antara kedua GPU ini jauh lebih besar dibandingkan spesifikasinya:

Pengalaman pengguna dengan model inferensi bisa jadi buruk karena terdapat latensi yang signifikan antara permintaan dan respons. Jika waktu inferensi dapat dipercepat secara signifikan, kesediaan pengguna untuk menggunakan dan membayar akan meningkat.

Peningkatan kinerja perangkat keras sebesar 3x lipat dari peningkatan memori generasi menengah sungguh menakjubkan dan jauh lebih cepat dibandingkan Hukum Moore, Hukum Huang, atau peningkatan perangkat keras lainnya yang pernah kami lihat.

Secara keseluruhan, peluncuran NVIDIA B300/GB300 bukan hanya merupakan lompatan lain dalam teknologi GPU, tetapi juga merupakan promosi yang kuat atas penerapan model inferensi AI. Hal ini akan sangat meningkatkan pengalaman pengguna dan mengurangi biaya, sehingga memimpin industri AI memasuki tahap perkembangan baru.