Melatih model AI berukuran besar membutuhkan biaya yang besar dan kebutuhan sumber daya yang besar membatasi penerapannya secara luas serta meningkatkan kekhawatiran mengenai efisiensi energi dan dampak lingkungan. Metode pelatihan tradisional tidak efisien, bergantung pada matriks yang padat, dan memerlukan memori dan daya komputasi dalam jumlah besar. Meskipun beberapa metode yang ada mencoba untuk mengatasi masalah ini, metode tersebut masih memiliki keterbatasan dalam penerapan praktisnya. Oleh karena itu, sangat penting untuk mengembangkan pendekatan yang secara bersamaan dapat mengurangi penggunaan memori, biaya komputasi, dan waktu pelatihan tanpa mengurangi kinerja.

Melatih model AI skala besar (seperti Transformers dan model bahasa) telah menjadi mata rantai utama yang sangat diperlukan di bidang AI, namun juga menghadapi biaya komputasi yang tinggi, konsumsi memori, dan kebutuhan energi. Misalnya, GPT-3 OpenAI memiliki 175 miliar parameter dan memerlukan pelatihan GPU selama berminggu-minggu. Kebutuhan sumber daya yang besar ini membatasi penerapan teknologi ini pada organisasi berskala besar dengan sumber daya komputasi yang melimpah, sekaligus memperburuk kekhawatiran mengenai efisiensi energi dan dampak lingkungan. Mengatasi tantangan-tantangan ini sangat penting untuk memastikan aksesibilitas yang lebih luas dan keberlanjutan pengembangan AI.

Metode pelatihan tradisional tidak efisien dan solusi inovatif sangat dibutuhkan

Kerangka kerja CoMERA: Pelatihan yang efisien melalui optimalisasi tensor adaptif

Fondasi CoMERA adalah representasi tensor adaptif, yang memungkinkan lapisan model menyesuaikan peringkatnya secara dinamis berdasarkan batasan sumber daya. Dengan memodifikasi peringkat tensor, kerangka kerja ini memungkinkan kompresi tanpa mengorbankan integritas operasional jaringan saraf. Pengoptimalan dinamis ini dicapai melalui proses pelatihan dua tahap:

Tahap awal: fokus pada konvergensi yang stabil.

Tahap selanjutnya: menyempurnakan peringkat untuk memenuhi sasaran kompresi tertentu.

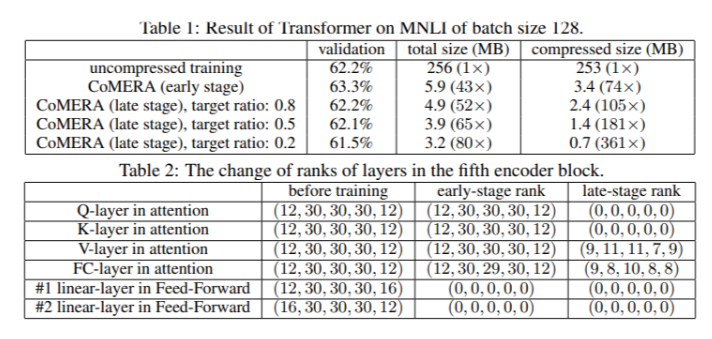

Dalam model Transformer enam encoder, CoMERA mencapai rasio kompresi hingga 43x pada tahap awal, dan rasio kompresi yang lebih tinggi lagi yaitu 361x pada tahap pengoptimalan selanjutnya. Selain itu, ini mengurangi konsumsi memori sebanyak 9 kali lipat dan mempercepat pelatihan sebanyak 2-3 kali per putaran dibandingkan dengan GaLore.

Hasil pengujian berulang kali menunjukkan bahwa CoMERA memiliki kinerja yang sangat baik

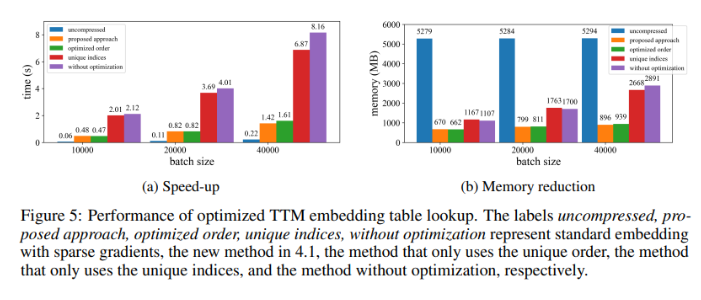

Saat diterapkan pada model Transformer yang dilatih pada kumpulan data MNLI, CoMERA mengurangi ukuran model dari 256 MB menjadi 3,2 MB dengan tetap menjaga akurasi. Dalam sistem pemberi rekomendasi skala besar seperti DLRM, CoMERA mengompresi model sebesar 99x dan mengurangi penggunaan memori puncak sebesar 7x. Kerangka kerja ini juga bekerja dengan baik dalam CodeBERT pra-pelatihan, model bahasa skala besar khusus domain, mencapai rasio kompresi keseluruhan sebesar 4,23x dan mencapai percepatan 2x dalam beberapa tahap pelatihan. Hasil ini menyoroti kemampuannya untuk menangani berbagai tugas dan arsitektur, serta memperluas penerapannya di berbagai bidang.

Ringkasan manfaat utama kerangka CoMERA

Kesimpulan utama dari penelitian ini adalah sebagai berikut:

CoMERA mencapai rasio kompresi hingga 361x untuk lapisan tertentu dan 99x untuk keseluruhan model, sehingga secara signifikan mengurangi kebutuhan penyimpanan dan memori.

Kerangka kerja ini mempersingkat waktu pelatihan setiap putaran Transformer dan sistem rekomendasi sebanyak 2-3 kali lipat, sehingga menghemat sumber daya dan waktu komputasi.

Dengan menggunakan representasi tensorisasi dan grafik CUDA, CoMERA mengurangi konsumsi memori puncak sebesar 7x, sehingga memungkinkan pelatihan pada GPU yang lebih kecil.

Pendekatan CoMERA mendukung berbagai arsitektur, termasuk Transformers dan model bahasa besar, dengan tetap menjaga atau meningkatkan akurasi.

Dengan mengurangi energi dan sumber daya yang dibutuhkan untuk pelatihan, CoMERA membantu memungkinkan praktik AI yang lebih berkelanjutan dan menyediakan model-model mutakhir untuk khalayak yang lebih luas.

Secara keseluruhan, kerangka kerja CoMERA memberikan solusi terobosan untuk melatih model AI besar secara efisien, yang secara signifikan mengurangi biaya komputasi dan kebutuhan memori melalui optimalisasi tensor adaptif sambil menjaga akurasi model. Penelitian ini memberikan kontribusi penting terhadap pengembangan berkelanjutan dan aksesibilitas yang lebih luas di bidang AI.