Tim Qwen telah membuat model penalaran multi-modal terbaru QVQ menjadi open source, yang dibangun di atas Qwen2-VL-72B dan secara signifikan meningkatkan pemahaman visual dan kemampuan penalaran AI. QVQ mencapai skor tinggi 70,3 pada tes MMMU dan melampaui model pendahulunya dalam berbagai tolok ukur matematika. Artikel ini akan memperkenalkan secara rinci karakteristik, kelebihan, keterbatasan dan penggunaan model QVQ, serta menyediakan tautan yang relevan untuk memudahkan pembaca lebih memahami dan menggunakannya.

Tim Qwen baru-baru ini mengumumkan open source model penalaran multi-modal terbaru QVQ, menandai langkah penting dalam pemahaman visual kecerdasan buatan dan kemampuan pemecahan masalah yang kompleks. Model ini dibangun di atas Qwen2-VL-72B dan bertujuan untuk meningkatkan kemampuan penalaran AI dengan menggabungkan bahasa dan informasi visual. Dalam evaluasi MMMU, QVQ mencapai skor tinggi 70,3 dan menunjukkan peningkatan kinerja yang signifikan dibandingkan dengan Qwen2-VL-72B-Instruct dalam beberapa tes benchmark terkait matematika.

Model QVQ telah menunjukkan keunggulan khusus dalam tugas-tugas penalaran visual, terutama di bidang yang memerlukan pemikiran analitis yang kompleks. Meskipun kinerja QVQ-72B-Preview sangat baik, tim juga menunjukkan beberapa keterbatasan model, termasuk masalah pencampuran bahasa dan peralihan kode, kemungkinan jatuh ke dalam pola logika melingkar, pertimbangan keselamatan dan etika, serta keterbatasan kinerja dan tolok ukur. Tim menekankan bahwa meskipun model telah meningkat dalam penalaran visual, model tersebut tidak dapat sepenuhnya menggantikan kemampuan Qwen2-VL-72B. Selama proses penalaran visual multi-langkah, model mungkin secara bertahap kehilangan fokus pada konten gambar, yang menyebabkan halusinasi.

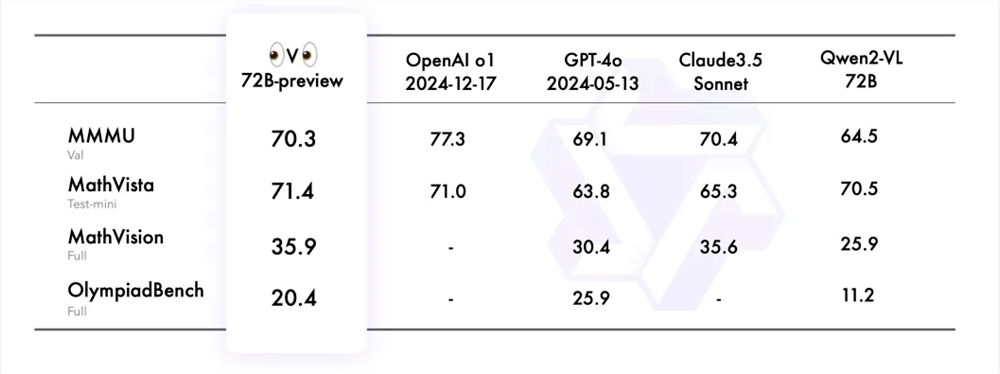

Tim Qwen mengevaluasi Pratinjau QVQ-72B pada empat kumpulan data, termasuk MMMU, MathVista, MathVision, dan OlympiadBench. Kumpulan data ini dirancang untuk menguji pemahaman komprehensif dan kemampuan penalaran model terkait dengan visi. Pratinjau QVQ-72B berkinerja baik dalam tolok ukur ini, secara efektif menutup kesenjangan dengan model terdepan.

Untuk mendemonstrasikan lebih lanjut penerapan model QVQ dalam tugas penalaran visual, tim Qwen memberikan beberapa contoh dan membagikan link ke blog teknis. Selain itu, tim juga memberikan contoh kode untuk inferensi model dan cara menggunakan Magic API-Inference untuk memanggil langsung model QVQ-72B-Preview. Inferensi API dari Platform Ajaib menyediakan dukungan untuk model Pratinjau QVQ-72B, dan pengguna dapat langsung menggunakan model tersebut melalui panggilan API.

Tautan model:

https://modelscope.cn/models/Qwen/QVQ-72B-Pratinjau

Tautan pengalaman:

https://modelscope.cn/studios/Qwen/QVQ-72B-preview

blog Cina:

https://qwenlm.github.io/zh/blog/qvq-72b-preview

Model QVQ yang bersifat open source menyediakan sumber daya berharga untuk penelitian kecerdasan buatan multi-modal, dan juga menandai pengembangan lebih lanjut AI dalam bidang penalaran visual di masa depan. Meskipun ada beberapa keterbatasan, kinerja luar biasa dalam banyak tes benchmark masih mengesankan. Kami menantikan optimalisasi dan peningkatan lebih lanjut model QVQ di masa mendatang.