Magic Square Quantitative baru-baru ini merilis generasi baru model besar DeepSeek-V3. Skala parameter 671 miliar dan arsitektur MoE membuat kinerjanya sebanding dengan model sumber tertutup teratas perhatian di industri. DeepSeek-V3 telah berkinerja baik dalam banyak pengujian, terutama melampaui semua model yang ada dalam tes kemampuan matematika, dan menyediakan layanan API dengan harga yang jauh lebih rendah dibandingkan model seperti GPT-4, sehingga memberikan solusi AI yang hemat biaya kepada pengembang dan perusahaan. Artikel ini akan menganalisis secara rinci kinerja, biaya, dan strategi komersialisasi DeepSeek-V3, serta membahas dampaknya terhadap industri AI.

Magic Square Quantitative merilis generasi baru model besar DeepSeek-V3 pada malam tanggal 26 Desember, menunjukkan terobosan teknologi yang luar biasa. Model yang menggunakan arsitektur MoE (Mixed Experts) ini tidak hanya memiliki kinerja yang sebanding dengan model sumber tertutup teratas, namun fitur-fiturnya yang berbiaya rendah dan berefisiensi tinggi telah menarik perhatian industri.

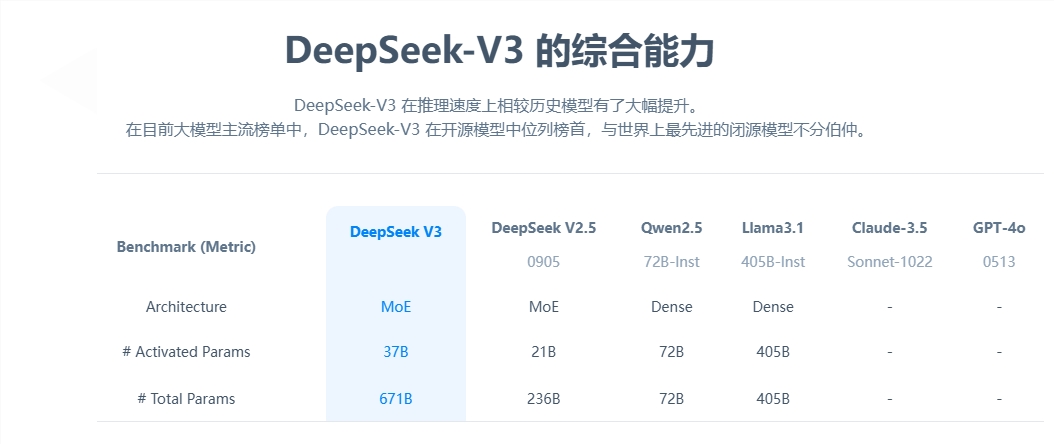

Dari perspektif parameter inti, DeepSeek-V3 memiliki 671 miliar parameter, dimana 37 miliar di antaranya adalah parameter aktivasi, dan telah menyelesaikan pra-pelatihan pada skala data 14,8 triliun token. Dibandingkan dengan produk generasi sebelumnya, kecepatan pembuatan model baru telah meningkat 3 kali lipat, dan dapat memproses 60 token per detik, sehingga secara signifikan meningkatkan efisiensi aplikasi praktis.

Dari segi evaluasi kinerja, DeepSeek-V3 menunjukkan kekuatan yang sangat baik. Ini tidak hanya melampaui model open source terkenal seperti Qwen2.5-72B dan Llama-3.1-405B, tetapi juga setara dengan GPT-4 dan Claude-3.5-Sonnet dalam beberapa pengujian. Khususnya pada tes kemampuan matematika, model tersebut mengungguli semua model open source dan close source yang ada dengan hasil yang sangat baik.

Hal yang paling mencolok adalah keunggulan biaya rendah dari DeepSeek-V3. Menurut makalah sumber terbuka, dihitung sebesar US$2 per jam GPU, total biaya pelatihan model ini hanya US$5,576 juta. Hasil terobosan ini berkat optimalisasi kolaboratif algoritma, kerangka kerja, dan perangkat keras. Salah satu pendiri OpenAI, Karpathy, memuji hal ini, dengan menunjukkan bahwa DeepSeek-V3 mencapai kinerja yang melampaui Llama3 hanya dalam 2,8 juta jam GPU, dan efisiensi komputasi meningkat sekitar 11 kali lipat.

Dalam hal komersialisasi, meskipun harga layanan API DeepSeek-V3 telah ditingkatkan dibandingkan generasi sebelumnya, namun tetap mempertahankan kinerja biaya tinggi. Versi baru ini dihargai 0,5-2 yuan per juta token masukan dan 8 yuan per juta token keluaran, dengan total biaya sekitar 10 yuan. Sebagai perbandingan, harga layanan setara GPT-4 adalah sekitar 140 yuan, dan kesenjangan harga sangat signifikan.

Sebagai model besar sumber terbuka yang komprehensif, peluncuran DeepSeek-V3 tidak hanya menunjukkan kemajuan teknologi AI Tiongkok, tetapi juga memberikan solusi AI berkinerja tinggi dan berbiaya rendah kepada pengembang dan perusahaan.

Kemunculan DeepSeek-V3 menandai terobosan besar dalam teknologi AI Tiongkok di bidang model bahasa berskala besar. Keunggulannya yang berbiaya rendah dan kinerja tinggi menjadikannya sangat kompetitif dalam aplikasi komersial, dan pengembangannya di masa depan patut dinantikan . Model open source ini juga menyumbangkan sumber daya berharga bagi komunitas AI global dan mendorong pembagian dan pengembangan teknologi AI.