Kecepatan decoding model Transformer selalu menjadi hambatan utama yang membatasi penerapannya. Baru-baru ini, para peneliti dari Institut Sains dan Teknologi Korea, LG, dan DeepMind bersama-sama mengatasi masalah ini. Mereka mengusulkan arsitektur baru yang disebut Block Transformer, yang meningkatkan kecepatan decoding hingga 10 hingga 20 kali lipat! Inti dari pengembangan terobosan ini terletak pada "pengirisan" cerdas mekanisme perhatian Transformer, yang secara efektif memecahkan masalah rendahnya penggunaan GPU pada Transformer tradisional dan secara signifikan mengurangi overhead memori.

Meskipun model Transformer kuat, efisiensinya dalam decoding selalu memusingkan. Namun, peneliti dari Institut Sains dan Teknologi Korea, LG, dan DeepMind kali ini memberi kami kejutan - mereka mengusulkan arsitektur Transformer baru yang disebut Block Transformer, yang secara langsung meningkatkan kecepatan decoding sebanyak 10 hingga 20 kali lipat!

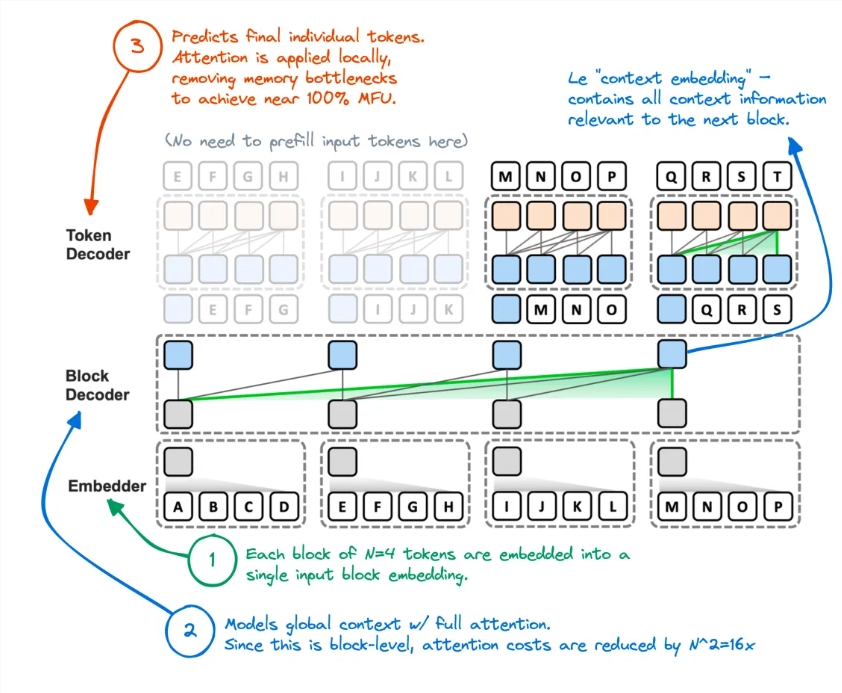

Bagaimana hal ini dilakukan? Ternyata mereka "memotong" mekanisme perhatian Transformer. Dengan cara ini, metode Transformer asli yang tidak efisien dalam mengakses cache KV global setiap kali Token dibuat telah sepenuhnya dibatalkan.

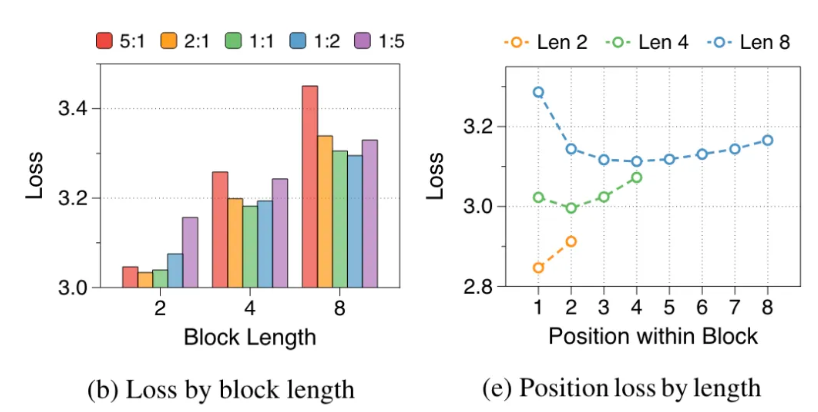

Para peneliti menganalisis kekurangan Transformer asli: pemanfaatan efektif GPU kurang dari 1%, dan 99% sisanya digunakan untuk akses memori. Hal ini jelas tidak masuk akal, jadi mereka mengusulkan Block Transformer. Arsitektur baru ini menggunakan dekomposisi perhatian tingkat blok dan perhatian intra-blok untuk membuat throughput penalaran model langsung meledak.

Secara khusus, alur kerja Block Transformer adalah sebagai berikut: pertama potong urutan menjadi blok, lalu gunakan Embedder untuk mengubah setiap blok menjadi vektor penyematan. Block Decoder bertanggung jawab untuk memproses vektor penyematan blok dan menangkap ketergantungan global antar blok; Token Decoder bertanggung jawab untuk memproses ketergantungan lokal antara Token dan menghasilkan urutan Token.

Metode ini tidak hanya meningkatkan kecepatan inferensi, namun juga sangat mengurangi overhead memori. Beberapa netizen mengatakan bahwa mereka memiliki ide serupa sebelumnya, tetapi kinerja model yang dihasilkan kurang memadai. Sekarang metode ini tampaknya telah secara efektif mengurangi cache KV.

Selain itu, keakuratan Block Transformer pada beberapa tugas zero-shot sebanding atau bahkan sedikit lebih tinggi dibandingkan dengan Transformer asli dengan ukuran yang sama, yang membuktikan bahwa ia meningkatkan efisiensi tanpa mengorbankan kualitas.

Implikasi dari penelitian ini tidak berhenti sampai di situ. Hal ini juga mengurangi biaya pelatihan model, overhead akses memori sekunder yang menjadi perhatian global berkurang 16 kali lipat, dan pemanfaatan GPU juga meningkat dari 1% menjadi 44%.

Alamat makalah: https://arxiv.org/abs/2406.02657

Kemunculan Block Transformer telah memperluas kemungkinan baru penerapan model Transformer, dan juga memberikan arah baru bagi optimalisasi efisiensi model bahasa skala besar di masa depan. Peningkatan signifikan dalam kecepatan dan efisiensi diharapkan dapat mendorong pengembangan lebih lanjut dan penerapan teknologi AI.