Platform terbuka Kimi akan meluncurkan pengujian internal fungsi Caching Konteks yang sangat dinantikan. Teknologi inovatif ini akan secara signifikan meningkatkan pengalaman pengguna model teks panjang berukuran besar. Dengan menyimpan konten Token duplikat dalam cache, Caching Konteks dapat secara signifikan mengurangi biaya pengguna yang meminta konten yang sama dan sangat meningkatkan kecepatan respons antarmuka API. Hal ini sangat penting untuk skenario aplikasi yang memerlukan permintaan yang sering dan referensi berulang ke sejumlah besar konteks awal, seperti skenario cepat berskala besar dan sangat berulang.

Berita dari ChinaZ.com pada 20 Juni: Kimi Open Platform baru-baru ini mengumumkan bahwa fungsi Context Caching yang sangat dinanti akan segera meluncurkan pengujian internal. Fitur inovatif ini akan mendukung model teks panjang berukuran besar dan memberikan pengalaman yang belum pernah terjadi sebelumnya kepada pengguna melalui mekanisme cache konteks yang efisien.

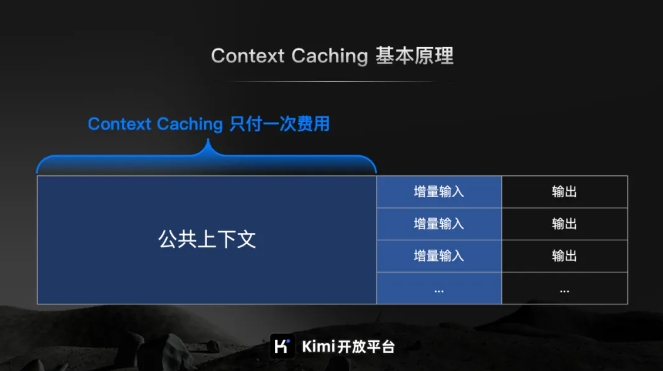

Menurut pengenalan resmi Kimi Open Platform, Context Caching adalah teknologi mutakhir yang dirancang untuk secara signifikan mengurangi biaya pengguna yang meminta konten yang sama dengan menyimpan duplikat konten Token. Prinsip kerjanya adalah dengan cerdas mengidentifikasi dan menyimpan fragmen teks yang diproses ketika pengguna memintanya lagi, sistem dapat dengan cepat mengambilnya dari cache, sehingga sangat meningkatkan kecepatan respons antarmuka API.

Untuk skenario cepat berskala besar dan sangat berulang, keunggulan fungsi Context Caching sangat signifikan. Ini dapat dengan cepat merespons sejumlah besar permintaan yang sering diajukan dan secara signifikan meningkatkan efisiensi pemrosesan sekaligus mengurangi biaya dengan menggunakan kembali konten yang di-cache.

Perlu disebutkan secara khusus bahwa fungsi Caching Konteks sangat cocok untuk skenario aplikasi yang memerlukan permintaan sering dan referensi berulang ke sejumlah besar konteks awal. Melalui fitur ini, pengguna dapat dengan mudah menerapkan cache konteks yang efisien, sehingga meningkatkan efisiensi kerja dan mengurangi biaya pengoperasian.

Pengujian internal fungsi Context Caching akan segera dimulai, yang menandai langkah penting yang diambil oleh platform terbuka Kimi dalam meningkatkan efisiensi model besar dan mengurangi biaya pengguna.