Efek penerapan praktis model bahasa generatif seringkali dibatasi oleh strategi decoding pada tahap inferensi. Metode yang ada seperti RLHF terutama berfokus pada tingkat kemenangan model dan mengabaikan dampak strategi penguraian kode pada kinerja model, sehingga menghasilkan efisiensi yang rendah dan kesulitan dalam memastikan kualitas keluaran. Untuk mengatasi masalah ini, Google DeepMind dan tim peneliti Google mengusulkan kerangka InfAlign, yang bertujuan untuk menggabungkan strategi inferensi dengan proses penyelarasan model untuk meningkatkan kinerja inferensi dan keandalan model.

Model bahasa generatif menghadapi banyak tantangan dalam proses mulai dari pelatihan hingga penerapan praktis. Salah satu permasalahan utamanya adalah bagaimana mencapai performa model yang optimal selama fase inferensi.

Penanggulangan saat ini, seperti pembelajaran penguatan melalui umpan balik manusia (RLHF), terutama berfokus pada peningkatan tingkat kemenangan model, namun sering mengabaikan strategi penguraian kode selama inferensi, seperti pengambilan sampel Best-of-N dan penguraian kode terkontrol. Kesenjangan antara tujuan pelatihan dan penggunaan sebenarnya dapat menyebabkan inefisiensi dan mempengaruhi kualitas dan keandalan keluaran.

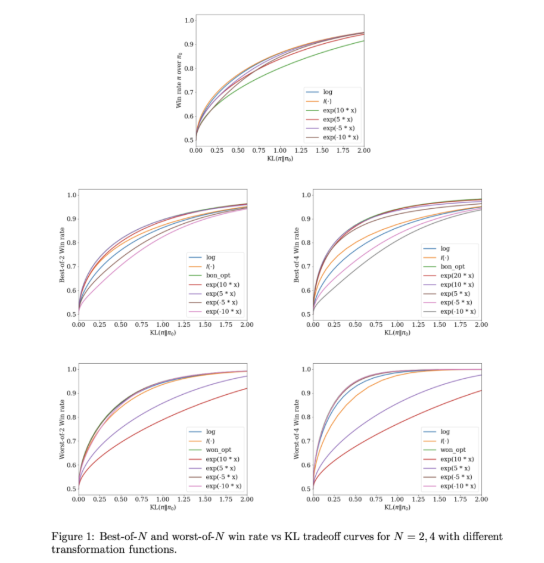

Untuk mengatasi masalah ini, Google DeepMind dan tim Riset Google mengembangkan InfAlign, sebuah kerangka pembelajaran mesin yang dirancang untuk dikombinasikan dengan strategi inferensi. InfAlign menggabungkan metode waktu inferensi ke dalam proses penyelarasan dan berupaya menjembatani kesenjangan antara pelatihan dan penerapan. Ini mengadopsi metode pembelajaran penguatan yang dikalibrasi untuk menyesuaikan fungsi penghargaan berdasarkan strategi inferensi tertentu. InfAlign sangat efektif dengan teknik seperti pengambilan sampel Best-of-N (menghasilkan banyak respons dan memilih yang terbaik) dan Worst-of-N (umumnya digunakan dalam penilaian keselamatan), memastikan bahwa model yang selaras bekerja baik dalam lingkungan terkendali maupun nyata. -skenario dunia bagus.

Inti dari InfAlign adalah algoritma Calibration and Transformation Reinforcement Learning (CTRL), yang mengikuti tiga langkah: mengkalibrasi skor hadiah, mentransformasikan skor ini sesuai dengan strategi inferensi, dan menyelesaikan masalah optimasi teregulasi KL. InfAlign menyelaraskan tujuan pelatihan dengan persyaratan inferensi dengan menyesuaikan transformasi penghargaan dengan skenario tertentu. Metode ini tidak hanya meningkatkan tingkat kemenangan selama inferensi, namun juga menjaga efisiensi komputasi. Selain itu, InfAlign meningkatkan ketahanan model, memungkinkannya mengatasi berbagai strategi decoding secara efektif dan menghasilkan keluaran berkualitas tinggi yang konsisten.

Efektivitas InfAlign diverifikasi dalam eksperimen menggunakan kumpulan data kegunaan dan tidak berbahayanya Anthropic. Dibandingkan dengan metode yang ada, InfAlign meningkatkan tingkat kemenangan inferensi sebesar 8%-12% dalam pengambilan sampel Best-of-N dan 4%-9% dalam evaluasi keamanan Worst-of-N. Peningkatan ini disebabkan oleh transformasi imbalan yang terkalibrasi, yang secara efektif memecahkan masalah kesalahan kalibrasi model imbalan dan memastikan kinerja yang konsisten dalam berbagai skenario inferensi.

InfAlign mewakili kemajuan penting dalam penyelarasan model bahasa generatif. Dengan menggabungkan strategi inferensi-sadar, InfAlign mengatasi perbedaan penting antara pelatihan dan penerapan. Landasan teoritis yang kuat dan hasil empirisnya menyoroti potensinya untuk meningkatkan penyelarasan sistem AI secara komprehensif.

Tautan: https://arxiv.org/abs/2412.19792

Highlight:

InfAlign adalah kerangka kerja baru yang dikembangkan oleh Google DeepMind, yang bertujuan untuk meningkatkan kinerja model bahasa pada tahap inferensi.

Kerangka kerja ini menyesuaikan fungsi penghargaan dari strategi inferensi melalui metode pembelajaran penguatan yang dikalibrasi untuk mencapai keselarasan antara tujuan pelatihan dan persyaratan inferensi.

Hasil eksperimen menunjukkan bahwa InfAlign secara signifikan meningkatkan tingkat kemenangan inferensi model dalam banyak tugas, menunjukkan kemampuan beradaptasi dan keandalan yang baik.

Munculnya kerangka InfAlign memberikan ide-ide baru untuk memecahkan masalah efisiensi dan kualitas model bahasa generatif dalam fase inferensi. Kontribusinya dalam meningkatkan ketahanan dan keandalan model patut mendapat perhatian. Penelitian di masa depan dapat mengeksplorasi lebih jauh penerapan InfAlign pada berbagai model dan tugas untuk mendorong pengembangan berkelanjutan teknologi AI generatif.