Sebuah makalah tentang evaluasi AI medis secara tak terduga mengungkapkan ukuran parameter dari beberapa model bahasa besar, sehingga menyebabkan kekhawatiran luas di industri. Makalah yang dirilis oleh Microsoft ini menggunakan uji benchmark lapangan medis MEDEC sebagai inti dan memperkirakan parameter model OpenAI, Anthropic, dan perusahaan lain, termasuk model seperti seri GPT-4 OpenAI dan Claude 3.5 Sonnet dari Anthropic. Terdapat perbedaan antara skala parameter yang disebutkan dalam makalah dan informasi publik. Misalnya, skala parameter GPT-4 sangat berbeda dengan data yang diumumkan sebelumnya oleh NVIDIA. Hal ini memicu diskusi hangat di industri tentang arsitektur model dan teknis kekuatan, dan sekali lagi memicu kekhawatiran masyarakat tentang pemikiran tentang kerahasiaan parameter.

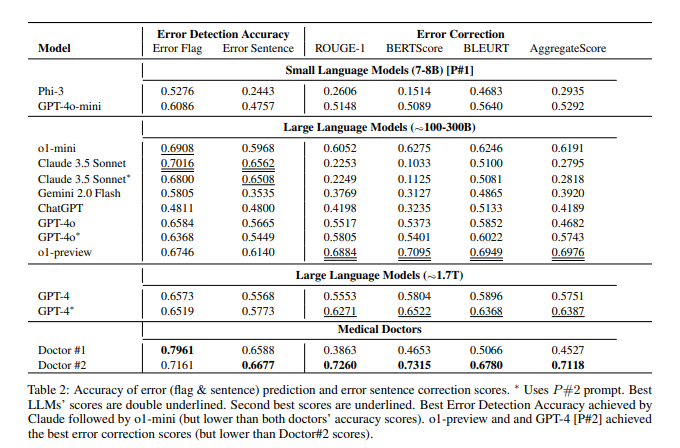

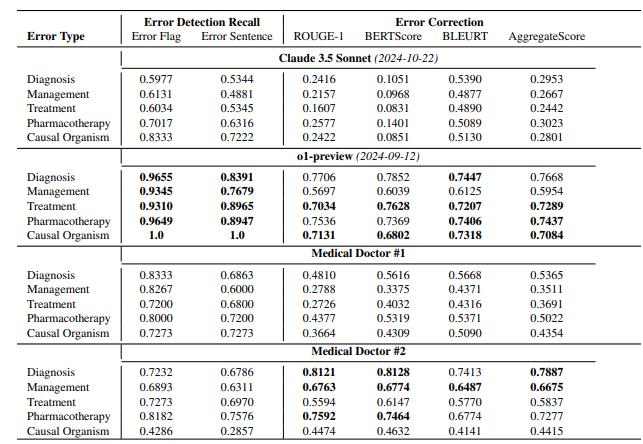

Menurut makalah tersebut, model pratinjau o1 OpenAI memiliki sekitar 300B parameter, GPT-4o memiliki sekitar 200B, dan GPT-4o-mini hanya memiliki 8B; ukuran parameter Claude3.5Sonnet adalah sekitar 175B. Hasil pengujian MEDEC menunjukkan bahwa Claude3.5Sonnet berkinerja baik dalam deteksi kesalahan, dengan skor setinggi 70,16. Parameter Google Gemini tidak disebutkan dalam makalah. Hal ini mungkin karena Gemini menggunakan TPU, bukan GPU NVIDIA, sehingga sulit memperkirakan kecepatan pembuatan token secara akurat. Informasi parameter yang "bocor" dalam makalah ini, serta hasil evaluasi kinerja model, memberikan referensi berharga bagi industri untuk berpikir secara mendalam tentang jalur teknologi model besar, persaingan bisnis, dan arah pengembangan di masa depan.

Ini bukan pertama kalinya Microsoft "membocorkan" informasi parameter model di surat kabar. Pada bulan Oktober tahun lalu, Microsoft mengungkapkan ukuran parameter 20B GPT-3.5-Turbo di sebuah makalah, tetapi kemudian menghapus informasi ini dalam versi yang diperbarui. "Kebocoran" yang berulang kali ini telah menimbulkan spekulasi di kalangan orang dalam industri mengenai apakah perusahaan tersebut memiliki niat tertentu.

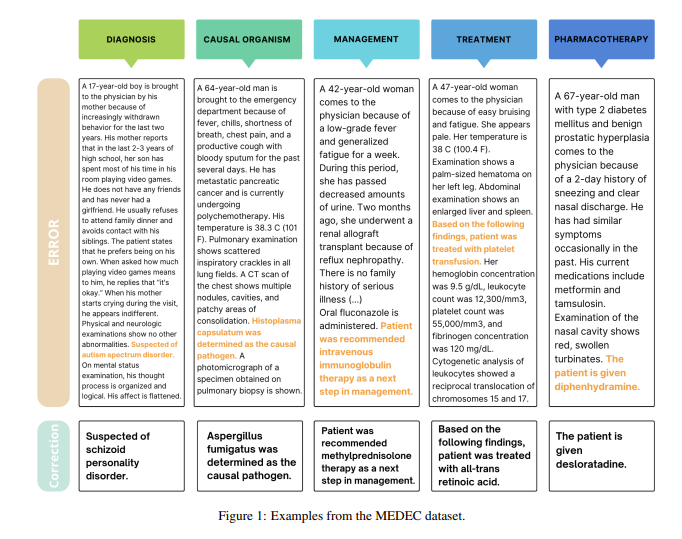

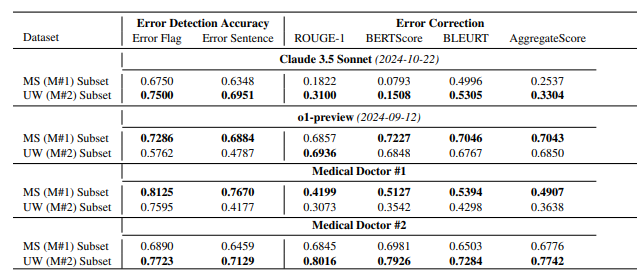

Perlu dicatat bahwa tujuan utama makalah ini adalah untuk memperkenalkan tolok ukur dalam bidang medis yang disebut MEDEC. Tim peneliti menganalisis 488 catatan klinis dari tiga rumah sakit di AS dan mengevaluasi kemampuan model utama untuk mengidentifikasi dan memperbaiki kesalahan dokumentasi medis. Hasil pengujian menunjukkan bahwa Claude3.5Sonnet mengungguli model lain dalam deteksi kesalahan dengan skor 70,16.

Ada diskusi hangat di industri mengenai keaslian data ini. Beberapa orang percaya bahwa jika Claude3.5Sonnet mencapai kinerja luar biasa dengan jumlah parameter yang lebih sedikit, ini akan menonjolkan kekuatan teknis Anthropic. Beberapa analis juga percaya bahwa beberapa estimasi parameter masuk akal melalui inferensi harga model.

Yang perlu diperhatikan adalah makalah ini hanya memperkirakan parameter model mainstream, tetapi tidak menyebutkan parameter spesifik Google Gemini. Beberapa analis percaya bahwa hal ini mungkin terkait dengan penggunaan TPU oleh Gemini, bukan GPU NVIDIA, sehingga sulit memperkirakan kecepatan pembuatan token secara akurat.

Ketika OpenAI secara bertahap melemahkan komitmen open source-nya, informasi inti seperti parameter model dapat terus menjadi fokus perhatian industri. Kebocoran tak terduga ini sekali lagi memicu pemikiran mendalam masyarakat mengenai arsitektur model AI, jalur teknis, dan persaingan bisnis.

Referensi:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probably_around_8b_active/

Secara keseluruhan, meskipun informasi parameter model yang "bocor" dalam makalah ini bukan merupakan konten utama penelitian makalah ini, hal ini telah memicu diskusi mendalam di industri mengenai skala parameter model besar, pemilihan jalur teknis, dan lanskap persaingan komersial, memberikan landasan bagi pengembangan masa depan bidang kecerdasan buatan. Memberikan arah pemikiran baru.