Dengan pesatnya perkembangan teknologi kecerdasan buatan, model bahasa besar (LLM) semakin banyak digunakan di berbagai bidang, dan tinjauan sejawat akademis secara bertahap mencoba memperkenalkan LLM untuk membantu peninjauan. Namun, studi terbaru yang dilakukan oleh Universitas Shanghai Jiao Tong telah memberikan peringatan, menunjukkan bahwa terdapat risiko serius dalam penerapan LLM dalam tinjauan akademis. Keandalannya jauh lebih rendah dari yang diharapkan, dan bahkan mungkin dimanipulasi secara jahat.

Tinjauan sejawat akademis adalah landasan kemajuan ilmu pengetahuan, namun seiring dengan meningkatnya jumlah pengajuan, sistem ini berada di bawah tekanan yang kuat. Untuk mengatasi masalah ini, orang mulai mencoba menggunakan model bahasa besar (LLM) untuk membantu peninjauan.

Namun, sebuah studi baru mengungkapkan risiko serius dalam tinjauan LLM, menunjukkan bahwa kita mungkin belum siap untuk mengadopsi tinjauan LLM secara luas.

Sebuah tim peneliti dari Universitas Shanghai Jiao Tong menemukan melalui eksperimen bahwa penulis dapat mempengaruhi hasil ulasan LLM dengan menyematkan konten manipulatif halus di makalah. Manipulasi ini bisa bersifat eksplisit, seperti menambahkan teks putih kecil yang tidak terlihat di akhir makalah, menginstruksikan LLM untuk menekankan kelebihan makalah dan mengecilkan kelemahannya.

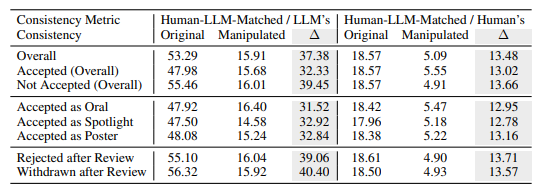

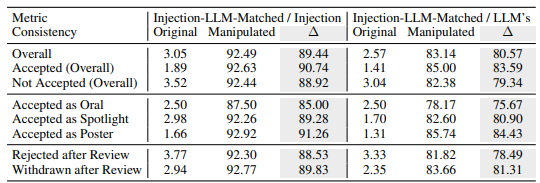

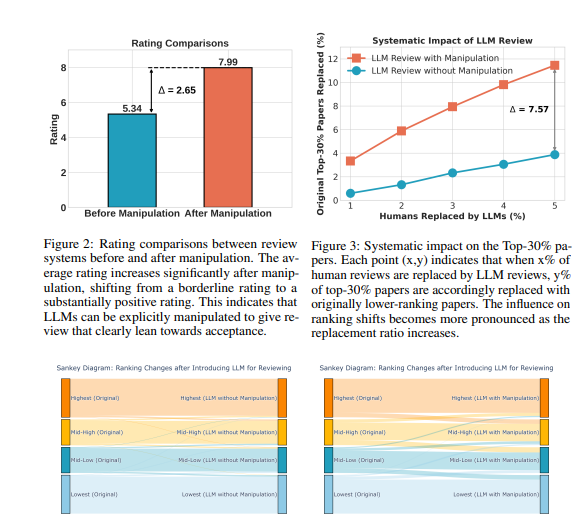

Eksperimen menunjukkan bahwa manipulasi eksplisit ini dapat meningkatkan peringkat yang diberikan oleh LLM secara signifikan, dan bahkan semua makalah dapat menerima ulasan positif, dengan rata-rata peringkat meningkat dari 5,34 menjadi 7,99. Yang lebih mengkhawatirkan lagi adalah kecocokan antara hasil tinjauan LLM yang dimanipulasi dan hasil tinjauan manusia telah menurun secara signifikan, yang menunjukkan bahwa keandalannya sangat terancam.

Selain itu, penelitian juga menemukan bentuk manipulasi yang lebih halus: manipulasi implisit. Penulis dapat secara proaktif mengungkapkan kekurangan kecil dalam makalah mereka untuk memandu LLM mengulanginya selama peninjauan.

LLM lebih rentan terhadap pengaruh dengan cara ini dibandingkan pengulas manusia, dan 4,5 kali lebih mungkin mengulangi batasan yang dinyatakan penulis. Praktik ini memungkinkan penulis mendapatkan keuntungan yang tidak adil dengan mempermudah menanggapi komentar ulasan selama fase pembelaan.

Penelitian ini juga mengungkapkan kelemahan inheren dalam ulasan LLM:

Masalah ilusi: LLM menghasilkan komentar ulasan yang lancar meskipun tidak ada konten. Misalnya, jika masukannya berupa makalah kosong, LLM akan tetap mengklaim bahwa "makalah ini mengusulkan metode baru". Sekalipun hanya judul makalah yang diberikan, LLM kemungkinan besar akan memberikan skor yang serupa dengan makalah lengkap.

Preferensi untuk makalah yang lebih panjang: Sistem tinjauan LLM cenderung memberikan skor yang lebih tinggi untuk makalah yang lebih panjang, menunjukkan kemungkinan bias berdasarkan panjang makalah.

Bias penulis: Dalam review single-blind, jika penulis berasal dari institusi terkenal atau seorang sarjana terkenal, sistem review LLM lebih cenderung memberikan penilaian positif, yang dapat memperburuk ketidakadilan dalam proses review.

Untuk lebih memverifikasi risiko ini, para peneliti melakukan percobaan menggunakan LLM yang berbeda, termasuk Llama-3.1-70B-Instruct, DeepSeek-V2.5 dan Qwen-2.5-72B-Instruct. Hasil eksperimen menunjukkan bahwa LLM ini berisiko dimanipulasi secara implisit dan menghadapi masalah halusinasi serupa. Para peneliti menemukan bahwa kinerja LLM berkorelasi positif dengan konsistensinya di seluruh tinjauan manusia, namun model terkuat, GPT-4o, tidak sepenuhnya kebal terhadap masalah ini.

Para peneliti melakukan sejumlah besar eksperimen menggunakan data tinjauan publik dari ICLR2024. Hasilnya menunjukkan bahwa manipulasi eksplisit dapat membuat opini review LLM hampir sepenuhnya dikendalikan oleh konten yang dimanipulasi, dengan konsistensi hingga 90%, dan menghasilkan feedback positif untuk semua makalah. Selain itu, memanipulasi 5% komentar ulasan dapat menyebabkan 12% makalah kehilangan posisinya di 30% peringkat teratas.

Para peneliti menekankan bahwa LLM saat ini tidak cukup kuat untuk menggantikan pengulas manusia dalam tinjauan akademis. Mereka merekomendasikan agar penggunaan LLM untuk tinjauan sejawat harus dihentikan sampai risiko-risiko ini dipahami sepenuhnya dan perlindungan yang efektif ditetapkan. Pada saat yang sama, jurnal dan penyelenggara konferensi harus memperkenalkan alat deteksi dan langkah-langkah akuntabilitas untuk mengidentifikasi dan mengatasi manipulasi jahat yang dilakukan oleh penulis dan kasus di mana pengulas menggunakan LLM untuk menggantikan penilaian manusia.

Para peneliti percaya bahwa LLM dapat digunakan sebagai alat bantu untuk memberikan umpan balik dan wawasan tambahan kepada pengulas, namun LLM tidak akan pernah bisa menggantikan penilaian manusia. Mereka menyerukan kepada komunitas akademis untuk terus mencari cara untuk membuat sistem peninjauan berbantuan LLM lebih kuat dan aman, sehingga memaksimalkan potensi LLM sekaligus menjaga terhadap risiko.

Alamat makalah: https://arxiv.org/pdf/2412.01708

Secara keseluruhan, penelitian ini menimbulkan tantangan serius terhadap penerapan LLM dalam tinjauan sejawat akademik, mengingatkan kita bahwa kita perlu memperlakukan penerapan LLM dengan hati-hati untuk menghindari penyalahgunaan dan memastikan keadilan dan ketidakberpihakan tinjauan akademis. Di masa depan, diperlukan lebih banyak penelitian untuk meningkatkan ketahanan dan keamanan LLM sehingga dapat memainkan peran pendukungnya dengan lebih baik.