Tim peneliti seperti Peking University baru-baru ini merilis model open source multi-mode LLAVA-O1. penalaran sistematis. LLAVA-O1 mengadopsi mekanisme penalaran "berpikir lambat" untuk menguraikan proses penalaran menjadi empat tahap: ringkasan, interpretasi visual, penalaran logis dan generasi kesimpulan, yang secara efektif menghindari kesalahan yang disebabkan oleh menyederhanakan proses penalaran model tradisional. Model ini berkinerja baik dalam enam tes benchmark yang menantang, melampaui banyak pesaing, dan berkinerja baik dalam perbandingan sumber yang lebih besar atau tertutup.

Baru-baru ini, tim peneliti ilmiah seperti Peking University mengumumkan rilis model open source multi-mode yang disebut LLAVA-O1. O1.

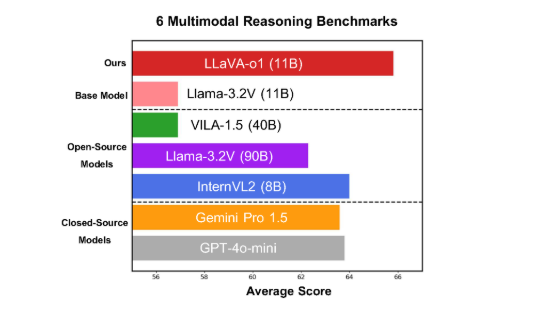

Model ini berkinerja baik dalam enam tes benchmark multi-mode yang menantang.

LLAVA-O1 didasarkan pada model Llama-3.2-Vision.

Dalam uji benchmark penalaran multi-mode, kinerja LLAVA-O1 melebihi model dasarnya sebesar 8,9%. Keunikan model ini adalah bahwa proses penalarannya dibagi menjadi empat tahap: ringkasan, interpretasi visual, penalaran logis dan generasi kesimpulan. Dalam model tradisional, proses penalaran seringkali relatif sederhana, dan mudah untuk menyebabkan kesalahan.

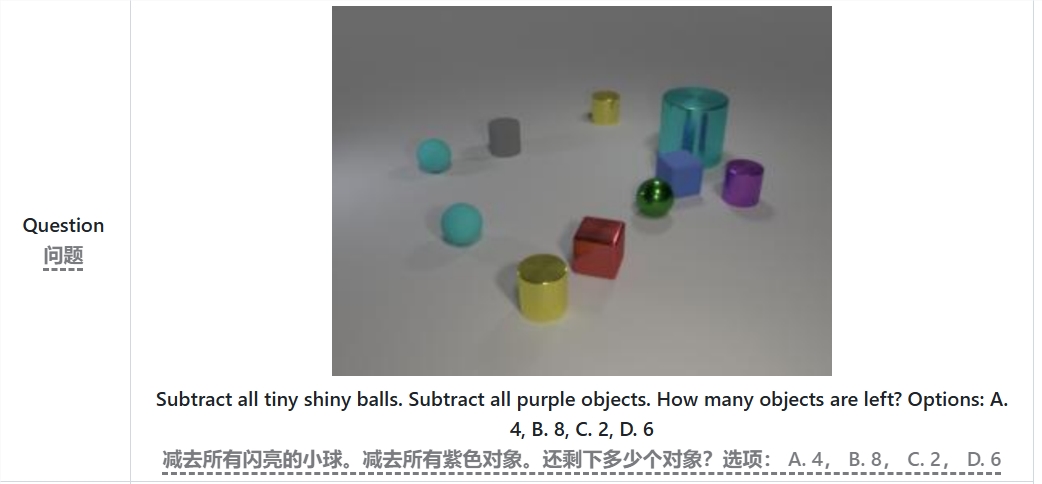

Misalnya, saat memecahkan masalah "dikurangi semua bola terang kecil dan benda ungu, berapa banyak objek yang tersisa", Llava-O1 pertama-tama akan meringkas masalahnya, kemudian mengekstrak informasi dari gambar, kemudian secara bertahap, dan akhirnya memberikannya untuk memberikannya. Metode dalam -fase ini meningkatkan kemampuan penalaran sistem model dan membuatnya lebih efisien saat menangani masalah yang kompleks.

Perlu disebutkan bahwa LLAVA-O1 memperkenalkan metode pencarian balok tingkat panggung selama proses penalaran. Metode ini memungkinkan model untuk menghasilkan banyak jawaban kandidat di setiap tahap penalaran, dan memilih jawaban terbaik untuk melanjutkan tahap penalaran berikutnya, yang secara signifikan meningkatkan kualitas penalaran keseluruhan. Dengan mengawasi data pelatihan yang menyempurnakan dan masuk akal, LLAVA-O1 berkinerja baik dibandingkan dengan sumber yang lebih besar atau tertutup.

Hasil penelitian tim Universitas Peking tidak hanya mempromosikan pengembangan AI multimodal, tetapi juga menyediakan ide dan metode baru untuk model pemahaman bahasa visual di masa depan. Tim mengatakan bahwa kode LLAVA-O1, bobot pelatihan pra-pelatihan dan set data akan sepenuhnya open source, dan diharapkan lebih banyak peneliti dan pengembang akan mengeksplorasi dan menerapkan model inovatif ini bersama-sama.

Tesis: https://arxiv.org/abs/2411.10440

Github: https: //github.com/pku- yuanroup/llava-o1

Poin:

Llava-O1 adalah model penalaran multi-modal baru yang dirilis oleh tim seperti Peking University, yang memiliki kemampuan untuk "berpikir perlahan-lahan".

Kinerja melebihi 8,9%dari model dasar dalam uji benchmark penalaran multi -mode.

LLAVA-O1 melalui penalaran multi-langkah terstruktur untuk memastikan keakuratan dan akan menjadi open source dalam waktu dekat.

Sumber terbuka LLAVA-O1 akan mempromosikan penelitian dan pengembangan bidang AI multi-modal, dan memberikan dasar yang kuat untuk pembangunan model bahasa visual yang lebih cerdas dan lebih kuat. Berharap untuk menunjukkan lebih banyak potensi dalam aplikasi mendatang. Makalah dan tautan GitHub nyaman bagi para peneliti untuk memahami dan menggunakan model secara mendalam.