Mengurangi biaya pelatihan model besar adalah topik penelitian terkini di bidang kecerdasan buatan. Penelitian terbaru yang dirilis oleh tim Tencent Hunyuan membahas secara mendalam tentang aturan skala pelatihan kuantisasi floating point bit rendah, memberikan ide-ide baru untuk pelatihan model besar yang efisien. Melalui sejumlah besar eksperimen, penelitian ini menganalisis dampak faktor-faktor seperti ukuran model, volume data pelatihan, dan akurasi kuantifikasi terhadap efek pelatihan, dan akhirnya menghasilkan aturan tentang cara mengalokasikan sumber daya pelatihan secara efektif pada akurasi yang berbeda untuk mendapatkan hasil terbaik. Penelitian ini tidak hanya memiliki signifikansi teoretis yang penting, namun juga memberikan panduan berharga untuk penerapan praktis model besar.

Saat ini, dengan pesatnya perkembangan Model Bahasa Besar (LLM), biaya pelatihan model dan inferensi semakin menjadi fokus penelitian dan penerapan. Baru-baru ini, tim Tencent Hunyuan merilis sebuah studi penting, yang mengeksplorasi secara mendalam "Hukum Penskalaan" dari pelatihan kuantisasi floating point bit rendah, yaitu hukum penskalaan dari pelatihan kuantifikasi floating point. Inti dari penelitian ini adalah untuk mengeksplorasi cara mengurangi biaya komputasi dan penyimpanan secara signifikan tanpa kehilangan performa dengan mengurangi keakuratan model.

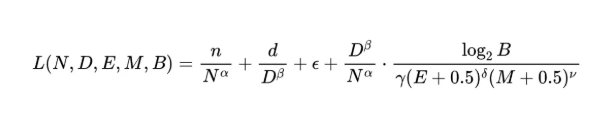

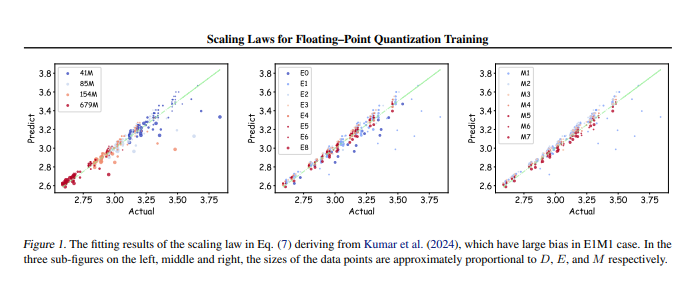

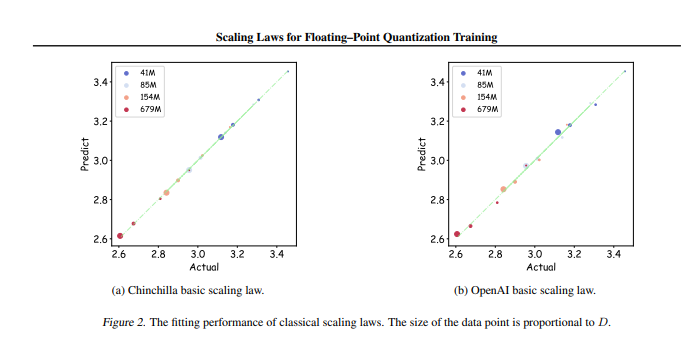

Tim peneliti melakukan hingga 366 set pelatihan kuantifikasi floating-point dengan ukuran dan presisi parameter yang berbeda, dan secara sistematis menganalisis berbagai faktor yang mempengaruhi efek pelatihan, termasuk ukuran model (N), jumlah data pelatihan (D), bit eksponensial ( E), bit Mantissa (M) dan granularitas kuantisasi (B). Melalui eksperimen ini, para peneliti memperoleh seperangkat Hukum Penskalaan terpadu, yang mengungkapkan cara mengonfigurasi data pelatihan dan parameter model secara efektif dengan akurasi berbeda untuk mendapatkan efek pelatihan terbaik.

Hal yang paling penting adalah penelitian menunjukkan bahwa dalam pelatihan kuantifikasi floating-point presisi rendah yang sewenang-wenang, terdapat "efek batas", yaitu, pada jumlah data tertentu, performa model akan mencapai optimal, dan melebihi jumlah data ini dapat menyebabkan efek penurunan. Selain itu, penelitian ini juga menemukan bahwa akurasi pelatihan kuantifikasi floating point hemat biaya terbaik secara teoritis harus antara 4 dan 8 bit, yang memiliki signifikansi panduan penting untuk pengembangan LLM yang efisien.

Penelitian ini tidak hanya mengisi kesenjangan di bidang pelatihan kuantifikasi floating-point, namun juga memberikan referensi bagi produsen perangkat keras masa depan untuk membantu mereka mengoptimalkan kemampuan komputasi floating-point pada presisi yang berbeda. Pada akhirnya, penelitian ini memberikan arah yang jelas untuk praktik pelatihan model besar, memastikan bahwa efek pelatihan yang efisien tetap dapat dicapai bahkan dengan sumber daya yang terbatas.

Alamat makalah: https://arxiv.org/pdf/2501.02423

Singkatnya, penelitian yang dilakukan oleh tim Tencent Hunyuan ini memberikan solusi efektif untuk mengurangi biaya pelatihan model besar. Aturan skala dan rentang akurasi optimal yang ditemukan akan berdampak besar pada pengembangan dan penerapan model besar di masa depan. Karya ini menunjukkan arah pelatihan model besar berkinerja tinggi dan berbiaya rendah, yang memerlukan perhatian dan penelitian mendalam.