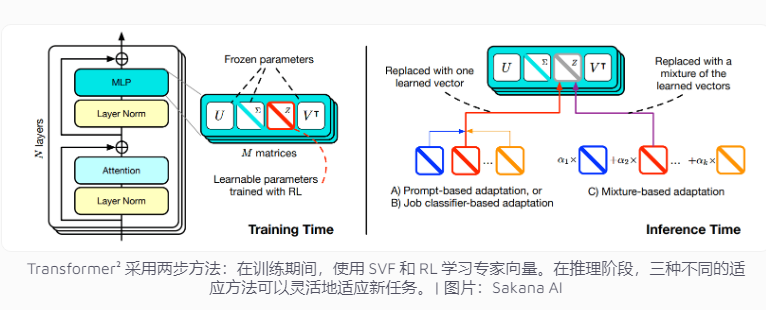

Perusahaan Jepang Sakana AI baru-baru ini merilis Transformer², sebuah teknologi inovatif yang dirancang untuk meningkatkan kemampuan adaptasi tugas model bahasa. Tidak seperti sistem AI tradisional yang perlu memproses banyak tugas sekaligus, Transformer² menggunakan pembelajaran dua tahap, menggunakan vektor ahli dan teknologi penyempurnaan nilai tunggal (SVF), yang memungkinkannya beradaptasi secara efisien terhadap tugas-tugas baru tanpa melatih ulang seluruh jaringan, sehingga meningkatkan secara signifikan kinerja. Hal ini secara signifikan mengurangi konsumsi sumber daya dan meningkatkan fleksibilitas dan akurasi model. Teknologi ini berfokus pada tugas-tugas spesifik seperti operasi matematika, pemrograman, dan penalaran logis dengan mempelajari vektor ahli yang mengontrol pentingnya koneksi jaringan, dan menggabungkan pembelajaran penguatan untuk lebih mengoptimalkan performa model.

Sistem kecerdasan buatan saat ini biasanya perlu menangani banyak tugas dalam satu pelatihan. Namun, sistem tersebut cenderung menghadapi tantangan yang tidak terduga saat menghadapi tugas baru, yang mengakibatkan terbatasnya kemampuan adaptasi model. Konsep desain Transformer² ditujukan untuk mengatasi masalah ini, menggunakan teknologi expert vector dan singular value fine-tuning (SVF), sehingga model dapat secara fleksibel mengatasi tugas-tugas baru tanpa melatih ulang seluruh jaringan.

Metode pelatihan tradisional memerlukan penyesuaian bobot seluruh jaringan saraf, yang tidak hanya memakan biaya tetapi juga dapat menyebabkan model "melupakan" pengetahuan yang telah dipelajari sebelumnya. Sebaliknya, teknik SVF menghindari masalah ini dengan mempelajari vektor ahli yang mengontrol pentingnya setiap koneksi jaringan. Vektor ahli membantu model fokus pada tugas tertentu, seperti operasi matematika, pemrograman, dan penalaran logis, dengan menyesuaikan matriks bobot koneksi jaringan.

Pendekatan ini secara signifikan mengurangi jumlah parameter yang diperlukan untuk menyesuaikan model dengan tugas-tugas baru. Misalnya metode LoRA membutuhkan 6,82 juta parameter, sedangkan SVF hanya membutuhkan 160.000 parameter. Hal ini tidak hanya mengurangi konsumsi memori dan daya pemrosesan, tetapi juga mencegah model melupakan pengetahuan lain saat berfokus pada tugas tertentu. Yang terpenting, vektor ahli ini dapat bekerja sama secara efektif untuk meningkatkan kemampuan adaptasi model terhadap beragam tugas.

Untuk lebih meningkatkan kemampuan beradaptasi, Transformer² memperkenalkan pembelajaran penguatan. Selama proses pelatihan, model terus mengoptimalkan vektor pakar dengan mengusulkan solusi tugas dan memperoleh umpan balik, sehingga meningkatkan kinerja pada tugas baru. Tim mengembangkan tiga strategi untuk memanfaatkan pengetahuan ahli ini: isyarat adaptif, pengklasifikasi tugas, dan adaptasi beberapa langkah. Secara khusus, strategi adaptif beberapa langkah semakin meningkatkan fleksibilitas dan akurasi model dengan menganalisis contoh tugas baru dan menyesuaikan vektor ahli.

Transformer² mengungguli metode tradisional LoRA pada berbagai tolok ukur. Pada tugas matematika, kinerjanya meningkat sebesar 16%, dan parameter yang diperlukan berkurang secara signifikan. Saat dihadapkan pada tugas baru, akurasi Transformer² 4% lebih tinggi dibandingkan model aslinya, sementara LoRA gagal mencapai hasil yang diharapkan.

Transformer² tidak hanya memecahkan masalah matematika yang kompleks, tetapi juga menggabungkan kemampuan pemrograman dan penalaran logis untuk mencapai berbagi pengetahuan lintas domain. Misalnya, tim menemukan bahwa model yang lebih kecil juga dapat meningkatkan kinerja dengan memanfaatkan pengetahuan model yang lebih besar dengan mentransfer vektor ahli, yang memberikan kemungkinan baru untuk berbagi pengetahuan antar model.

Meskipun Transformer² telah mengalami kemajuan signifikan dalam kemampuan beradaptasi tugas, ia masih menghadapi beberapa keterbatasan. Saat ini, vektor ahli yang dilatih menggunakan SVF hanya dapat mengandalkan kemampuan yang ada dalam model yang telah dilatih sebelumnya dan tidak dapat menambahkan keterampilan yang benar-benar baru. Pembelajaran berkelanjutan yang sebenarnya berarti model dapat mempelajari keterampilan baru secara mandiri. Bagaimana menskalakan teknik ini pada model besar dengan lebih dari 70 miliar parameter masih menjadi pertanyaan terbuka.

Secara keseluruhan, Transformer² menunjukkan potensi besar dalam bidang pembelajaran berkelanjutan, dan pemanfaatan sumber daya yang efisien serta peningkatan kinerja yang signifikan memberikan arah baru untuk pengembangan model bahasa masa depan. Namun demikian, teknologi tersebut masih perlu terus ditingkatkan untuk mengatasi keterbatasan yang ada dan mencapai tujuan pembelajaran berkelanjutan yang sesungguhnya.