Codestral 25.01, model pengkodean open source terbaru yang dirilis oleh Mistral, telah mencapai peningkatan kinerja yang signifikan dan dua kali lebih cepat dari generasi sebelumnya. Sebagai versi Codestral yang ditingkatkan, Codestral 25.01 mewarisi karakteristik operasi latensi rendah dan frekuensi tinggi, dan dioptimalkan untuk aplikasi tingkat perusahaan, mendukung tugas-tugas seperti koreksi kode, pembuatan pengujian, dan pengisian perantara. Performanya yang luar biasa dalam pengujian pengkodean Python, terutama skor tinggi sebesar 86,6% dalam pengujian HumanEval, menjadikannya pemimpin di antara model pengkodean kelas berat saat ini, melampaui banyak produk serupa.

Mirip dengan Codestral asli, Codestral 25.01 masih berfokus pada operasi latensi rendah dan frekuensi tinggi, mendukung koreksi kode, pembuatan pengujian, dan tugas pengisian menengah. Mistral mengatakan versi ini sangat cocok untuk perusahaan yang membutuhkan lebih banyak data dan residensi model. Tes benchmark menunjukkan bahwa Codestral25.01 berkinerja melebihi ekspektasi dalam tes coding Python, dengan skor tes HumanEval sebesar 86,6%, jauh melebihi versi sebelumnya, Codellama70B Instruct dan DeepSeek Coder33B Instruct.

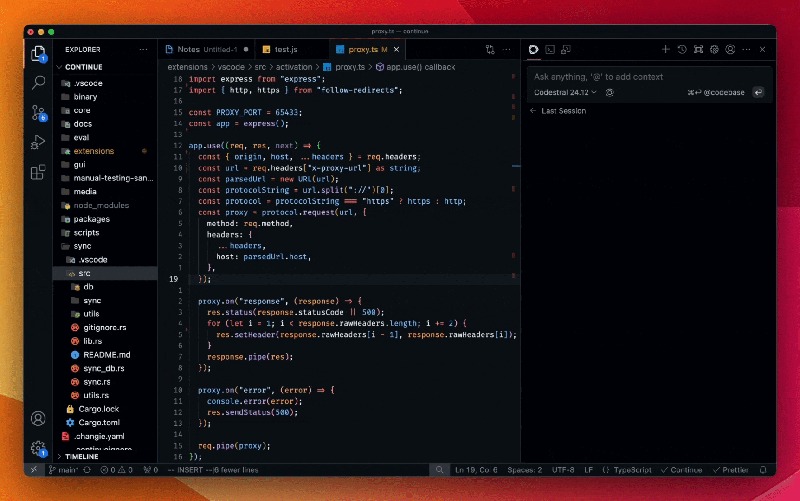

Pengembang dapat mengakses model melalui plug-in Mistral IDE serta alat penerapan lokal Lanjutkan. Selain itu, Mistral juga menyediakan akses ke API melalui Google Vertex AI dan Mistral la Plateforme. Model ini saat ini tersedia dalam pratinjau di Azure AI Foundry dan akan segera tersedia di platform Amazon Bedrock.

Sejak dirilis tahun lalu, Codestral by Mistral telah menjadi pemimpin dalam model sumber terbuka yang berfokus pada kode. Codestral versi pertamanya adalah model parameter 22B yang mendukung hingga 80 bahasa dan memiliki kinerja pengkodean yang lebih baik daripada banyak produk serupa. Segera setelah itu, Mistral meluncurkan Codestral-Mamba, model pembuatan kode berdasarkan arsitektur Mamba yang dapat menangani string kode yang lebih panjang dan memenuhi lebih banyak kebutuhan input.

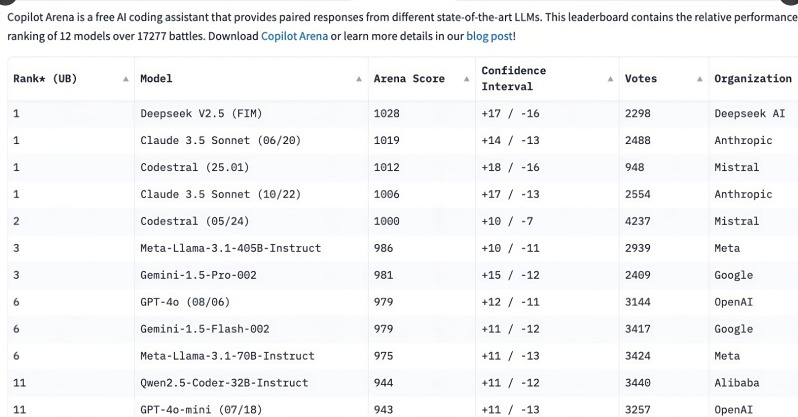

Peluncuran Codestral 25.01 menarik perhatian luas dari para pengembang, menduduki peringkat teratas C o pilot Arena hanya dalam beberapa jam setelah rilis. Tren ini menunjukkan bahwa model pengkodean khusus dengan cepat menjadi pilihan pertama bagi pengembang, terutama di bidang tugas pengkodean. Dibandingkan dengan model umum multi-fungsi, kebutuhan akan model pengkodean terfokus semakin jelas.

Meskipun model tujuan umum seperti o3 OpenAI dan Claude Anthropic juga dapat melakukan pengkodean, model pengkodean yang dioptimalkan secara khusus cenderung memiliki kinerja yang lebih baik. Pada tahun lalu, beberapa perusahaan telah merilis model khusus untuk pengkodean, seperti Qwen2.5-Coder dari Alibaba dan DeepSeek Coder dari Tiongkok, yang terakhir menjadi model pertama yang melampaui GPT-4Turbo. Selain itu, Microsoft juga telah meluncurkan GRIN-MoE berdasarkan model campuran ahli (MOE), yang tidak hanya dapat mengkode tetapi juga memecahkan masalah matematika.

Meskipun pengembang masih memperdebatkan apakah akan memilih model tujuan umum atau model khusus, pesatnya perkembangan model pengkodean telah mengungkapkan kebutuhan besar akan alat pengkodean yang efisien dan akurat. Dengan keuntungan dilatih secara khusus untuk tugas-tugas pengkodean, Codestral25.01 tidak diragukan lagi menempati tempat di masa depan pengkodean.

Peluncuran Codestral25.01 menandai langkah maju dalam bidang model pengkodean profesional. Kinerjanya yang unggul dan akses yang mudah akan memberikan pengalaman pengkodean yang lebih efisien kepada pengembang dan mendorong pengembangan lebih lanjut kecerdasan buatan di bidang pengembangan perangkat lunak. Di masa depan, kami berharap dapat melihat lebih banyak model profesional serupa muncul untuk memberikan lebih banyak pilihan kepada pengembang.