Sakana AI meluncurkan Model Bahasa Adaptif Inovatif Transformer², yang menggunakan mekanisme penyesuaian berat dinamis dua langkah yang unik yang secara dinamis belajar dan beradaptasi dengan tugas-tugas baru selama proses inferensi tanpa penyempurnaan yang mahal. Ini menandai terobosan besar dalam teknologi model bahasa besar (LLM) dan diharapkan untuk mengubah cara LLM diterapkan untuk membuatnya lebih efisien, dipersonalisasi, dan praktis. Dibandingkan dengan metode fine-tuning tradisional, Transformer² secara selektif menyesuaikan komponen kunci bobot model melalui teknik Dekomposisi Singular (SVD) dan Singular Value Fine-Tuning (SVF) untuk mengoptimalkan kinerja secara real time, menghindari pelatihan ulang yang memakan waktu. Hasil tes menunjukkan bahwa Transformer² lebih unggul daripada model LORA dalam beberapa tugas, dengan parameter yang lebih sedikit, dan juga menunjukkan kemampuan transfer pengetahuan yang kuat.

Inovasi inti Transformer² terletak pada mekanisme penyesuaian berat dua langkah dinamis yang unik. Pertama, ia menganalisis permintaan pengguna yang masuk dan memahami persyaratan tugas; Dengan menyesuaikan secara selektif komponen kunci bobot model, Transformer² memungkinkan optimalisasi kinerja waktu nyata tanpa pelatihan ulang yang memakan waktu. Ini sangat kontras dengan metode fine-tuning tradisional, yang membutuhkan parameter statis setelah pelatihan, atau menggunakan metode seperti adaptasi peringkat rendah (LORA) untuk memodifikasi hanya sejumlah kecil parameter.

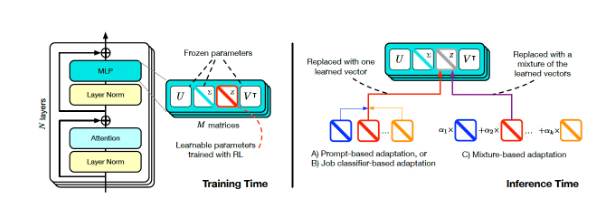

Transformer Square Training and Inference (Sumber: ARXIV)

Untuk mencapai penyesuaian dinamis, para peneliti mengadopsi metode fine tuning value singular (SVF). Selama pelatihan, SVF mempelajari serangkaian representasi keterampilan yang disebut z-vektor dari komponen SVD model. Saat beralasan, Transformer² menentukan keterampilan yang diperlukan dengan menganalisis petunjuk dan kemudian mengkonfigurasi vektor-Z yang sesuai untuk mencapai respons yang disesuaikan untuk setiap prompt.

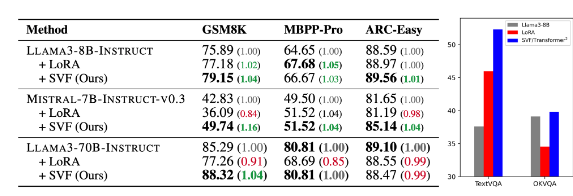

Hasil tes menunjukkan bahwa Transformer² lebih unggul daripada model LORA dalam berbagai tugas seperti matematika, pengkodean, penalaran, dan pertanyaan dan jawaban visual, dan memiliki lebih sedikit parameter. Yang lebih luar biasa adalah bahwa model ini juga memiliki kemampuan transfer pengetahuan, yaitu, vektor-z yang dipelajari dari satu model dapat diterapkan pada yang lain, sehingga menunjukkan potensi aplikasi yang meluas.

Perbandingan transformator-squared (SVF dalam tabel) dengan model yang mendasarinya dan LORA (Sumber: Arxiv)

Sakana AI merilis kode pelatihan untuk komponen Transformer² di halaman GitHub -nya, membuka pintu bagi peneliti dan pengembang lainnya.

Ketika perusahaan terus mengeksplorasi penerapan LLM, teknologi kustomisasi inferensi secara bertahap menjadi tren utama. Transformer², bersama dengan teknologi lain seperti Google Titans, mengubah cara LLM digunakan, memungkinkan pengguna untuk secara dinamis menyesuaikan model dengan kebutuhan spesifik mereka tanpa melatih kembali. Kemajuan teknologi ini akan membuat LLM lebih berguna dan praktis di berbagai bidang.

Para peneliti di Sakana Ai mengatakan Transformer² mewakili jembatan antara kecerdasan buatan statis dan kecerdasan kehidupan, meletakkan dasar untuk alat AI yang efisien, dipersonalisasi, dan terintegrasi sepenuhnya.

Rilis open source Transformer² akan sangat mempromosikan pengembangan dan penerapan teknologi LLM dan memberikan arah baru untuk membangun sistem kecerdasan buatan yang lebih efisien dan dipersonalisasi. Kemampuannya untuk belajar secara dinamis dan beradaptasi dengan tugas -tugas baru membuatnya memiliki potensi aplikasi yang sangat besar di berbagai bidang dan layak dinantikan untuk pengembangan di masa depan.