Allen Institute of Artificial Intelligence (AI2) baru-baru ini merilis model bahasa skala besar baru Olmoe, model ahli hibrida hibrida yang jarang (MOE) dengan 7 miliar parameter, tetapi setiap tanda input hanya menggunakan 1 miliar parameter, yang secara signifikan mengurangi jumlah inferensi biaya dan persyaratan memori. Olmoe memiliki dua versi: Versi Universal Olmoe-1B-7B dan Versi Fine-Tuning Instruksi OLMOE-1B-7B-instruct, yang melakukan tidak kurang dari model besar lainnya dalam tolok ukur, dan bahkan melampaui beberapa model yang lebih besar. AI2 menekankan sumber terbuka lengkap Olmoe, yang sangat berharga di bidang model MOE dan menyediakan sumber daya yang berharga untuk penelitian akademik.

Olmoe mengadopsi arsitektur ahli hibrida yang jarang (MOE) dengan 7 miliar parameter, tetapi hanya 1 miliar parameter yang digunakan per tag input. Muncul dalam dua versi, olmoe-1b-7b yang lebih umum dan olmoe-1b-7b-instruksi yang disesuaikan dengan instruksi.

Tidak seperti kebanyakan model ahli hibrida lainnya yang merupakan sumber tertutup, AI2 menekankan bahwa Olmoe benar -benar open source. Mereka menyebutkan dalam makalah bahwa "sebagian besar model MOE adalah sumber tertutup: meskipun beberapa bobot model yang mengungkapkan, ada informasi yang sangat terbatas tentang data pelatihan, kode, atau resep mereka."

Ilmuwan riset AI2 Nathan Lambert mengatakan di media sosial bahwa Olmoe akan membantu pembuatan kebijakan, yang dapat memberikan titik awal untuk peluncuran kluster H100 di dunia akademis. Dia juga menyebutkan bahwa rilis model Olmoe adalah bagian dari tujuan AI2 untuk mengembangkan model open source dan membuat kinerjanya sebanding dengan model tertutup.

Dalam hal pembangunan model, AI2 memutuskan untuk menggunakan 64 ahli kecil untuk perutean yang baik dan hanya mengaktifkan delapan dari mereka saat runtime. Eksperimen menunjukkan bahwa Olmoe sebanding dengan model lain dalam kinerja, tetapi secara signifikan berkurang dalam biaya inferensi dan penyimpanan memori. Olmoe juga dibangun di atas model open source OLMO1.7-7B sebelum AI2, mendukung 4096 Windows Tagged Context. Data pelatihan Olmoe berasal dari berbagai sumber, termasuk perayapan umum, Dolma CC, Wikipedia, dll.

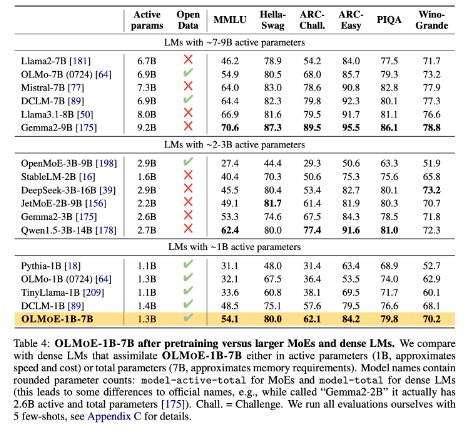

Dalam tolok ukur, OLMOE-1B-7B mengungguli banyak model yang ada bila dibandingkan dengan model dengan parameter yang sama, dan bahkan melampaui model yang lebih besar seperti LLAMA2-13B-CHAT dan Deepseekmoe-16b.

Salah satu tujuan AI2 adalah untuk memberi para peneliti model AI open source yang lebih lengkap, termasuk arsitektur ahli hibrida. Meskipun banyak pengembang menggunakan arsitektur MOE, AI2 percaya bahwa sebagian besar model AI lainnya jauh dari cukup terbuka.

HuggingFace: https://huggingface.co/collections/allenai/olmoe-66cf678c047657a30c8cd3da

Pintu masuk kertas: https://arxiv.org/abs/2409.02060

Poin -Poin Kunci:

- Model Open Source OLMOE baru yang dirilis oleh AI2 kompetitif dalam hal kinerja dan biaya.

- Olmoe mengadopsi arsitektur ahli hibrida yang jarang yang dapat secara efektif mengurangi biaya inferensi dan persyaratan memori.

- AI2 berkomitmen untuk menyediakan model AI open source sepenuhnya yang mempromosikan penelitian dan pengembangan akademik.

Singkatnya, rilis Open Source Olmoe adalah kemajuan besar di bidang model bahasa skala besar. Langkah AI2 mencerminkan komitmennya yang kuat untuk pengembangan Open Source AI dan layak dinantikan untuk kontribusi yang lebih mirip di masa depan.