Dalam beberapa tahun terakhir, biaya pelatihan model bahasa besar tetap tinggi, yang telah menjadi faktor penting yang membatasi pengembangan AI. Cara mengurangi biaya pelatihan dan meningkatkan efisiensi telah menjadi fokus perhatian industri. Para peneliti di Universitas Harvard dan Stanford telah mengambil pendekatan yang berbeda dan memulai dengan akurasi pelatihan model untuk mengeksplorasi metode pelatihan yang hemat biaya. Mereka menemukan bahwa dengan mengurangi akurasi model, jumlah perhitungan dapat dikurangi secara efektif dan bahkan meningkatkan kinerja model dalam beberapa kasus. Studi ini memberikan ide -ide baru untuk mengoptimalkan pelatihan model bahasa dan juga menunjukkan arah untuk pengembangan AI di masa depan.

Di bidang kecerdasan buatan, semakin besar skala, semakin kuat kemampuannya. Untuk mengejar model bahasa yang lebih kuat, perusahaan teknologi besar menumpuk parameter model dan data pelatihan, tetapi mereka menemukan bahwa biaya juga telah meningkat. Bukankah ada cara yang hemat biaya dan efisien untuk melatih model bahasa?

Para peneliti dari Harvard dan Stanford University baru -baru ini menerbitkan sebuah makalah yang mereka temukan bahwa ketepatan pelatihan model seperti kunci tersembunyi yang membuka "kata sandi biaya" pelatihan model bahasa.

Apa itu akurasi model? Model pembelajaran mendalam tradisional biasanya dilatih menggunakan angka titik mengambang 32-bit (FP32), tetapi dalam beberapa tahun terakhir, dengan pengembangan perangkat keras, menggunakan tipe numerik presisi yang lebih rendah, seperti angka floating point 16-bit (FP16) atau 8-bit Pelatihan bilangan bulat (int8) menjadi mungkin.

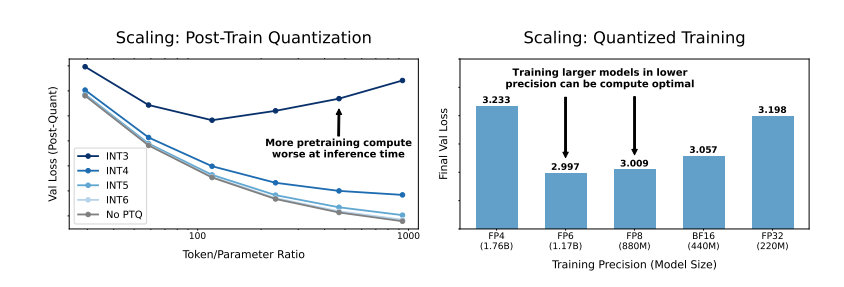

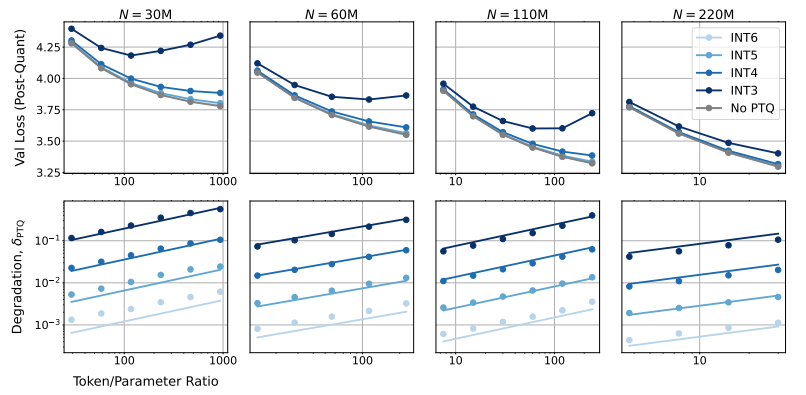

Jadi, dampak apa yang akan mengurangi akurasi model pada kinerja model? Melalui sejumlah besar percobaan, para peneliti menganalisis perubahan biaya dan kinerja pelatihan model dan inferensi pada akurasi yang berbeda, dan mengusulkan serangkaian aturan penskalaan "persepsi presisi" yang baru.

Mereka menemukan bahwa pelatihan dengan presisi yang lebih rendah dapat secara efektif mengurangi "jumlah parameter efektif" dari model, sehingga mengurangi jumlah perhitungan yang diperlukan untuk pelatihan. Ini berarti bahwa di bawah anggaran komputasi yang sama, kami dapat melatih model yang lebih besar, atau pada skala yang sama, menggunakan akurasi yang lebih rendah dapat menghemat banyak sumber daya komputasi.

Yang lebih mengejutkan, para peneliti juga menemukan bahwa dalam beberapa kasus, pelatihan dengan akurasi yang lebih rendah sebenarnya dapat meningkatkan kinerja model! Fase, model akan lebih kuat untuk pengurangan akurasi kuantisasi, sehingga menunjukkan kinerja yang lebih baik dalam fase inferensi.

Jadi, ketepatan yang harus kita pilih untuk melatih model?

Pelatihan presisi 16-bit tradisional mungkin bukan pilihan terbaik. Penelitian mereka menunjukkan bahwa akurasi 7-8-bit mungkin merupakan pilihan yang lebih hemat biaya.

Ini bukan langkah bijak untuk mengejar pelatihan presisi yang sangat rendah (seperti 4-bit). Karena pada akurasi yang sangat rendah, jumlah parameter efektif model akan turun tajam, untuk mempertahankan kinerja, kita perlu secara signifikan meningkatkan ukuran model, yang akan mengarah pada biaya komputasi yang lebih tinggi.

Akurasi pelatihan yang optimal dapat bervariasi untuk model berbagai ukuran. Untuk model yang membutuhkan banyak "overtraining", seperti seri LLAMA-3 dan GEMMA-2, pelatihan dengan akurasi yang lebih tinggi mungkin lebih hemat biaya.

Studi ini memberikan perspektif yang sama sekali baru bagi kami untuk memahami dan mengoptimalkan pelatihan model bahasa. Ini memberi tahu kita bahwa pilihan akurasi tidak statis, tetapi perlu diperdagangkan berdasarkan ukuran model spesifik, volume data pelatihan dan skenario aplikasi.

Tentu saja, penelitian ini juga memiliki beberapa keterbatasan. Misalnya, model yang mereka gunakan berukuran relatif kecil dan hasil eksperimen mungkin tidak secara langsung digeneralisasikan ke model yang lebih besar. Selain itu, mereka hanya fokus pada fungsi kehilangan model dan tidak mengevaluasi kinerja model pada tugas hilir.

Namun demikian, penelitian ini sangat penting. Ini mengungkapkan hubungan yang kompleks antara akurasi model dan kinerja model dan biaya pelatihan, dan memberikan wawasan yang berharga bagi kami untuk merancang dan melatih model bahasa yang lebih kuat dan lebih ekonomis di masa depan.

Kertas: https://arxiv.org/pdf/2411.04330

Singkatnya, penelitian ini memberikan ide dan metode baru untuk mengurangi biaya pelatihan model bahasa besar, dan memberikan nilai referensi penting untuk pengembangan bidang kecerdasan buatan di masa depan. Meskipun ada beberapa keterbatasan dalam penelitian, aturan penskalaan "persepsi presisi" yang diusulkannya dan diskusi mendalam tentang hubungan antara akurasi model dan biaya dan kinerja memiliki signifikansi panduan teoritis dan praktis yang penting.