Tim Lab Shanghai AI telah membuka sumber versi LLAMA dari proyek O1, yang merupakan proyek replika open source untuk alat pemecahan masalah Olimpiade Openai O1. Proyek ini menggunakan teknologi canggih seperti Monte Carlo Tree Search and Reinforcement Learning untuk mencapai hasil yang luar biasa dalam menjawab pertanyaan Olimpiade Matematika, dan kinerjanya bahkan melebihi beberapa solusi sumber tertutup komersial. Sumber terbuka proyek ini memberi pengembang sumber belajar yang berharga dan fondasi penelitian, dan juga mempromosikan pengembangan lebih lanjut dari penerapan kecerdasan buatan di bidang matematika. Proyek ini mencakup set data pra-terlatih, model pra-terlatih dan kode pelatihan pembelajaran penguatan, dll., Dan menggunakan berbagai teknologi optimasi termasuk LORA dan PPO, yang bertujuan untuk meningkatkan kemampuan model dalam penalaran matematika.

Baru-baru ini, tim Lab Shanghai AI merilis versi LLAMA dari proyek O1, yang bertujuan untuk mereplikasi alat pemecahan masalah Olimpiade Openai O1. Proyek ini mengadopsi berbagai teknologi canggih, termasuk pencarian pohon Monte Carlo, pembelajaran penguatan mandiri, PPO dan paradigma strategi ganda Alphago Zero, yang telah menarik perhatian luas dari komunitas pengembang.

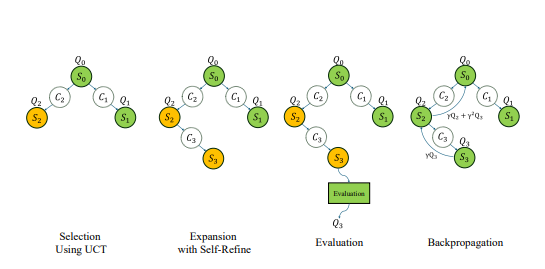

Jauh sebelum rilis Seri O1 Openai, tim Lab Shanghai AI mulai mengeksplorasi penggunaan pencarian pohon Monte Carlo untuk meningkatkan kemampuan matematika model besar. Setelah rilis O1, tim selanjutnya meningkatkan algoritma, berfokus pada masalah Olympiad matematika, dan mengembangkannya sebagai versi open source dari Proyek Strawberry Openai.

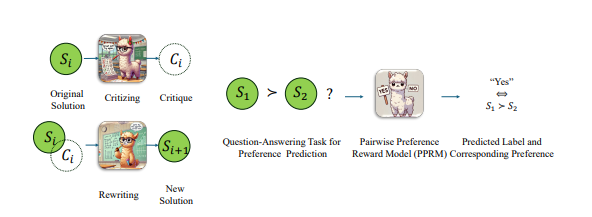

Untuk meningkatkan kinerja model LLAMA dalam masalah Olimpiade Matematika, tim mengadopsi strategi optimasi berpasangan, yaitu, tidak secara langsung memberikan skor absolut dari jawabannya, tetapi lebih membandingkan keuntungan relatif dan kerugian dari kedua jawaban tersebut. Dengan pendekatan ini, mereka telah membuat kemajuan yang signifikan dalam tolok ukur AIME2024 yang paling sulit. Di antara 30 pertanyaan tes, model yang dioptimalkan dilakukan dengan benar 8, sedangkan model llama-3.1-8b-instruct asli dilakukan dengan benar 2. Prestasi ini mengungguli solusi sumber tertutup komersial lainnya selain O1-preview dan O1-Mini.

Pada akhir Oktober, tim mengumumkan kemajuan yang signifikan dalam mereplikasi OpenAI O1 berdasarkan arsitektur Alphago Zero, berhasil memungkinkan model untuk mendapatkan kemampuan berpikir canggih melalui interaksi dengan pohon pencarian selama proses pembelajaran tanpa anotasi manual. Dalam waktu kurang dari seminggu, proyek dibuka.

Saat ini, konten open source dari LLAMA Versi O1 meliputi: set data pra-terlatih, model pra-terlatih, dan kode pelatihan pembelajaran penguatan. Di antara mereka, kumpulan data "OpenLongCot-pretrain" berisi lebih dari 100.000 data rantai pemikiran yang panjang, setiap data berisi proses penalaran masalah matematika yang lengkap, termasuk konten pemikiran, hasil penilaian, deskripsi masalah, koordinat grafik, proses perhitungan, pengurangan kesimpulan dan lainnya Tautan inferensi lengkap, serta kritik dan verifikasi setiap langkah inferensi, memberikan evaluasi dan panduan untuk proses inferensi. Setelah melanjutkan pra-pelatihan pada dataset ini, model dapat membaca dan mengeluarkan proses rantai pemikiran panjang seperti O1.

Meskipun proyek ini disebut Llama-O1, model pra-terlatih yang saat ini disediakan oleh pejabat ini didasarkan pada Google Gemma2. Berdasarkan model pra-terlatih, pengembang dapat terus melakukan pelatihan pembelajaran penguatan. Proses pelatihan meliputi: Menggunakan Monte Carlo Tree untuk mendapatkan pengalaman sendiri untuk menghasilkan pengalaman; Beberapa teknologi utama juga digunakan dalam kode pelatihan, termasuk menggunakan LORA untuk fine-tuning parameter yang efisien, menggunakan algoritma PPO sebagai metode optimasi strategi, menerapkan algoritma GAE untuk menghitung fungsi yang menguntungkan, dan menggunakan pemutaran pengalaman prioritas untuk meningkatkan efisiensi pelatihan.

Perlu dicatat bahwa kode Llama-O1 diterbitkan di bawah akun GitHub yang disebut SimpleBerry. Dari akun terkait SimpleBerry lainnya dan informasi situs web resmi, hanya dapat dilihat bahwa sifatnya adalah laboratorium penelitian, tetapi tidak ada lebih banyak informasi tentang arah penelitian yang diungkapkan.

Selain Llama-O1, proyek replika O1 lainnya yang berkembang secara publik adalah O1-Journey dari tim Universitas Shanghai Jiaotong. Tim merilis laporan kemajuan pertamanya pada awal Oktober, memperkenalkan paradigma pembelajaran perjalanan inovatif dan model pertama yang berhasil mengintegrasikan pencarian dan pembelajaran ke dalam penalaran matematika. Tim pengembangan inti O1-Journey terutama terdiri dari sarjana junior dan senior di Universitas Shanghai Jiaotong, serta mahasiswa doktoral tahun pertama dari Laboratorium Gair (Laboratorium Penelitian Kecerdasan Buatan Umum). di Universitas Shanghai Jiaotong.

Alamat kertas: https://arxiv.org/pdf/2410.02884

https://arxiv.org/pdf/2406.07394

Sumber terbuka proyek LLAMA O1 menandai kemajuan penting di bidang pemecahan masalah matematika AI dan juga memberikan fondasi yang kuat untuk penelitian dan aplikasi lebih lanjut. Kami menantikan pencapaian yang lebih inovatif berdasarkan proyek ini di masa depan.