Tim peneliti Meta Fair, UC Berkeley dan Universitas New York telah berkolaborasi dalam pengembangan teknologi baru yang disebut Thinking Preference Optimization (TPO) untuk secara signifikan meningkatkan kepatuhan instruksi dan kualitas respons dalam model bahasa besar (LLM). Tidak seperti LLM tradisional yang memberikan jawaban secara langsung, teknologi TPO memungkinkan model untuk berpikir dan merefleksikan secara internal sebelum membalas, sehingga menghasilkan jawaban yang lebih akurat dan koheren. Inovasi ini memandu model untuk mengoptimalkan proses berpikirnya tanpa menunjukkan kepada pengguna langkah -langkah perantara, pada akhirnya meningkatkan kualitas respons melalui metode penalaran rantai (COT) yang ditingkatkan.

Inti dari teknologi TPO adalah metode penalaran rantai pemikiran (COT) yang ditingkatkan. Pendekatan ini mendorong model untuk "berpikir dan menjawab" selama pelatihan, membantu mereka membangun proses berpikir batin yang lebih terorganisir sebelum memberikan jawaban akhir. Isyarat COT tradisional kadang -kadang dapat menyebabkan penurunan akurasi dan cukup sulit untuk dilatih karena kurangnya langkah -langkah berpikir yang jelas. Dan TPO berhasil mengatasi tantangan ini dengan memungkinkan model untuk mengoptimalkan dan menyederhanakan proses berpikir mereka tanpa mengekspos langkah -langkah perantara kepada pengguna.

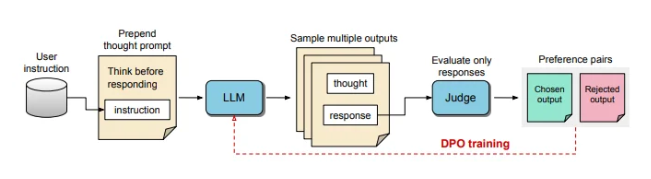

Selama proses pelatihan TPO, pertama -tama meminta model bahasa besar untuk menghasilkan banyak ide, dan kemudian memilah jawaban akhir. Output ini kemudian dievaluasi dengan model "judger" untuk memilih jawaban yang berkinerja terbaik dan berkinerja terburuk. Hasil evaluasi ini digunakan sebagai pasangan "pilihan" dan "tolak" untuk optimasi preferensi langsung (DPO) untuk terus meningkatkan kualitas respons model.

Dengan menyesuaikan petunjuk pelatihan, TPO mendorong model untuk berpikir secara internal sebelum menjawab. Proses ini memandu model untuk mengoptimalkan jawabannya agar lebih jelas dan lebih relevan. Pada akhirnya, evaluasi dilakukan oleh model penilaian berbasis LLM yang hanya mencetak jawaban akhir, sehingga membantu model meningkatkan kualitas jawaban secara independen dari langkah-langkah pemikiran tersembunyi. TPO juga menggunakan optimasi preferensi langsung untuk membuat jawaban yang disukai dan penolakan yang berisi pemikiran tersembunyi, dan setelah beberapa putaran pelatihan, lebih lanjut memperbaiki proses internal model.

Dalam tolok ukur untuk alpacaeval dan arena-hard, metode TPO mengungguli garis dasar respons tradisional dan lebih baik daripada model "tips pemikiran" Llama-3-8B-instruct dari "tips berpikir". Pelatihan berulang dari metode ini mengoptimalkan kemampuan generasi berpikir, pada akhirnya melampaui beberapa model dasar. Perlu disebutkan bahwa TPO tidak hanya cocok untuk tugas logika dan matematika, tetapi juga melakukan upaya besar dalam bidang kreatif seperti instruksi pemasaran dan kesehatan untuk mengikuti tugas.

AI dan pakar robotika Karan Verma berbagi pandangannya tentang konsep "Thinking LLM" di platform sosial X, mengatakan bahwa ia sangat bersemangat tentang hal itu dan menantikan potensi inovasi ini dalam aplikasi medis yang dapat membawa lebih banyak pasien .

Proses pemikiran internal terstruktur ini memungkinkan model untuk memproses instruksi yang kompleks secara lebih efektif, lebih lanjut memperluas aplikasinya di area yang membutuhkan penalaran multi-level dan pemahaman yang cermat tanpa perlu manusia untuk memberikan data pemikiran khusus. Studi ini menunjukkan bahwa TPO memiliki potensi untuk membuat model bahasa besar lebih fleksibel dan efisien dalam konteks yang beragam, cocok untuk area di mana ada persyaratan tinggi untuk fleksibilitas dan kedalaman generasi respons.

Kemajuan terobosan dalam teknologi TPO telah membawa kesimpulan yang lebih kuat dan pemahaman kemampuan untuk model bahasa besar, membuka kemungkinan baru untuk aplikasi mereka di berbagai bidang, terutama dalam tugas yang membutuhkan proses berpikir yang kompleks.