Meta AI, bersama dengan para peneliti dari University of California, Berkeley dan New York University, telah mengembangkan pendekatan baru yang disebut Thinking Preference Optimization (TPO) yang bertujuan untuk secara signifikan meningkatkan kualitas respons model bahasa besar (LLM). Tidak seperti metode tradisional yang hanya berfokus pada jawaban akhir, TPO memungkinkan model untuk berpikir secara internal sebelum menghasilkan jawaban, menghasilkan respons yang lebih akurat dan koheren. Metode penalaran rantai pemikiran (COT) yang ditingkatkan teknologi ini mengatasi kekurangan dari akurasi dan kesulitan rendah metode COT sebelumnya dalam pelatihan melalui optimasi dan merampingkan proses pemikiran internal model, dan pada akhirnya menghasilkan jawaban yang lebih tinggi dan dalam banyak hal setiap tes benchmark.

Tidak seperti model tradisional yang hanya berfokus pada jawaban akhir, metode TPO memungkinkan model untuk berpikir secara internal sebelum menghasilkan respons, menghasilkan jawaban yang lebih akurat dan koheren.

Teknologi baru ini menggabungkan metode penalaran rantai-dipikirkan (COT) yang ditingkatkan. Selama proses pelatihan, metode ini mendorong model untuk "berpikir" sebelum merespons, membantunya membangun proses berpikir internal yang lebih sistematis. COT langsung sebelumnya meminta kadang -kadang mengurangi akurasi, dan proses pelatihan sulit karena kurangnya langkah -langkah berpikir yang jelas. TPO mengatasi keterbatasan ini dengan memungkinkan model untuk mengoptimalkan dan merampingkan proses berpikirnya, dan tidak menunjukkan langkah -langkah pemikiran menengah di depan pengguna.

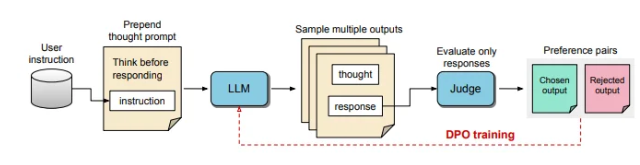

Dalam proses TPO, model bahasa besar pertama kali diminta untuk menghasilkan beberapa proses pemikiran, dan kemudian output ini disampel dan dievaluasi sebelum membentuk respons akhir. Model evaluasi kemudian akan mencetak output untuk menentukan respons yang optimal dan terburuk. Dengan menggunakan output ini sebagai pilihan dan penolakan untuk optimasi preferensi langsung (DPO), metode pelatihan berulang ini meningkatkan kemampuan model untuk menghasilkan respons yang lebih relevan dan berkualitas tinggi, sehingga meningkatkan hasil keseluruhan.

Dalam metode ini, petunjuk pelatihan disesuaikan, mendorong model untuk berpikir secara internal sebelum merespons. Respons akhir yang dievaluasi dinilai oleh model evaluasi berbasis LLM, yang memungkinkan model untuk meningkatkan kualitas semata-mata pada efektivitas respons tanpa mempertimbangkan langkah-langkah berpikir implisit. Selain itu, TPO menggunakan optimasi preferensi langsung untuk membuat respons preferensi dan penolakan yang mengandung pemikiran implisit, dan lebih lanjut memperbaiki proses internal model melalui beberapa siklus pelatihan.

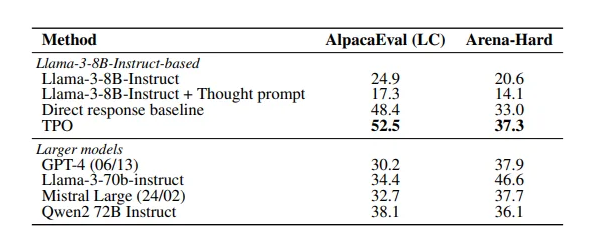

Hasil penelitian menunjukkan bahwa metode TPO berkinerja baik dalam beberapa tolok ukur, melampaui berbagai model yang ada. Pendekatan ini tidak hanya berlaku untuk tugas-tugas logis dan matematika, tetapi juga menunjukkan potensi dalam bidang kreatif seperti tugas pemasaran dan pengikut perintah kesehatan.

Kertas: https://arxiv.org/pdf/2410.10630

Poin -Poin Kunci:

Teknologi TPO meningkatkan kemampuan berpikir model bahasa besar sebelum menghasilkan respons, memastikan bahwa respons lebih akurat.

Melalui peningkatan penalaran rantai pemikiran, model dapat mengoptimalkan dan merampingkan proses berpikir internal dan meningkatkan kualitas respons.

TPO cocok untuk berbagai bidang, tidak hanya untuk tugas logis dan matematika, tetapi juga untuk kreatif dan kesehatan.

Singkatnya, metode TPO memberikan ide baru untuk peningkatan kinerja model bahasa besar. Tautan makalah ini nyaman bagi pembaca untuk mendapatkan wawasan tentang detail teknis dan hasil eksperimennya.