Pelatihan dan optimalisasi model bahasa besar (LLM) adalah tantangan utama di bidang kecerdasan buatan. Metode pelatihan yang efisien dan output model yang sesuai dengan nilai manusia sangat penting. Penguatan Penguatan dan Umpan Balik Manusia (RLHF) adalah metode pelatihan LLM utama. Untuk tujuan ini, tim Model Besar Bytedance Doubao membuka kerangka kerja RLHF yang disebut HybridFlow, yang bertujuan untuk menyelesaikan masalah ini dan membawa kemungkinan baru ke pelatihan LLM. Melalui desain inovatif, kerangka kerja ini meningkatkan efisiensi dan fleksibilitas pelatihan LLM.

Model besar (LLM) seperti GPT dan Llama telah memicu revolusi di bidang kecerdasan buatan, tetapi bagaimana cara melatih model -model besar ini secara efisien dan membuatnya sejalan dengan nilai -nilai kemanusiaan tetap menjadi masalah yang sulit.

Pembelajaran penguatan dan umpan balik manusia (RLHF) telah banyak digunakan dalam beberapa tahun terakhir sebagai metode pelatihan LLM yang penting, tetapi kerangka kerja RLHF tradisional memiliki keterbatasan dalam fleksibilitas, efisiensi, dan skalabilitas.

Untuk menyelesaikan masalah ini, Hytedance Doubao Big Model Team Open Source Kerangka kerja RLHF yang disebut HybridFlow, membawa kemungkinan baru untuk pelatihan LLM.

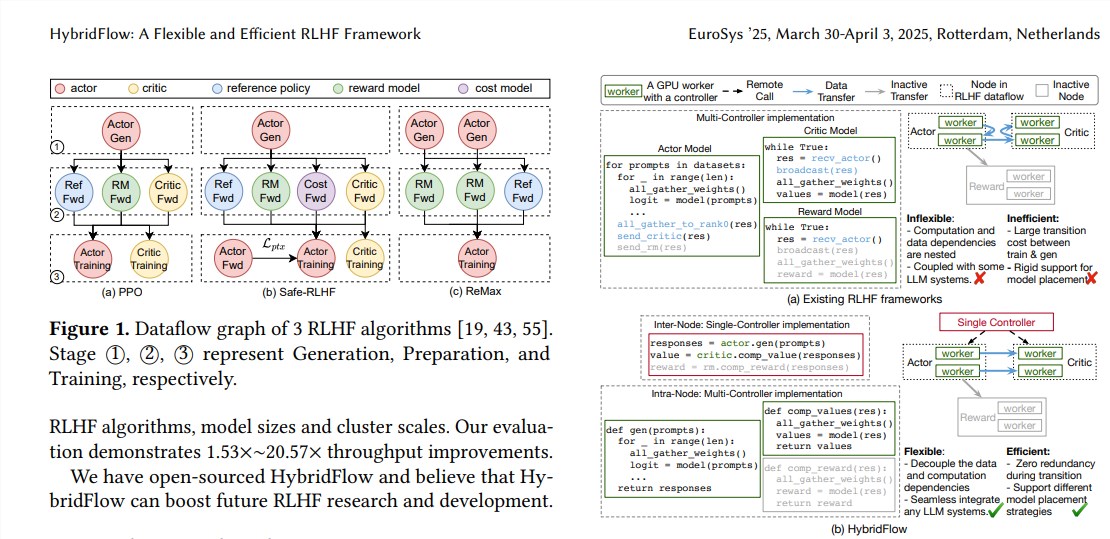

RLHF biasanya terdiri dari tiga tahap:

Pertama, model aktor menghasilkan teks berdasarkan prompt input;

Akhirnya, hasil evaluasi ini digunakan untuk melatih model aktor untuk menghasilkan teks yang lebih sesuai dengan preferensi manusia. Kerangka kerja RLHF tradisional biasanya menggunakan pengontrol tunggal untuk mengelola seluruh aliran data, tetapi ini tidak efisien untuk LLM yang memerlukan komputasi terdistribusi.

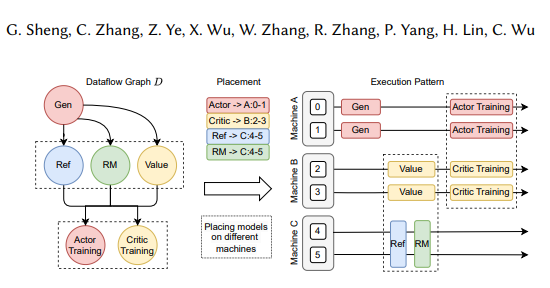

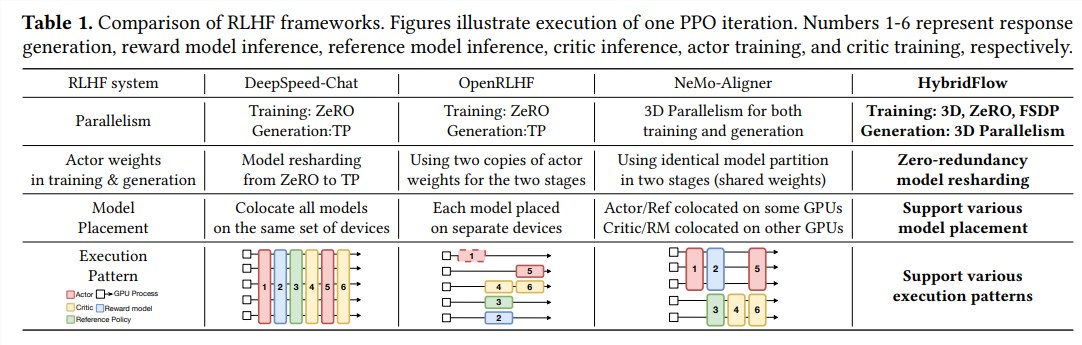

Kerangka kerja hybridflow secara inovatif menggabungkan mode tunggal dan multi-pengontrol dan memisahkan komputasi kompleks dan ketergantungan data melalui desain API hierarkis, memungkinkan representasi fleksibel dan eksekusi efisien aliran data RLHF.

Keuntungan hybridflow terutama tercermin dalam tiga aspek berikut:

Dukungan fleksibel untuk berbagai algoritma dan model RLHF: HybridFlow menyediakan API modular, di mana pengguna dapat dengan mudah menerapkan dan memperluas berbagai algoritma RLHF, seperti PPO, REMAX dan Safe-RLHF.

Reorganisasi berat model yang efisien: Komponen 3D-hybridengine mendukung model aktor untuk secara efisien mengatur ulang bobot model selama tahap pelatihan dan generasi, meminimalkan redundansi memori dan overhead komunikasi.

Penyebaran model otomatis dan pemilihan kebijakan paralel: Komponen pemetaan otomatis dapat secara otomatis memetakan model ke perangkat yang berbeda berdasarkan muatan model dan ketergantungan data dan memilih kebijakan paralel terbaik, sehingga menyederhanakan proses penyebaran model dan meningkatkan efisiensi pelatihan.

Hasil eksperimen menunjukkan bahwa throughput HybridFlow meningkat secara signifikan ketika menjalankan berbagai algoritma RLHF, hingga 20,57 kali. Open Source HybridFlow akan menyediakan alat yang kuat untuk penelitian dan pengembangan RLHF untuk mempromosikan pengembangan teknologi LLM di masa depan.

Alamat kertas: https://arxiv.org/pdf/2409.19256

Sumber terbuka dari kerangka kerja hybridflow menyediakan cara yang efektif untuk meningkatkan proses pelatihan LLM. Kami menantikan HybridFlow memainkan peran yang lebih besar dalam penelitian LLM di masa depan.