Rakuten Group merilis Model Bahasa Besar Jepang Pertama (LLM) Rakuten AI2.0 dan Model Bahasa Kecil (SLM) Rakuten AI2.0Mini, yang bertujuan untuk mempromosikan pengembangan kecerdasan buatan di Jepang. Rakuten AI2.0 mengadopsi arsitektur ahli hybrid (MOE) dan memiliki delapan model ahli dengan 7 miliar parameter. Rakuten AI2.0Mini adalah model kompak dengan 1,5 miliar parameter, yang dirancang untuk penyebaran perangkat tepi, dengan mempertimbangkan efektivitas biaya dan kemudahan aplikasi. Kedua model adalah open source dan menyediakan versi fine-tuning dan preferensi yang dioptimalkan untuk mendukung berbagai tugas pembuatan teks.

Rakuten Group mengumumkan peluncuran model bahasa besar Jepang pertama (LLM) dan model bahasa kecil (SLM), bernama Rakuten AI2.0 dan Rakuten AI2.0 Mini.

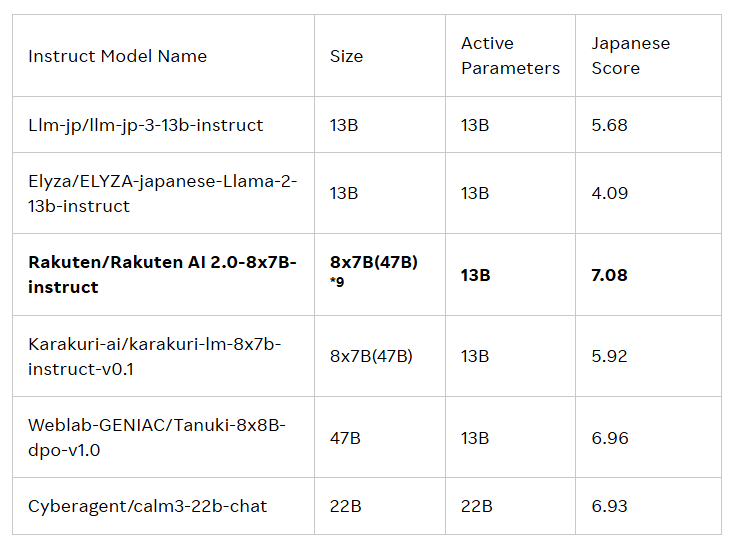

Rilis kedua model ini dimaksudkan untuk mendorong pengembangan kecerdasan buatan (AI) di Jepang. Rakuten AI2.0 didasarkan pada arsitektur ahli hybrid (MOE) dan merupakan model 8x7b yang terdiri dari delapan model dengan 7 miliar parameter, masing -masing berfungsi sebagai ahli. Setiap kali token input diproses, sistem akan mengirimkannya ke dua ahli yang paling relevan, dan router bertanggung jawab untuk memilihnya. Para ahli dan router ini terus berlatih bersama melalui sejumlah besar data bilingual Jepang dan Inggris berkualitas tinggi.

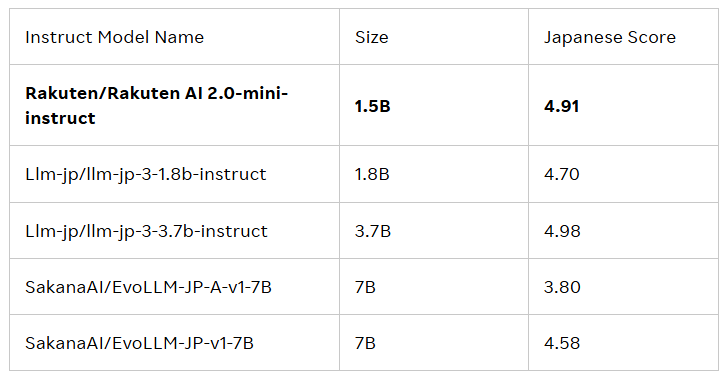

Rakuten AI2.0Mini adalah model padat baru dengan volume parameter 1,5 miliar, yang dirancang untuk penyebaran perangkat tepi yang hemat biaya dan cocok untuk skenario aplikasi tertentu. Ini juga dilatih pada data campuran di Jepang dan Inggris, dengan tujuan memberikan solusi yang nyaman. Kedua model telah disempurnakan dan disukai, dan telah merilis model dasar dan model instruksi untuk mendukung perusahaan dan profesional dalam mengembangkan aplikasi AI.

Semua model berada di bawah perjanjian lisensi APACHE2.0, yang dapat diperoleh pengguna di perpustakaan resmi Grup Rakuten. Selain itu, model -model ini juga dapat berfungsi sebagai dasar untuk model lain, yang memfasilitasi pengembangan dan aplikasi lebih lanjut.

Cai Ting, Kepala AI dan Petugas Data di Rakuten Group, mengatakan: “Saya sangat bangga dengan bagaimana tim kami menggabungkan data, teknik, dan sains untuk meluncurkan Rakuten AI2.0. Perusahaan membuat keputusan yang cerdas, mempercepat realisasi nilai, dan membuka kemungkinan baru. . "

Blog resmi: https://global.rakuten.com/corp/news/press/2025/0212_02.html

Poin -Poin Kunci:

Rakuten Group meluncurkan model bahasa besar Jepang pertama (LLM) dan model bahasa kecil (SLM), yang disebut Rakuten AI2.0 dan Rakuten AI2.0 Mini.

Rakuten AI2.0 didasarkan pada arsitektur ahli hibrida dan memiliki delapan model ahli dengan 7 miliar parameter, berkomitmen untuk memproses data bilingual Jepang dan Inggris secara efisien.

Semua model tersedia di Perpustakaan Face Rakuten Hugging Resmi, cocok untuk berbagai tugas pembuatan teks dan berfungsi sebagai dasar untuk model lain.

Singkatnya, peluncuran Rakuten AI2.0 dan Rakuten AI2.0Mini menandai kemajuan penting lainnya di Jepang di bidang model bahasa besar. untuk aplikasi dan dampaknya di masa depan.