Dalam beberapa tahun terakhir, dengan perkembangan cepat model bahasa besar, model peningkatan inferensi juga memicu diskusi ekstensif tentang tingkat halusinasi mereka sambil meningkatkan kemampuan pemrosesan tugas kompleks. Tim pembelajaran mesin Vectara baru-baru ini melakukan studi mendalam tentang model seri Deepseek, mengungkapkan perbedaan yang signifikan dalam model peningkatan inferensi dalam hal tingkat halusinasi.

Baru-baru ini, tim pembelajaran mesin Vectara melakukan tes halusinasi mendalam pada dua model seri Deepseek. V3. Ini menunjukkan bahwa Deepseek-R1 menghasilkan lebih tidak akurat atau tidak konsisten dengan informasi asli selama proses penambahan penalaran. Hasil ini memicu diskusi ekstensif tentang tingkat halusinasi model bahasa besar yang ditingkatkan inferensi (LLM).

Catatan Sumber Gambar: Gambar dihasilkan oleh AI, dan Penyedia Layanan Resmi Gambar Midjourney

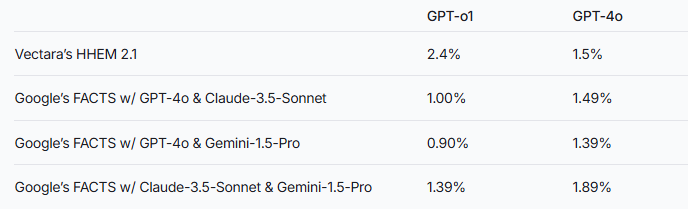

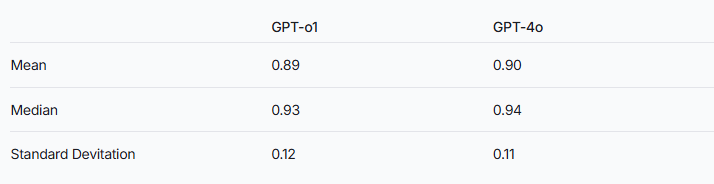

Tim peneliti menunjukkan bahwa model augmentasi inferensi mungkin lebih rentan terhadap halusinasi daripada model bahasa besar biasa. Fenomena ini sangat jelas dalam perbandingan seri Deepseek dengan model peningkatan inferensi lainnya. Mengambil seri GPT sebagai contoh, perbedaan tingkat halusinasi antara GPT-O1 yang ditingkatkan oleh penalaran dan versi normal GPT-4O juga memverifikasi spekulasi ini.

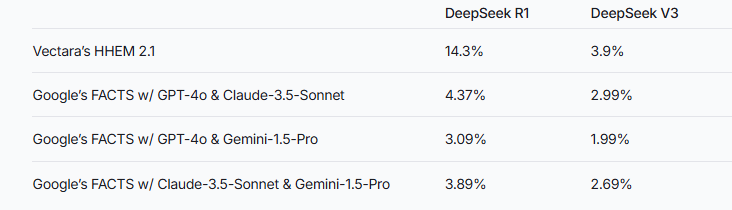

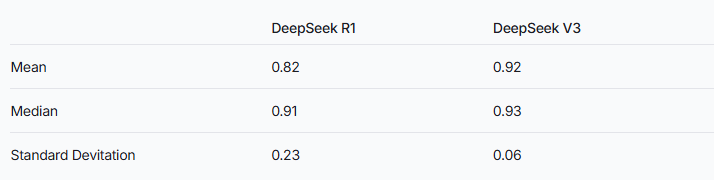

Untuk mengevaluasi kinerja kedua model ini, para peneliti menggunakan model HHEM Vectara dan metode fakta Google untuk membuat penilaian. Sebagai alat deteksi halusinasi khusus, HHEM menunjukkan sensitivitas yang lebih tinggi ketika menangkap peningkatan tingkat halusinasi Deepseek-R1, sementara model fakta berkinerja relatif buruk dalam hal ini. Ini mengingatkan kita bahwa HHEM mungkin lebih efektif daripada LLM sebagai standar.

Perlu dicatat bahwa Deepseek-R1, terlepas dari penalaran yang sangat baik dalam penalaran, disertai dengan tingkat halusinasi yang lebih tinggi. Ini mungkin terkait dengan logika kompleks yang diperlukan untuk memproses model peningkatan inferensi. Ketika kompleksitas penalaran model meningkat, keakuratan konten yang dihasilkan dapat dipengaruhi sebagai gantinya. Tim peneliti juga menekankan bahwa jika Deepseek dapat lebih fokus pada pengurangan halusinasi selama fase pelatihan, dimungkinkan untuk mencapai keseimbangan yang baik antara kemampuan penalaran dan akurasi.

Sementara model yang ditingkatkan inferensi umumnya menunjukkan halusinasi yang lebih tinggi, ini tidak berarti bahwa mereka tidak memiliki keuntungan dalam hal lain. Untuk seri Deepseek, masih perlu untuk menyelesaikan halusinasi dalam penelitian dan optimasi selanjutnya untuk meningkatkan kinerja model keseluruhan.

Referensi: https://www.vectara.com/blog/deepseek-r1-hallucinates-more-than-deepseek-v3

Dengan evolusi model bahasa besar yang berkelanjutan, bagaimana mengurangi tingkat halusinasi sambil meningkatkan kemampuan penalaran akan menjadi arah penting untuk penelitian di masa depan. Hasil tes dari seri Deepseek memberi kami referensi berharga untuk mempromosikan industri untuk lebih mengoptimalkan kinerja model.