Dengan perkembangan cepat teknologi kecerdasan buatan, model bahasa menjadi semakin banyak digunakan di berbagai bidang. Namun, sebuah studi Openai baru mengungkapkan bahwa model -model ini bernasib jauh dari harapan ketika menjawab pertanyaan faktual, memicu pemikiran ulang kemampuan AI untuk memperoleh pengetahuan.

Sebuah studi baru -baru ini oleh Openai menunjukkan bahwa meskipun perkembangan cepat teknologi kecerdasan buatan, model bahasa paling canggih saat ini memiliki tingkat keberhasilan yang jauh lebih rendah dalam menjawab pertanyaan faktual.

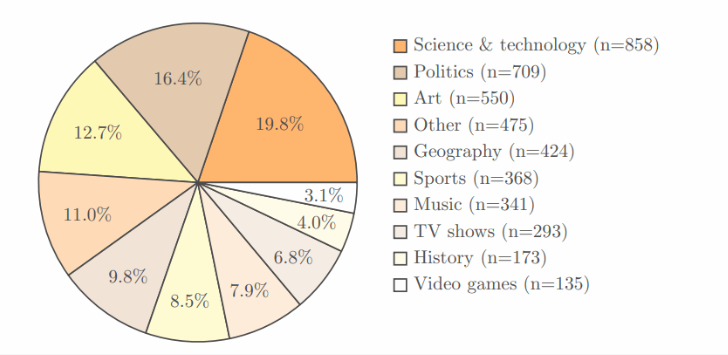

Studi ini mengadopsi tes benchmark SimpleQA Openai sendiri, yang berisi 4.326 area, mencakup berbagai bidang seperti sains, politik dan seni, dan setiap pertanyaan memiliki jawaban yang jelas dan benar.

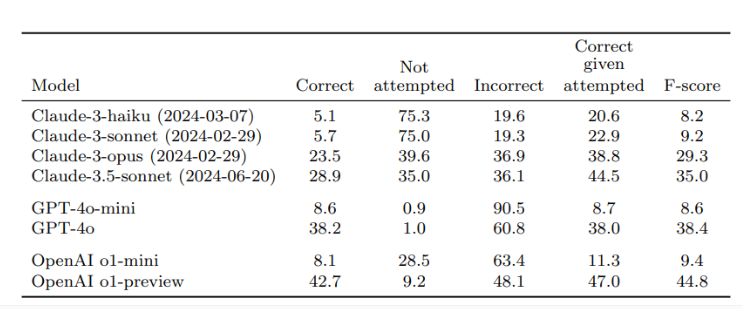

Setelah verifikasi oleh dua pengulas independen, hasilnya menunjukkan bahwa tingkat akurasi preview O1, model terbaik dari openai, hanya 42,7%, sedangkan GPT-4O sedikit lebih rendah, hanya 38,2%. Adapun GPT-4O-Mini yang lebih kecil, tingkat akurasi bahkan hanya 8,6%. Sebaliknya, model Claude Anthropic berkinerja lebih buruk, dengan tingkat akurasi Claude-3.5-Sonnet hanya 28,9%.

Kunci dari penelitian ini adalah desain tes, tidak hanya untuk menguji kinerja AI, tetapi juga untuk membuat semua orang menyadari keterbatasan model AI dalam hal akuisisi pengetahuan. Peneliti menekankan bahwa ketika menggunakan model ini, pengguna harus menganggapnya sebagai alat pemrosesan informasi daripada mengandalkan sepenuhnya pada sumber pengetahuan. Untuk mendapatkan jawaban yang lebih akurat, yang terbaik adalah memberikan data yang dapat diandalkan untuk AI daripada hanya mengandalkan pengetahuan bawaannya.

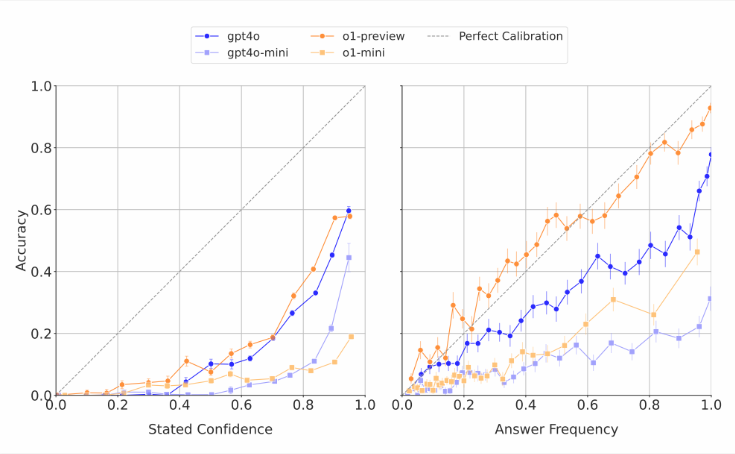

Perlu dicatat bahwa model AI sering memperkirakan kemampuan mereka sendiri. Para peneliti menemukan bahwa ketika model -model ini diminta untuk mencetak kepercayaan pada tanggapan mereka, mereka biasanya memberikan skor akurasi yang berlebihan. Dalam tes yang berulang kali menjawab pertanyaan yang sama, bahkan jika model memberikan jawaban yang sama beberapa kali, tingkat keberhasilan aktual mereka masih lebih rendah daripada keakuratan evaluasi diri mereka. Ini konsisten dengan kritik dunia luar yang sering menghasilkan jawaban yang tidak masuk akal untuk model bahasa tetapi tampaknya percaya diri.

Para peneliti percaya bahwa ada kesenjangan yang jelas dalam akurasi faktual sistem AI saat ini dan sangat membutuhkan perbaikan. Pada saat yang sama, mereka juga mengajukan pertanyaan terbuka: apakah kinerja AI dalam menjawab pertanyaan faktual pendek dapat memprediksi bagaimana kinerjanya ketika berhadapan dengan jawaban yang lebih lama dan lebih kompleks. Untuk mendukung pengembangan model bahasa yang lebih andal, OpenAI telah menerbitkan data tentang tolok ukur SimpleQA secara publik di GitHub.

Poin -Poin Kunci:

Penelitian Openai menunjukkan bahwa model bahasa paling canggih memiliki tingkat keberhasilan yang rendah ketika menjawab pertanyaan faktual, dengan tingkat keberhasilan maksimum hanya 42,7%.

Model AI ini sering melebihi kemampuan mereka dan skor kepercayaan diri mereka umumnya dilebih -lebihkan.

Openai telah membuat benchmark sederhana publik untuk membantu meneliti model bahasa yang lebih andal.

Studi ini mengingatkan kita bahwa meskipun ada kemajuan yang signifikan dalam teknologi AI, keterbatasannya perlu diperlakukan dengan hati -hati dalam aplikasi praktis dan terus mempromosikan peningkatan teknologi.