Penelitian terbaru di bidang kecerdasan buatan mengungkapkan kesamaan yang mengejutkan antara model bahasa besar (LLM) dan struktur otak manusia. Melalui analisis mendalam tentang ruang aktivasi LLM, para ilmuwan di MIT menemukan bahwa struktur internalnya memiliki korespondensi yang signifikan dengan tingkat mikro, meso dan makro otak manusia. Penemuan ini tidak hanya memberikan perspektif baru bagi kita untuk memahami cara kerja AI, tetapi juga meletakkan dasar bagi pengembangan sistem AI yang lebih cerdas di masa depan.

AI sebenarnya sudah mulai "menumbuhkan otak Anda"?!

Penelitian ini menggunakan teknologi autoencoder yang jarang untuk melakukan analisis mendalam tentang ruang aktivasi LLM dan menemukan tiga tingkat karakteristik struktural, yang luar biasa:

Pertama, pada tingkat mikroskopis, para peneliti menemukan adanya struktur "kristal". Wajah -wajah "kristal" ini terdiri dari jajaran genjang atau trapesium, mirip dengan analogi kosa kata yang akrab seperti "Man: Women: King: Queen".

Yang lebih mengejutkan adalah bahwa struktur "kristal" ini menjadi lebih jelas setelah menghilangkan beberapa faktor gangguan yang tidak relevan (seperti panjang kata) melalui teknik analisis diskriminan linier.

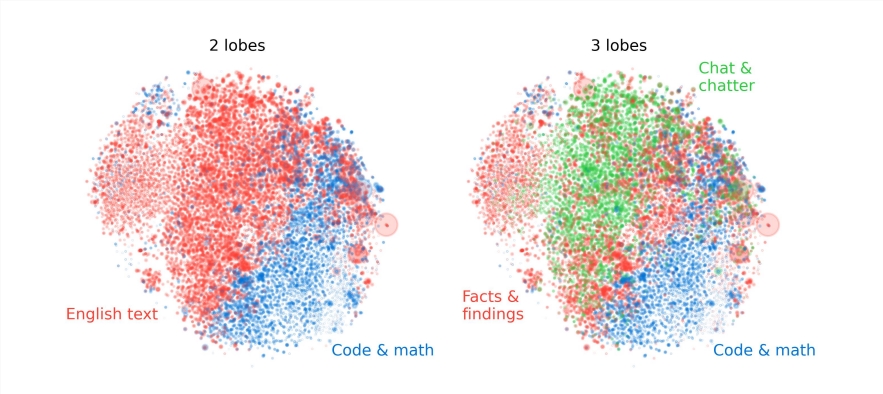

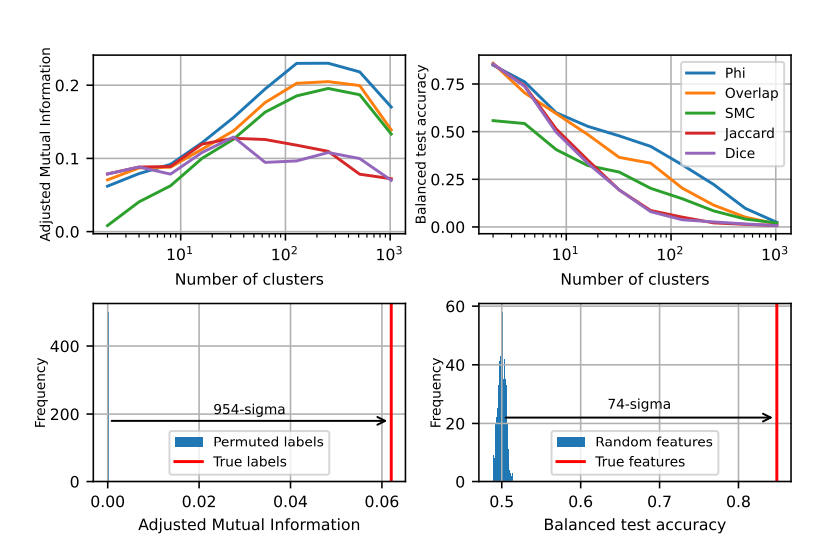

Kedua, pada tingkat meso, para peneliti menemukan bahwa ruang aktivasi LLM memiliki struktur modular yang mirip dengan partisi fungsional otak manusia.

Misalnya, fitur yang terkait dengan matematika dan kode akan berkumpul bersama untuk membentuk "lobus otak" yang mirip dengan lobus fungsional otak manusia. Melalui analisis kuantitatif oleh beberapa indikator, para peneliti mengkonfirmasi lokalitas spasial dari "lobus otak" ini, yang menunjukkan bahwa fitur yang terjadi bersama juga lebih terkonsentrasi secara spasial, jauh melebihi ekspektasi distribusi acak.

Pada tingkat makro, para peneliti menemukan bahwa struktur keseluruhan cloud titik fitur LLM tidak isotropik, tetapi menunjukkan distribusi nilai eigen hukum kekuatan, dan distribusi ini paling jelas di lapisan perantara.

Para peneliti juga mengukur entropi pengelompokan pada tingkat yang berbeda dan menemukan bahwa entropi pengelompokan lapisan menengah lebih rendah, menunjukkan bahwa representasi fitur lebih terkonsentrasi, sedangkan entropi pengelompokan dari lapisan awal dan akhir lebih tinggi, menunjukkan bahwa representasi fitur tersebut lebih tersebar.

Studi ini memberikan perspektif baru bagi kita untuk memahami mekanisme internal model bahasa besar dan meletakkan dasar bagi pengembangan masa depan sistem AI yang lebih kuat dan lebih pintar.

Studi ini tidak hanya mengungkapkan kesamaan antara AI dan otak manusia, tetapi juga memberikan arah baru untuk pengembangan teknologi AI di masa depan, menunjukkan bahwa AI akan menjadi lebih pintar dan lebih efisien.