Dengan perkembangan cepat model bahasa besar multimodal (MLLM), tugas yang berhubungan dengan gambar dan video telah mengantarkan terobosan yang belum pernah terjadi sebelumnya, terutama di bidang tanya jawab visual, generasi naratif dan pengeditan interaktif. Namun, meskipun ada kemajuan yang signifikan dalam teknologi ini, mencapai pemahaman konten video berbutir halus tetap menjadi masalah yang sulit untuk diselesaikan. Tantangan ini melibatkan tidak hanya segmentasi tingkat piksel dan pelacakan dengan deskripsi bahasa, tetapi juga tugas-tugas kompleks seperti tanya jawab visual pada petunjuk video tertentu.

Meskipun model persepsi video canggih saat ini berkinerja baik dalam tugas-tugas segmentasi dan pelacakan, mereka masih tidak memadai dalam pemahaman bahasa terbuka dan kemampuan dialog. Video MLLMS, meskipun berkinerja baik dalam pemahaman video dan tugas tanya jawab, masih tidak dapat menangani tugas persepsi dan isyarat visual. Keterbatasan ini membatasi penggunaannya dalam berbagai skenario yang lebih luas.

Solusi yang ada terutama dibagi menjadi dua kategori: Model Bahasa Multimodal Besar (MLLM) dan sistem segmentasi referensi. MLLMS awalnya berfokus pada peningkatan metode fusi multimodal dan ekstraktor fitur, dan secara bertahap dikembangkan menjadi kerangka kerja untuk penyetelan instruksi pada LLMS, seperti LLAVA. Baru-baru ini, para peneliti telah mencoba menyatukan gambar, video, dan analisis multi-gambar menjadi satu kerangka kerja tunggal, seperti LLAVA-onevision. Pada saat yang sama, sistem segmentasi referensi juga mengalami transformasi dari modul fusi dasar ke segmentasi dan pelacakan yang terintegrasi. Namun, solusi ini masih memiliki kekurangan dalam integrasi komprehensif persepsi dan kemampuan pemahaman bahasa.

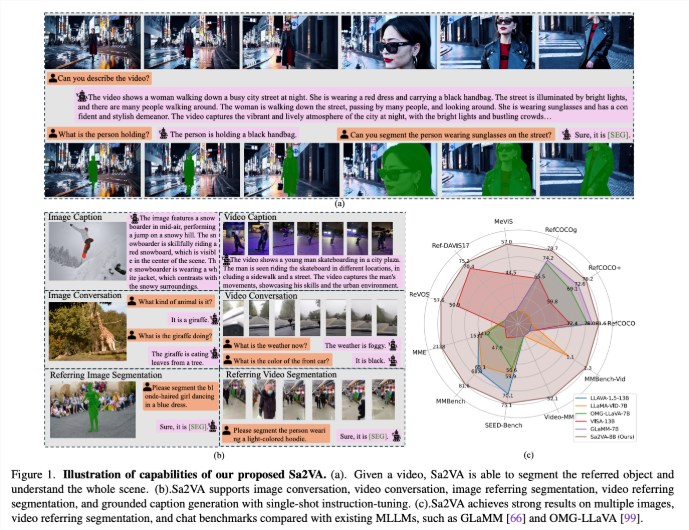

Para peneliti dari UC Merced, tim benih Bytedance, Universitas Wuhan dan Universitas Peking telah mengusulkan SA2VA, model terpadu inovatif yang dirancang untuk mencapai pemahaman dasar intensif tentang gambar dan video. Model ini mengatasi keterbatasan model bahasa multimoda besar yang ada dengan meminimalkan penyetelan instruksi satu kali dan mendukung berbagai tugas gambar dan video.

SA2VA secara inovatif mengintegrasikan SAM-2 dengan LLAVA untuk menyatukan teks, gambar, dan video menjadi ruang token LLM bersama. Selain itu, para peneliti telah meluncurkan dataset anotasi otomatis yang luas yang disebut Ref-SAV, yang berisi ekspresi objek dalam lebih dari 72K skenario video kompleks, dan 2K objek video yang diverifikasi secara manual untuk memastikan kemampuan pembandingan yang kuat.

Arsitektur SA2VA terutama terdiri dari dua bagian: model yang mirip dengan LLAVA dan SAM-2, dan mengadopsi desain decoupling baru. Komponen seperti LLAVA mencakup encoder visual yang memproses gambar dan video, lapisan proyeksi visual, dan LLM untuk prediksi token teks. Sistem ini mengadopsi metode decoupling unik yang memungkinkan SAM-2 untuk beroperasi di sebelah model LLAVA yang sudah terlatih tanpa pertukaran token langsung, sehingga mempertahankan efisiensi komputasi dan memungkinkan plug-in dan mencabut dengan berbagai koneksi MLLM yang sudah terlatih.

Hasil penelitian menunjukkan bahwa SA2VA mencapai hasil canggih dalam tugas segmentasi kutipan, dengan model SA2VA-8B-nya yang memiliki skor CIOU pada REFCOCO, REFCOCO+ dan REFCOCOG, masing-masing, melampaui sistem sebelumnya seperti Glamm-7b. Dalam hal kemampuan dialog, SA2VA mencapai hasil yang sangat baik dari 2128, 81.6 dan 75.1 masing-masing pada MME, mmbench, dan benih.

Selain itu, kinerja SA2VA dalam tolok ukur video secara signifikan melampaui keadaan sebelumnya-dari Visa-13b, menunjukkan efisiensi dan efektivitasnya dalam tugas pemahaman gambar dan video.

Kertas: https://arxiv.org/abs/2501.04001

Model: https://huggingface.co/collections/bytedance/sa2va-model-zoo-677e3084d71b5f108d00e093

Poin -Poin Kunci:

SA2VA adalah kerangka kerja AI terpadu baru yang mencapai pemahaman mendalam tentang gambar dan video dan mengatasi keterbatasan model multimodal yang ada.

Model ini telah mencapai hasil canggih dalam beberapa tolok ukur seperti segmentasi kutipan dan kemampuan dialog, menunjukkan kinerja yang luar biasa.

Desain SA2VA secara efektif mengintegrasikan kemampuan pemahaman visual dan bahasa melalui metode decoupling, mendukung berbagai tugas gambar dan video.