これは、SAM 2 Core ML モデル用の Swift デモ アプリです。

SAM 2 (Segment Anything in Images and Videos) は、画像とビデオの視覚的なセグメンテーションを迅速に解決することを目的とした FAIR の基礎モデルのコレクションです。詳細については、SAM 2 の論文を参照してください。

ここからコンパイル済みバージョンをダウンロードしてください。

自分でコンパイルしたい場合、またはより大きなモデルを使用したい場合は、リポジトリをダウンロードし、Xcode でコンパイルして実行するだけです。アプリには Small バージョンのモデルが付属していますが、サポートされているモデルのいずれかに置き換えることができます。

SAM 2.1 タイニー

SAM 2.1 小

SAM 2.1 ベース

SAM 2.1 大

古いモデルについては、HuggingFace で Apple 組織を確認してください。

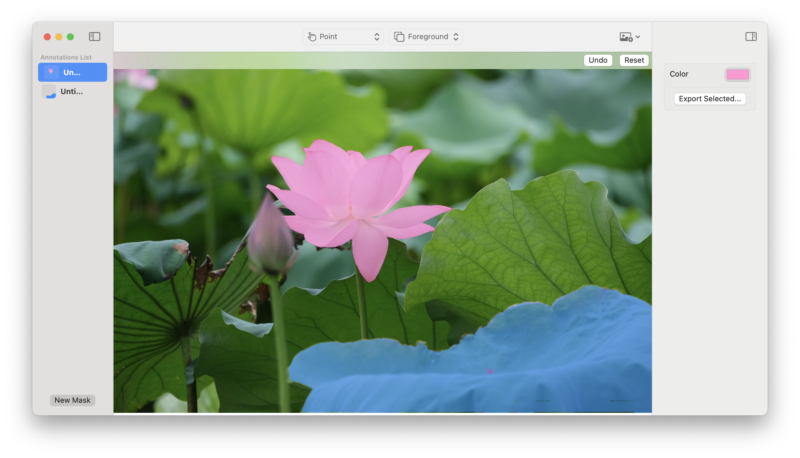

このデモは画像をサポートしていますが、ビデオのサポートは後で提供される予定です。

1 つまたは複数の前景点を選択して、画像内のオブジェクトを選択できます。追加の各ポイントは、前のマスクの改良として解釈されます。

背景ポイントを使用して、現在のマスクから削除する領域を示します。

ボックスを使用して、関心のあるオブジェクトを含むおおよその領域を選択できます。

微調整されたモデルを使用したい場合は、SAM 2 リポジトリのこのフォークを使用して変換できます。ぜひ、何に使うか教えてください!

フィードバック、問題点、PR などは大歓迎です。どうぞお気軽にご連絡ください。

SAM 2 の論文、モデル、またはソフトウェアを引用するには、以下を使用してください。

@article{ravi2024sam2,

title={SAM 2: Segment Anything in Images and Videos},

author={Ravi, Nikhila and Gabeur, Valentin and Hu, Yuan-Ting and Hu, Ronghang and Ryali, Chaitanya and Ma, Tengyu and Khedr, Haitham and R{"a}dle, Roman and Rolland, Chloe and Gustafson, Laura and Mintun, Eric and Pan, Junting and Alwala, Kalyan Vasudev and Carion, Nicolas and Wu, Chao-Yuan and Girshick, Ross and Doll{'a}r, Piotr and Feichtenhofer, Christoph},

journal={arXiv preprint arXiv:2408.00714},

url={https://arxiv.org/abs/2408.00714},

year={2024}

}