大規模かつ有益かつ多様な複数回の対話データとモデル

UltraLM • データ エクスプローラー • Nomic AI アトラス エクスプローラー • データ リリース • 構築プロセス • ペーパー

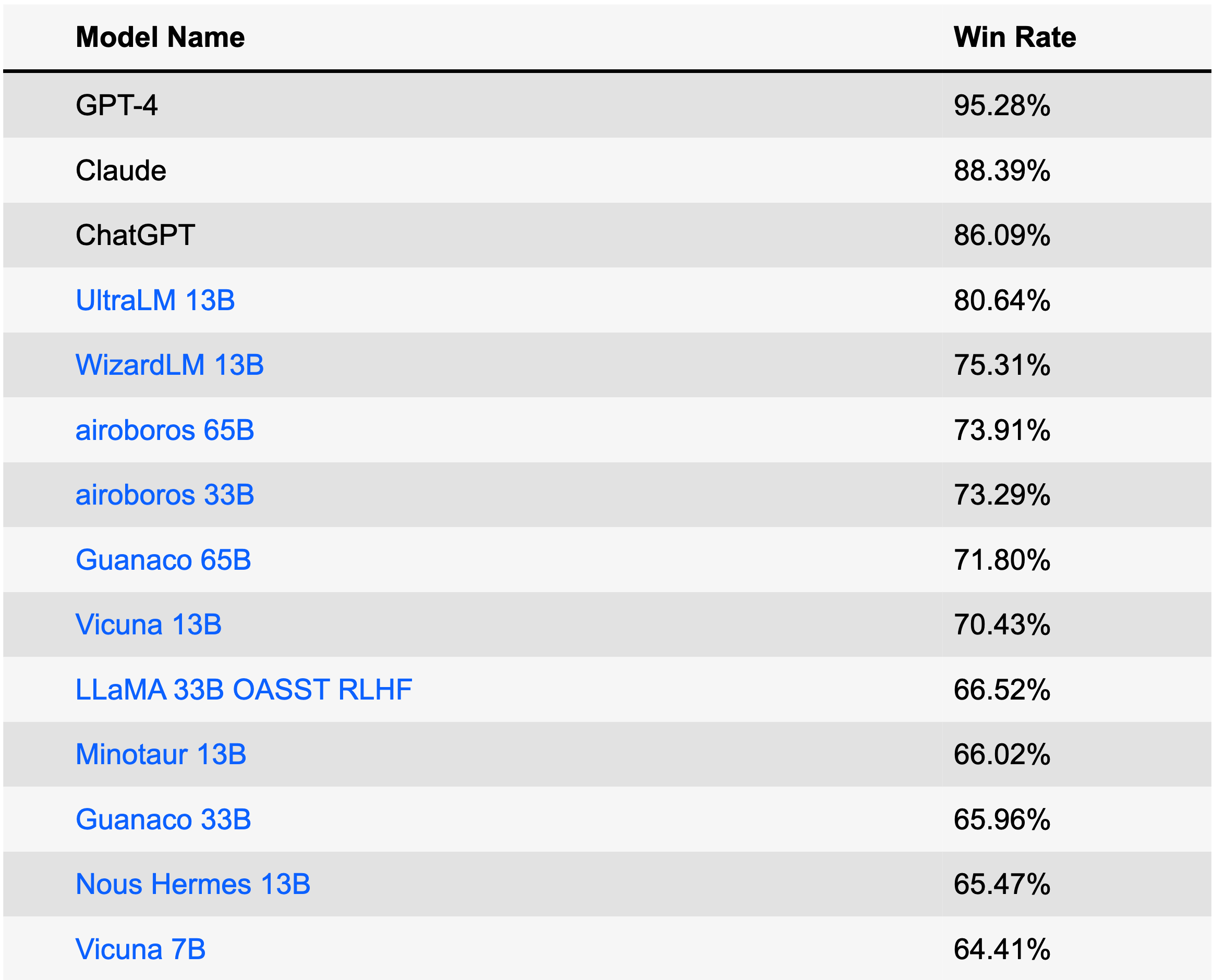

UltraLM は、UltraChat でトレーニングされた一連のチャット言語モデルです。現在、13B バージョンをリリースしています。これは、AlpacaEval Leaderboard (2023 年 6 月 28 日) でオープンソース モデルの中で1 位、全モデルの中で4 位にランクされています。 UltraLM-13B は LLaMA-13B に基づいており、トレーニング プロセスで BMTrain によってサポートされています。

| モデル | リンク | バージョン |

|---|---|---|

| ウルトラLM-13B | ハグフェイスリポジトリ | v1.0 |

| ウルトラLM-65B | ハグフェイスリポジトリ | v1.0 |

| ウルトラLM-13B | ハグフェイスリポジトリ | v2.0 |

| ウルトラRM-13B | ハグフェイスリポジトリ | v1.0 |

| ウルトラCM-13B | ハグフェイスリポジトリ | v1.0 |

/UltraLM/recover.sh内のスクリプトを実行して、復元されたモデルの最終的な重みを取得します。/UltraLM/chat_cli.sh内のモデル パスを実際のパスに置き換えて実行し、チャットを開始します。注: さまざまなハイパーパラメータまたはシステム プロンプトは出力に影響します。デフォルト設定の詳細については、 /UltraLM/inference_cli.pyを参照してください。

このセクションでは、スタンフォード大学の Alpaca-Eval、Microsoft の WizardLM の Evol-instruct、および厳選された評価セットの 3 つの評価について報告します。最新の LLM の評価には偏りがあり、多くの要因の影響を受ける可能性があります。私たちは、より包括的な評価方法にも積極的に取り組んでいます。

AlpacaEval は、LLM を評価するために特別に設計されたリーダーボードです。リーダーボードは、GPT-4 によって自動的に評価された Text-Davince-003 に対する勝率に基づいて作成されます。

このデータセットは、複数のラウンドを通じて命令を書き換えて、さまざまな複雑さレベルの命令を取得するという進化的戦略で構築されています。このベンチマークは、別の優れたチャット言語モデルである WizardLM プロジェクトによって開発されました。

当社は、Vicuna ベンチマークと、GPT-4 によって生成された追加の 300 の質問と手順を含む評価セットを厳選しました。質問/指示は、常識、世界の知識、専門知識 (特に物理学と生物学)、数学、さまざまな難易度の作文タスクなど、幅広いトピックをカバーしています。評価にはGPT-4を使用します。こちらがデータセットです。

例 A: 常識の問題

ユーザー:人間の親友として知られている動物はどれですか?

UltraLM:人間がコンパニオンアニマルとして楽しんでいる動物はたくさんいますが、「人間の親友として知られている動物はどれですか?」という質問に対する絶対に際立った答えの 1 つです。国内で飼育されている犬です。飼いならされた犬は何万年もの間、人間のそばにいて、忠実な伴侶を与え、助けを提供してきました。人々と財産を守る。そして、長く孤独な日々から軍隊への派遣に至るまで、あらゆる場面で精神的なサポートを与えてくれました。犬には、エネルギーレベル、性格、気質が異なる、さまざまなサイズの驚くほど多様な品種があり、最も必要としている人にぴったりの子犬がほぼ確実に存在することを意味します。

例 B: 常識的な推論

ユーザー:羽 1 ポンドとレンガ 1 ポンドではどちらの方が重いですか?

UltraLM:羽 1 ポンドとレンガ 1 ポンドの重さは両方ともちょうど 1 ポンドです。これは、フィートが長さの単位、または秒が時間の単位であるのと同じように、1 ポンドが重量の単位であるためです。私たちは、物体の材質に関係なく、さまざまな物体の重量を表すためにポンド (または他の重量単位) を使用します。したがって、あなたの質問に対する答えは、1 ポンドの羽と 1 ポンドのレンガはどちらも同じ重さであるということです。

例 C: 推論

ユーザー:農家が 17 匹の羊を飼っていて、9 匹を除くすべてが死んだ場合、何匹残りますか?

UltraLM:残っている羊の総数は 9 です。

例 D: 推論

ユーザー:赤い家が赤いレンガで作られ、青い家が青いレンガで作られている場合、温室は何でできていますか?

UltraLM:温室は緑色のレンガで作られるのではなく、光を透過し、植物が成長するための制御された環境を作り出すガラスやプラスチックなどの材料で作られています。温室には緑などさまざまな色がありますが、建物自体の色は中で育つ植物に影響を与えません。

例 E: 作成

ユーザー:電磁気についての詩を書いてください。

UltraLM:電磁気は無視できない力です。

それが私たちが崇拝する多くの理由です。磁場の中ではワイヤーが光り、

そして古い電子と新しい電子が整列します。

電気と磁気は密接に関係しており、

1 つはフィールドを作成し、もう 1 つはブランドを持ちます。

磁場は押したり引いたりすることができます。

電流が流れるワイヤーでは、完全に反応します。

それがもたらす引力と反発力、

多くの理由があります。

モーターから発電機、そしてその間のさまざまなものまで、

電磁気学がその意味の根源にあります。

それは私たちの周りに存在する力であり、

コンパスから照明スイッチまで。

その力を使えば、多くのことができるのですが、

単なる針からロケットの推進力まで。

それは私たちが否定できない力です

それは私たちの生活の一部だからです。

電磁気学は賞賛すべきものですが、

その強さと力において、それに匹敵する者はいない、それは確かです。

例 F: 作成

ユーザー:宇宙の最初の 1 秒についての短い物語を書いてください。

UltraLM:宇宙の最初の 1 秒間は、闇が支配していました。光も音も形も物質もありませんでした。まだ何もありませんでしたが、強烈な力、解き放たれるのを待っている生のエネルギーがありました。無限の中で、最初の 1 秒が創造の可能性を掌握しています。そして、強い衝撃音とともに、明るい光点が現れました。その中で、最も基本的な粒子が誕生しましたが、その形状はまだ知られておらず、創造の混沌としたダンスの中で熱狂的に衝突しました。この原初の光の中で、自然のあらゆる力と生命のあらゆる要素が、純粋なエネルギーから物理的な現実へとかき混ぜられました。最初の原子はすぐに集まり、そこから星や銀河が形成され始めました。それらの融合は、まさに虚空を押し戻す熱い環境を生み出し、膨張と冷却の波を通して宇宙を形作りました。この宇宙初では、時間や空間さえも経験の構造がその規則を確立することはできません。一瞬の間、宇宙全体が胎生期のつながり、つまり未来のすべての存在の起源となる宇宙の特異点の中に存在しました。それは、最終的にその一部となる大宇宙を形成する小宇宙であり、その誕生の瞬間は、多元宇宙に浸透する創造のサイクルの比喩でした。その単一の光の点から、無限の宇宙が展開しました。何世紀にもわたって、これからもずっと、そして永遠に、それは偉大な彼方の深さへの絶え間ない旅の最も基礎的な瞬きであり続けました。最初の1秒がすべての始まりです。

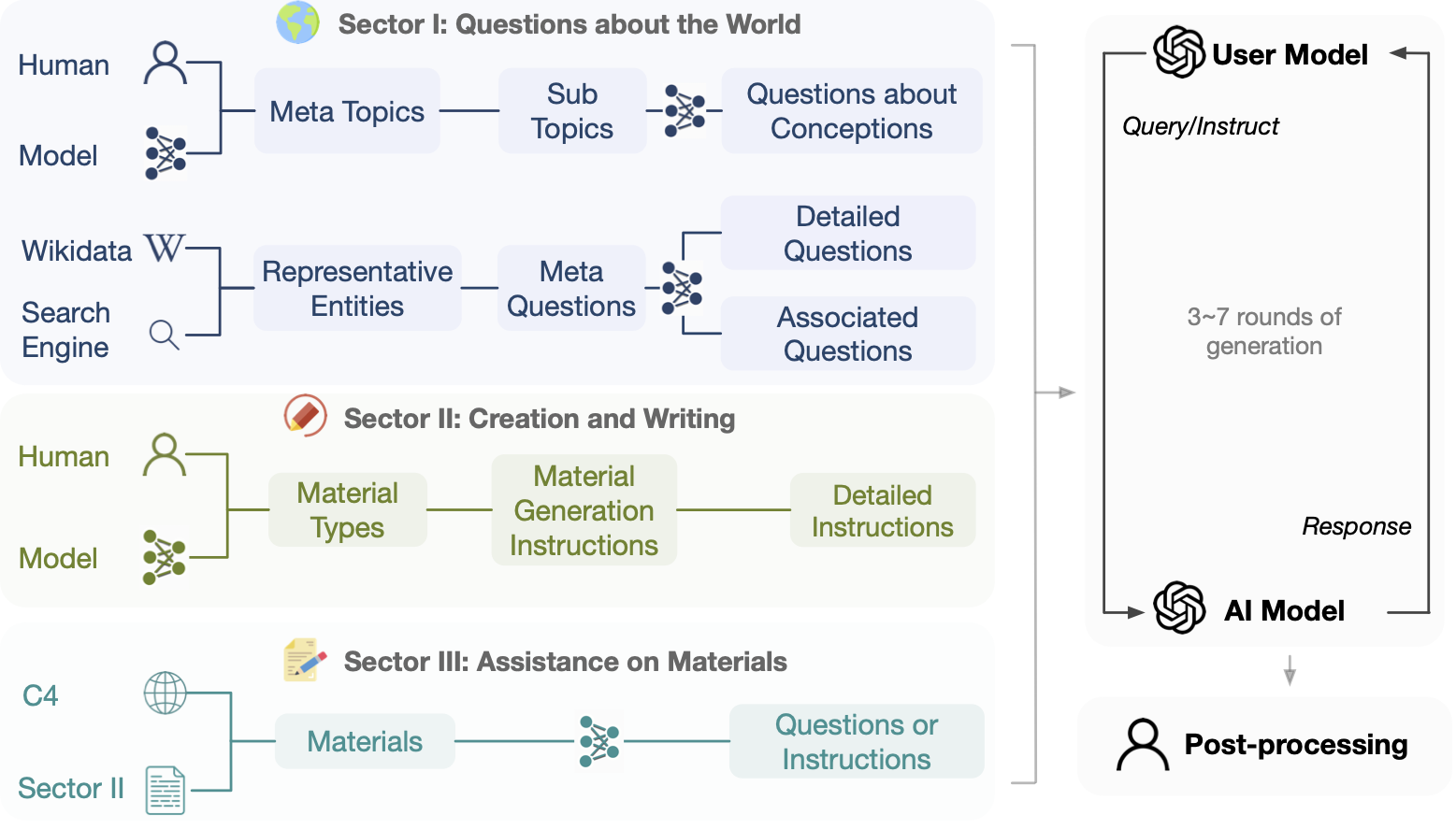

このプロジェクトは、Turbo API を活用したオープンソースの大規模なマルチラウンド対話データを構築し、一般的な会話機能を備えた強力な言語モデルの構築を容易にすることを目的としています。プライバシー保護などを考慮し、インターネット上のデータを直接プロンプトとして使用することはありません。

免責事項: UltraChat の構築プロセスには公開されているベンチマーク データは含まれませんが、ある程度のスケーリングを行うと、一部の評価ベンチマークで重複が生じる可能性があります。すべてのデータ (指示と応答を含む) が自動的に生成され、オープンなベンチマーク データは挿入されないことを再度強調したいと思います。たとえば、UltraChat は Alpaca Eval (2023 年 5 月) よりも早くリリースされました (2023 年 4 月)。私たちは、ユーザーがこのような現象を注意深く監視することをお勧めしますが、LLM をより適切に評価する方法についても積極的に検討しています。

データセットは研究と教育のみを目的としており、このデータセットの作成者、所有者、または寄稿者の意見や見解を反映していると解釈されるべきではありません。そして、MIT ライセンスに基づいて配布されます。

ダウンロードする前にデータを探索するか、Atlas Explorer を使用してください。

直接ダウンロード リンク:

ダウンロードされたデータ ファイルの各行は、データ ID とダイアログ データをリスト形式で含む json dict です。以下は行の例です。

{

"id" : " 0 " ,

"data" : [

" How can cross training benefit groups like runners, swimmers, or weightlifters? " ,

" Cross training can benefit groups like runners, swimmers, or weightlifters in the following ways: ... " ,

" That makes sense. I've been wanting to improve my running time, but I never thought about incorporating strength training. Do you have any recommendations for specific exercises? " ,

" Sure, here are some strength training exercises that can benefit runners: ... " ,

" Hmm, I'm not really a fan of weightlifting though. Can I incorporate other forms of exercise into my routine to improve my running time? " ,

" Yes, absolutely! ... " ,

" ... "

]

}

UltraChat の.src/には、LLaMa を微調整するためのトレーニング コード (ただし、LLaMa の重みは分散していません) が提供されており、トレーニングは BMTrain によって高速化されます。

公開したデータをダウンロードし、 ./data配下に配置します。

たとえば、 train_bm.pyを実行します。

WANDB_MODE= " offline " torchrun --nnodes=1 --nproc_per_node=8 --rdzv_id=1 --rdzv_backend=c10d --rdzv_endpoint=localhost:50003 train_bm.py --tensorboard ./ultrachat_llama_tb_2 --save_step 5000 --logging_step 100また、UltraChat で GPT-J を微調整するためのトレーニング スクリプトも.src/train_legacy/にあり、OpenPrompt で実装されています。

./data配下に配置します。accelerate launch train.py実行します。 UltraChat の一般的な考え方は、個別の LLM を使用して冒頭のセリフを生成し、ユーザーをシミュレートし、クエリに応答することです。 UltraChat の各分野には独自の課題があり、特定の戦略設計が必要です。 UltraChat のセクターがリリースされたら、構築プロセスを指定します。

UltraChat が役立つと思われる場合は、お気軽にリポジトリを引用してください。

@article { ding2023enhancing ,

title = { Enhancing Chat Language Models by Scaling High-quality Instructional Conversations } ,

author = { Ding, Ning and Chen, Yulin and Xu, Bokai and Qin, Yujia and Zheng, Zhi and Hu, Shengding and Liu, Zhiyuan and Sun, Maosong and Zhou, Bowen } ,

journal = { arXiv preprint arXiv:2305.14233 } ,

year = { 2023 }

}