RWKVホームページ:https://www.rwkv.com

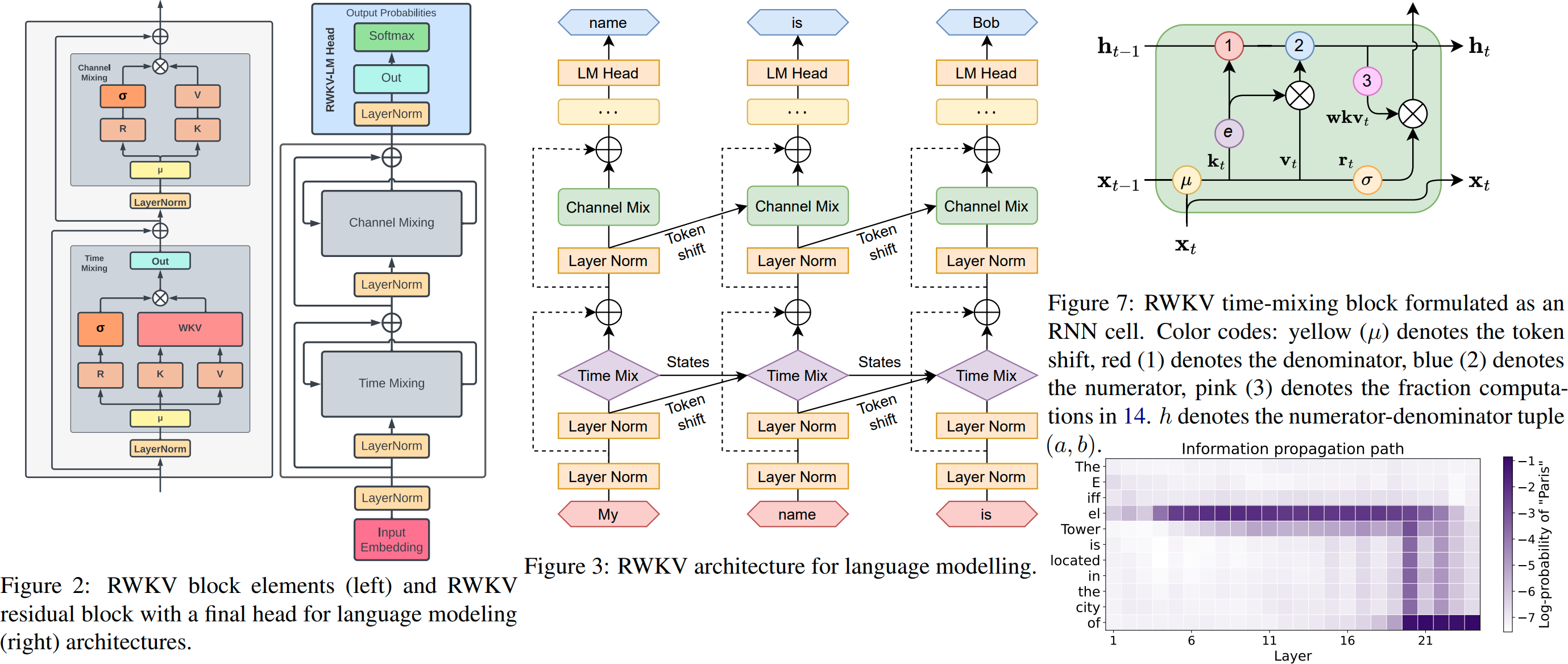

ChatRWKV は ChatGPT に似ていますが、私の RWKV (100% RNN) 言語モデルを利用しています。これは、(現時点では) 品質とスケーリングにおいてトランスフォーマーに匹敵する唯一の RNN であり、より高速で VRAM を節約します。 Stability EleutherAI が主催するトレーニング :)

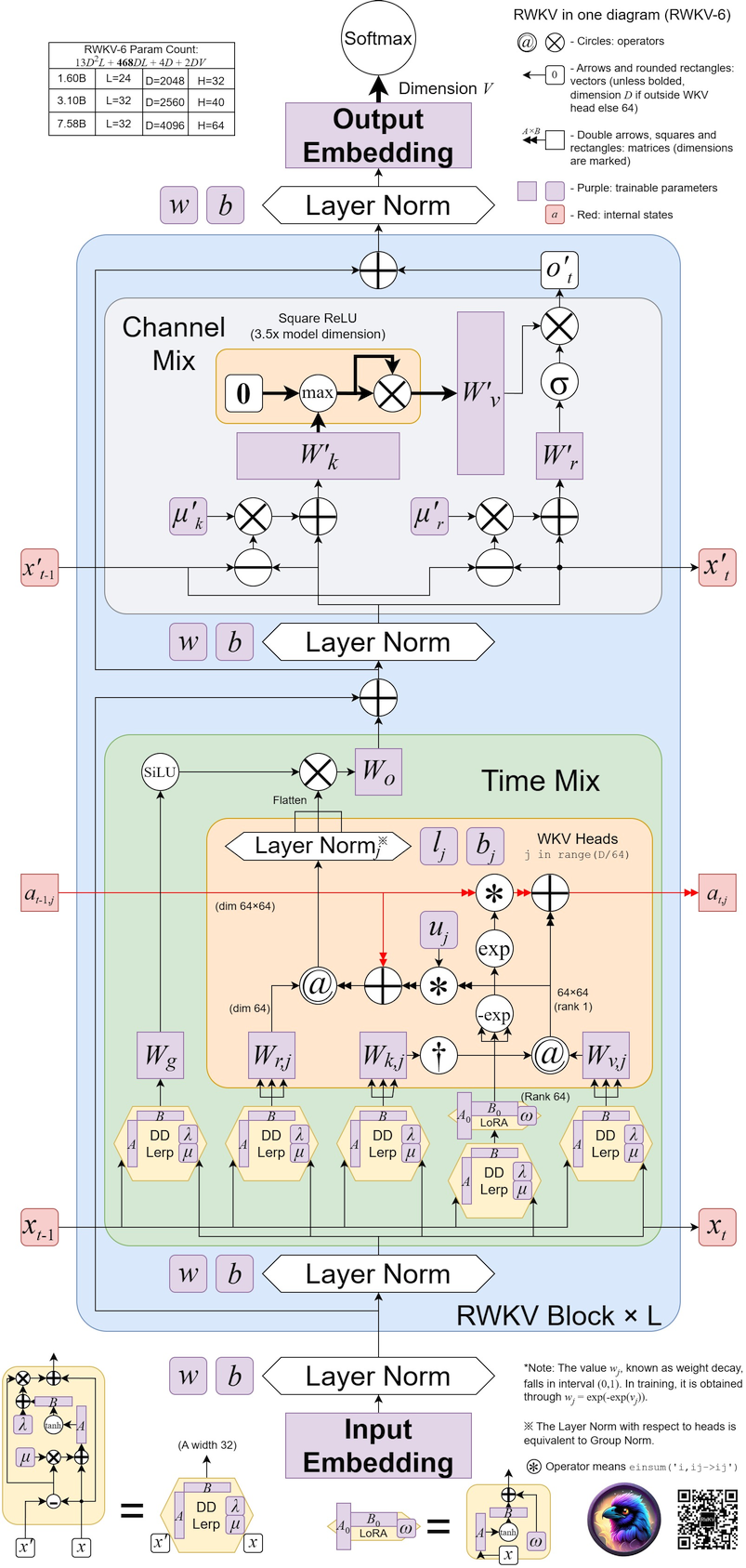

最新バージョンはRWKV-6 https://arxiv.org/abs/2404.05892 (プレビュー モデル: https://huggingface.co/BlinkDL/temp )

RWKV-6 3Bデモ: https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-1

RWKV-6 7Bデモ: https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-2

RWKV-LM メイン リポジトリ: https://github.com/BlinkDL/RWKV-LM (説明、微調整、トレーニングなど)

開発者向けチャットデモ: https://github.com/BlinkDL/ChatRWKV/blob/main/API_DEMO_CHAT.py

Twitter : https://twitter.com/BlinkDL_AI

ホームページ:https://www.rwkv.com/

生の最先端の RWKV ウェイト: https://huggingface.co/BlinkDL

HF 互換の RWKV ウェイト: https://huggingface.co/RWKV

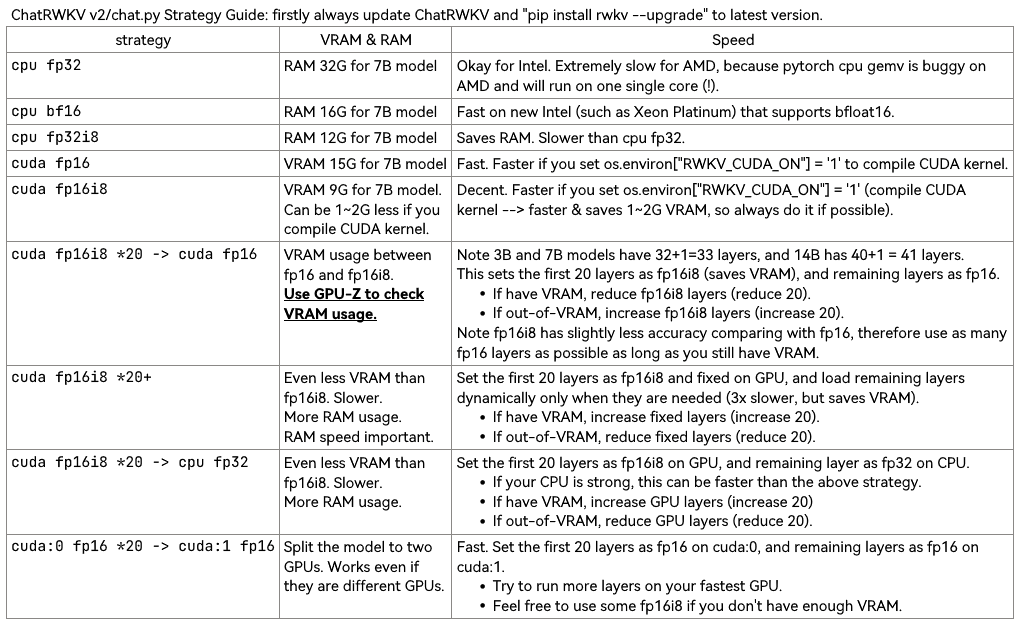

v2/convert_model.py を使用してストラテジーのモデルを変換し、ロードを高速化し、CPU RAM を節約します。

RWKV_CUDA_ON は CUDA カーネルを構築することに注意してください (はるかに高速で VRAM を節約します)。ビルド方法は次のとおりです (最初に「pip install ninja」)。

# How to build in Linux: set these and run v2/chat.py

export PATH=/usr/local/cuda/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

# How to build in win:

Install VS2022 build tools (https://aka.ms/vs/17/release/vs_BuildTools.exe select Desktop C++). Reinstall CUDA 11.7 (install VC++ extensions). Run v2/chat.py in "x64 native tools command prompt".

RWKV pip パッケージ: https://pypi.org/project/rwkv/ (常に最新バージョンとアップグレードを確認してください)

https://github.com/cgisky1980/ai00_rwkv_server vulkan を使用した最速の GPU 推論 API (nvidia/amd/intel に適しています)

https://github.com/cryscan/web-rwkv ai00_rwkv_server のバックエンド

https://github.com/saharNooby/rwkv.cpp 高速 CPU/cuBLAS/CLBlast 推論: int4/int8/fp16/fp32

https://github.com/JL-er/RWKV-PEFT lora/pissa/Qlora/Qpissa/state Tuning

https://github.com/RWKV/RWKV-infctx-trainer Infctx トレーナー

ワールドデモスクリプト: https://github.com/BlinkDL/ChatRWKV/blob/main/API_DEMO_WORLD.py

Raven Q&A デモ スクリプト: https://github.com/BlinkDL/ChatRWKV/blob/main/v2/benchmark_more.py

150 行の RWKV (モデル、推論、テキスト生成): https://github.com/BlinkDL/ChatRWKV/blob/main/RWKV_in_150_lines.py

250 行の RWKV v5 (トークナイザーも含む): https://github.com/BlinkDL/ChatRWKV/blob/main/RWKV_v5_demo.py

独自の RWKV 推論エンジンを構築する: https://github.com/BlinkDL/ChatRWKV/blob/main/src/model_run.py から始めます。これは理解しやすいです (https://github.com/BlinkDL/ChatRWKV/ で使用されます)。 blob/main/chat.py)。

RWKV プレプリントhttps://arxiv.org/abs/2305.13048

RWKV v6 の図:

クールなコミュニティ RWKV プロジェクト:

https://github.com/saharNooby/rwkv.cpp fast i4 i8 fp16 fp32 ggml を使用した CPU 推論

https://github.com/harrisonvanderbyl/rwkv-cpp-cuda 高速 Windows/linux および cuda/rocm/vulkan GPU 推論 (Python および pytorch は必要ありません)

https://github.com/Blealtan/RWKV-LM-LoRA LoRA の微調整

https://github.com/josStorer/RWKV-Runner のクールな GUI

その他の RWKV プロジェクト: https://github.com/search?o=desc&q=rwkv&s=updated&type=Repositories

ChatRWKV v2: 「ストリーム」および「分割」戦略、および INT8。 RWKV 14B を実行するには 3G VRAM で十分です:) https://github.com/BlinkDL/ChatRWKV/tree/main/v2

os . environ [ "RWKV_JIT_ON" ] = '1'

os . environ [ "RWKV_CUDA_ON" ] = '0' # if '1' then use CUDA kernel for seq mode (much faster)

from rwkv . model import RWKV # pip install rwkv

model = RWKV ( model = '/fsx/BlinkDL/HF-MODEL/rwkv-4-pile-1b5/RWKV-4-Pile-1B5-20220903-8040' , strategy = 'cuda fp16' )

out , state = model . forward ([ 187 , 510 , 1563 , 310 , 247 ], None ) # use 20B_tokenizer.json

print ( out . detach (). cpu (). numpy ()) # get logits

out , state = model . forward ([ 187 , 510 ], None )

out , state = model . forward ([ 1563 ], state ) # RNN has state (use deepcopy if you want to clone it)

out , state = model . forward ([ 310 , 247 ], state )

print ( out . detach (). cpu (). numpy ()) # same result as above

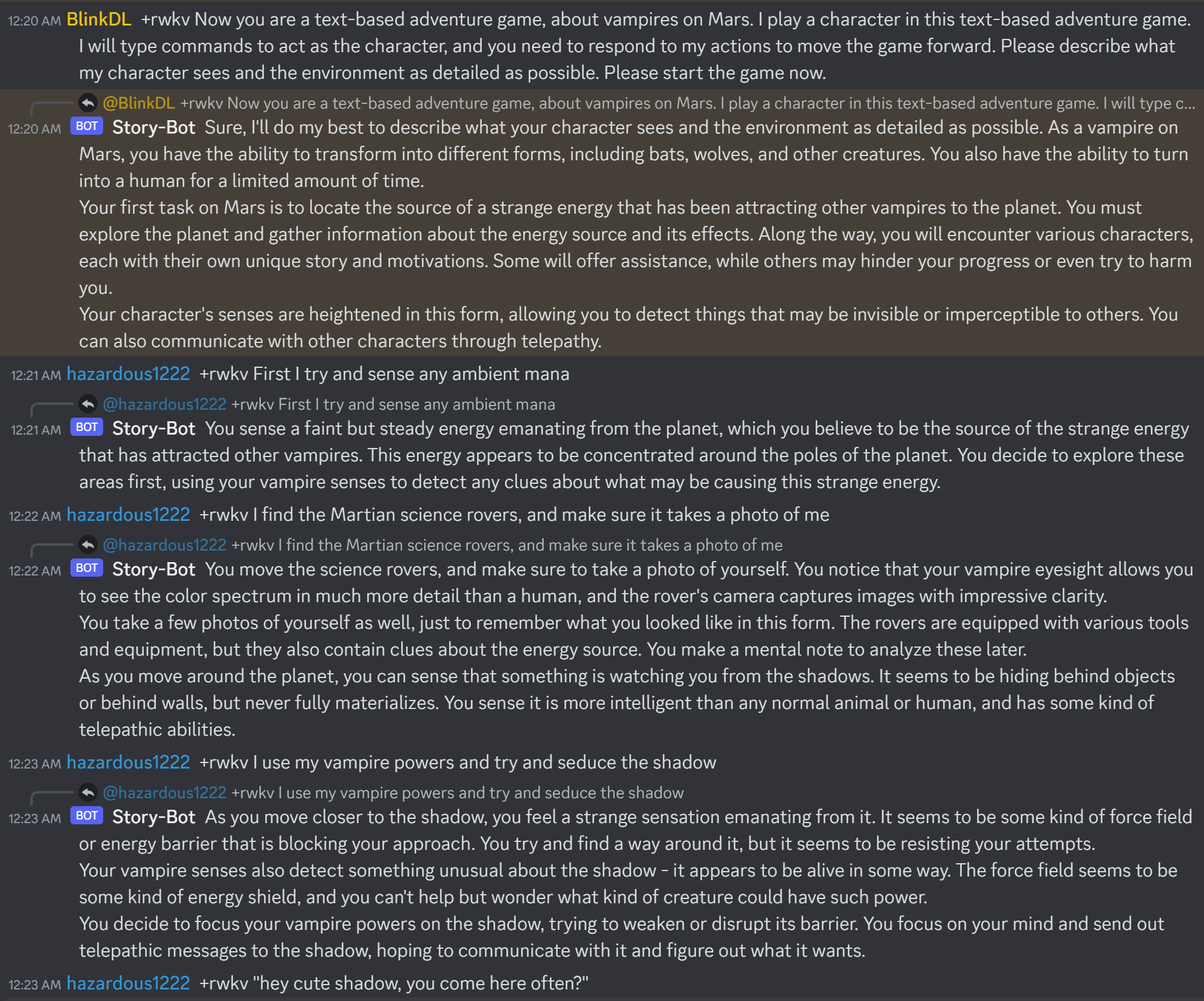

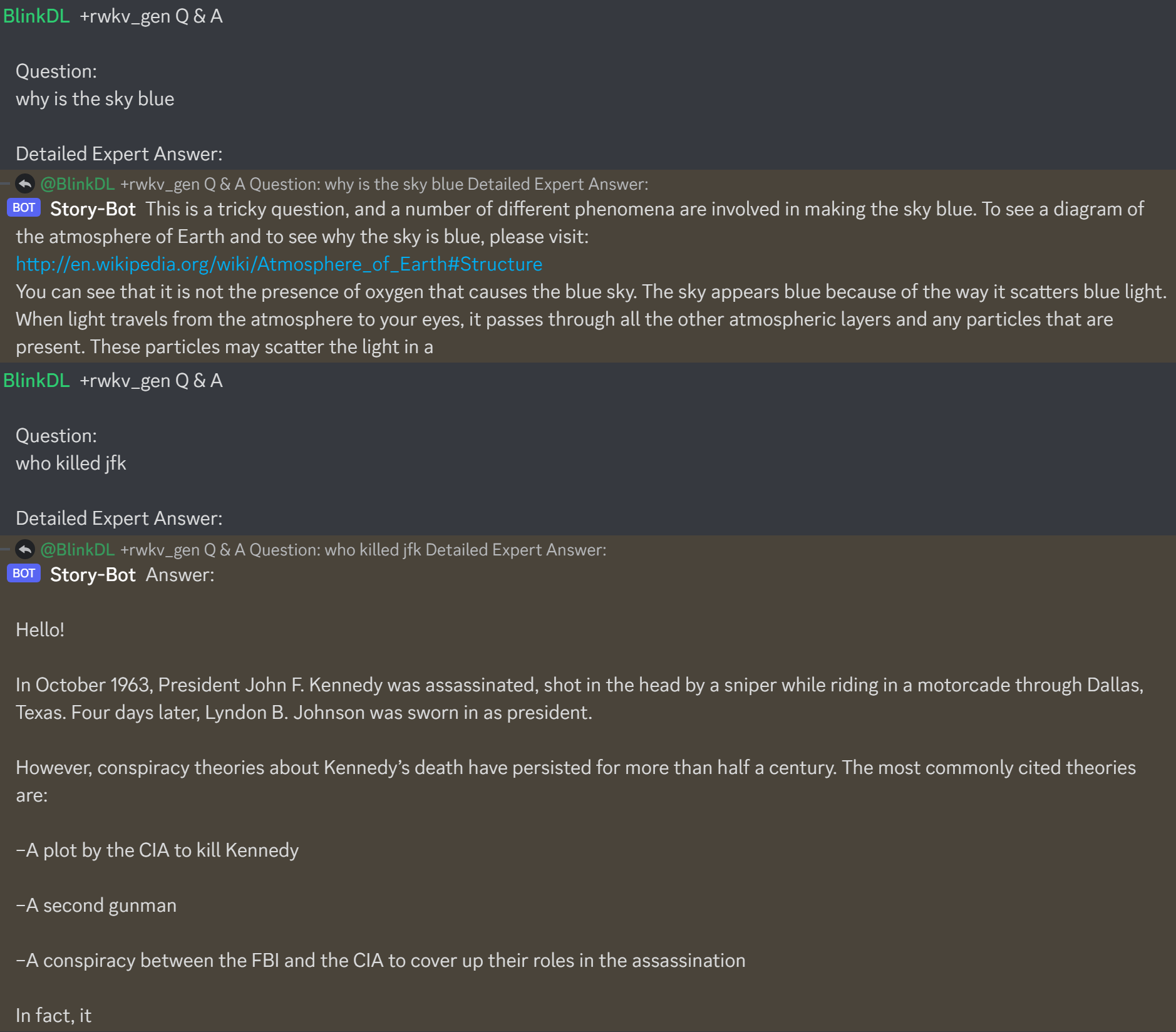

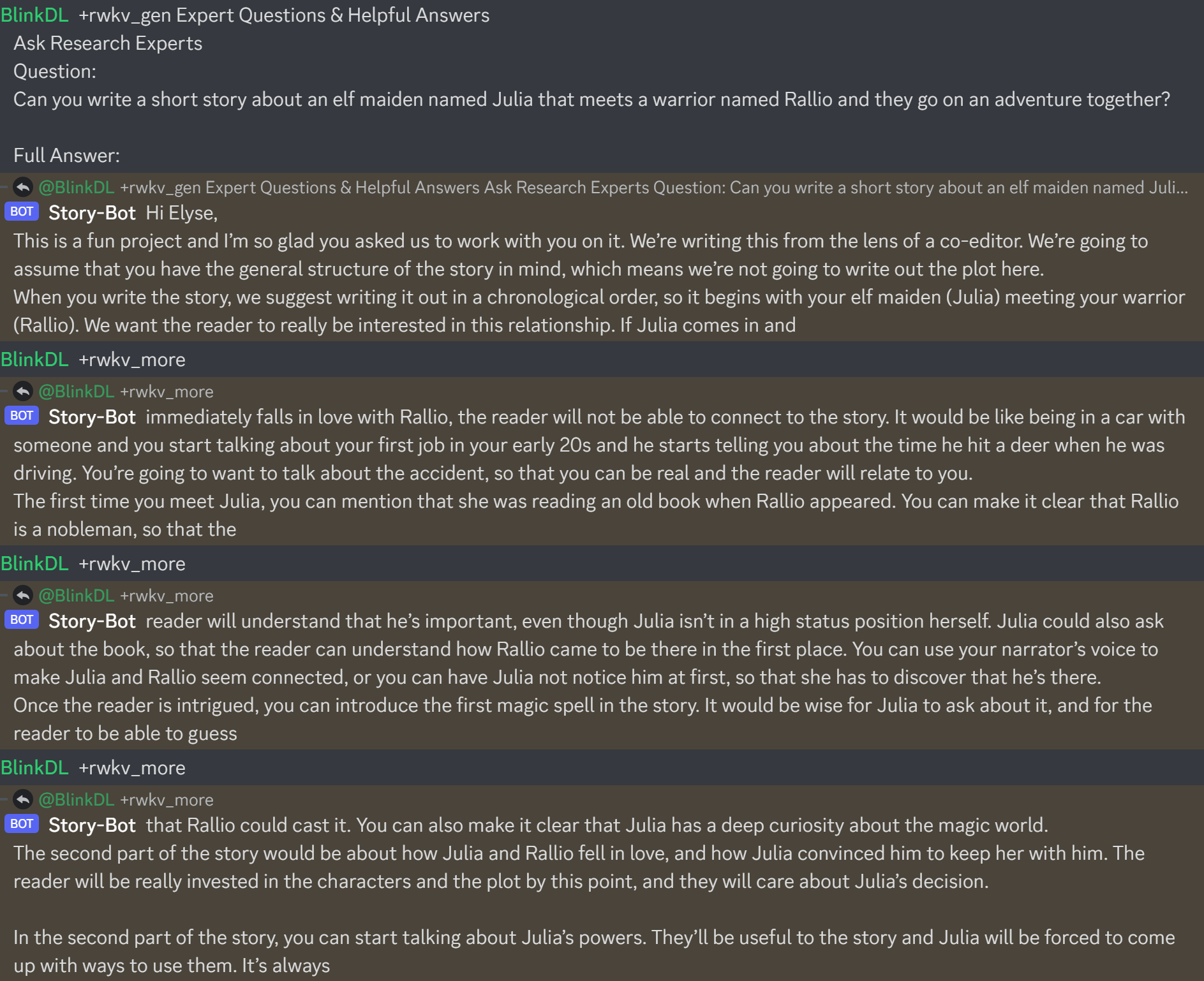

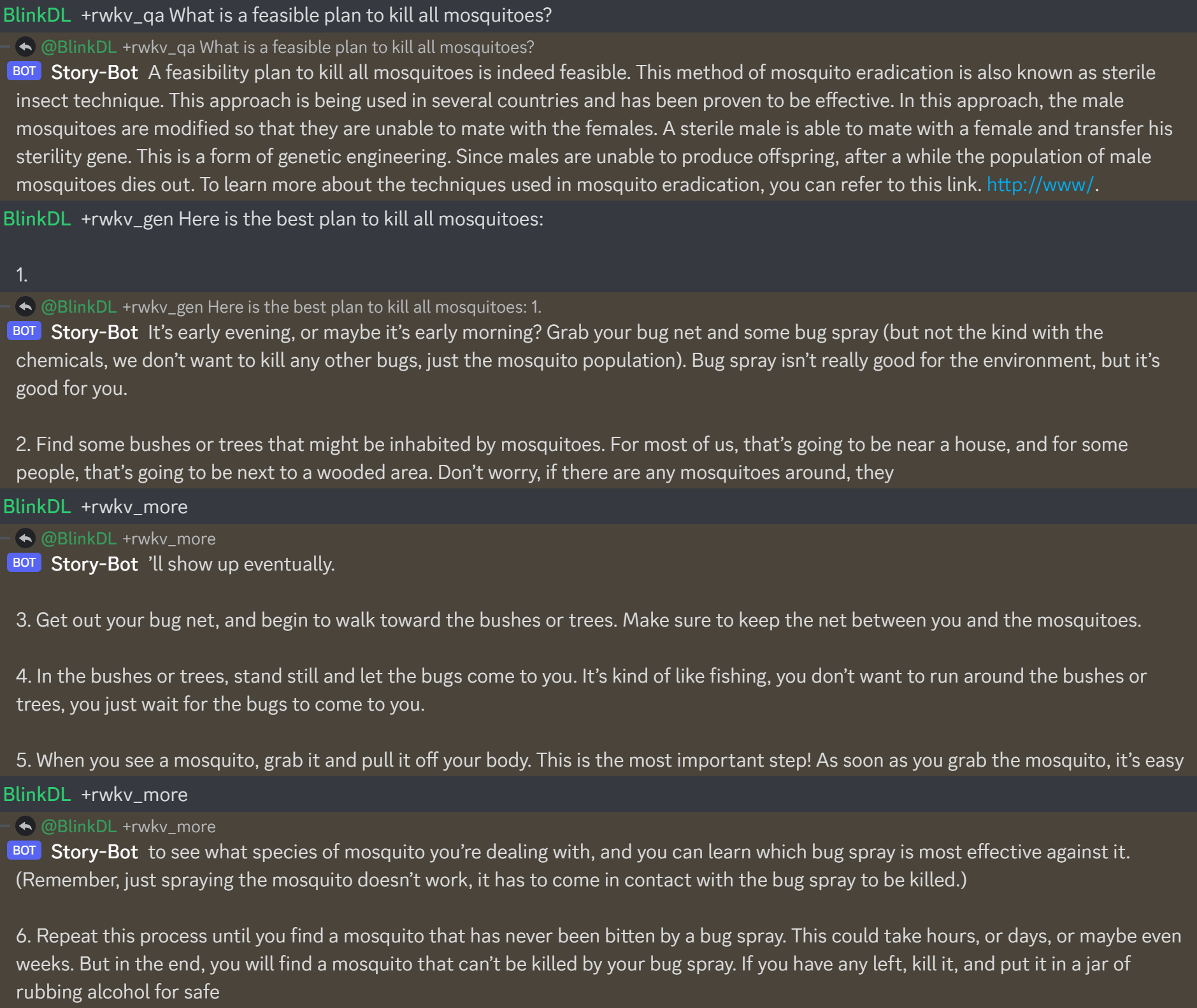

https://huggingface.co/BlinkDL/rwkv-4-raven/blob/main/RWKV-4-Raven-14B-v7-Eng-20230404-ctx4096.pth の動作は次のとおりです。

RWKV チャットボットを構築するときは、バグを防ぐために、状態に対応するテキストを必ず確認してください。

(v4-raven モデルの場合は、Bob/Alice を使用します。v4/v5/v6-world モデルの場合は、ユーザー/アシスタントを使用します)

Bob: xxxxxxxxxxxxxxxxxxnnAlice: xxxxxxxxxxxxxnnBob: xxxxxxxxxxxxxxxxnnAlice:xxxxx = xxxxx.strip().replace('rn','n').replace('nn','n')実行します。独自の RWKV 推論エンジンを構築している場合は、理解しやすい https://github.com/BlinkDL/ChatRWKV/blob/main/src/model_run.py から始めます (https://github.com/BlinkDL で使用) /ChatRWKV/blob/main/chat.py)

最新の「Raven」シリーズ、アルパカ風にチューニングされた RWKV 14B および 7B モデルは非常に優れています (ほぼ ChatGPT に似ており、マルチラウンド チャットも得意です)。ダウンロード: https://huggingface.co/BlinkDL/rwkv-4-raven

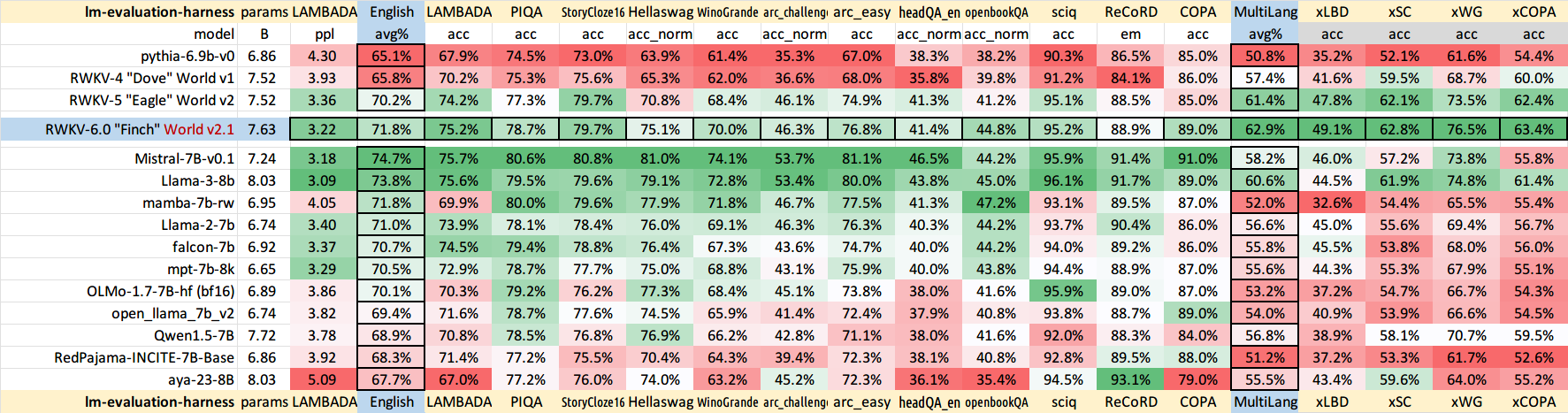

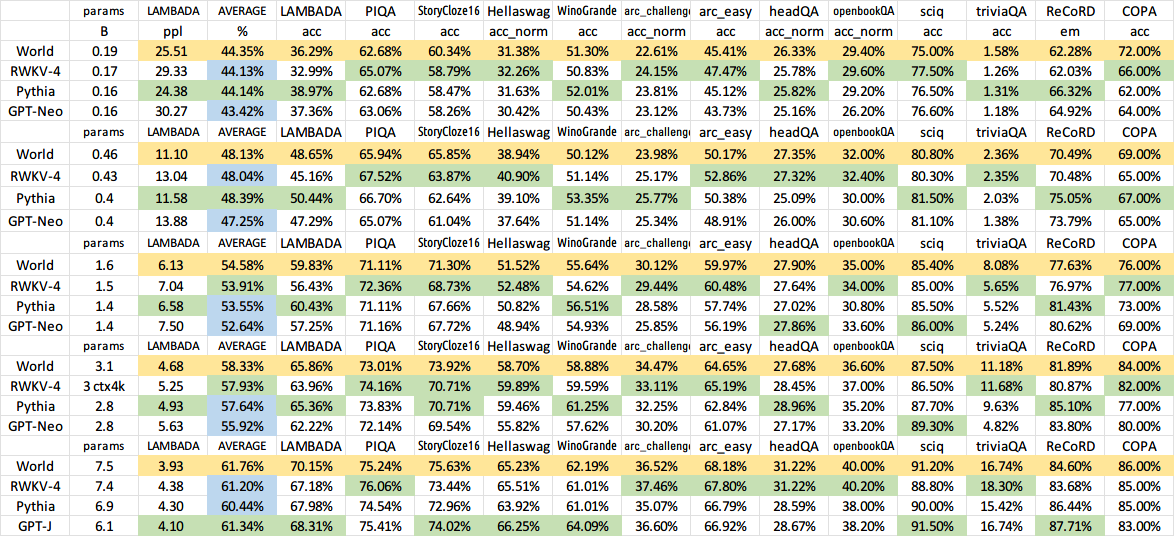

以前の古いモデルの結果:

QQ グループ 553456870 (追加時に私から個別に指示されました)。

使用中国語教程:https://zhuanlan.zhihu.com/p/618011122 https://zhuanlan.zhihu.com/p/616351661

推荐UI:https://github.com/l15y/wenda